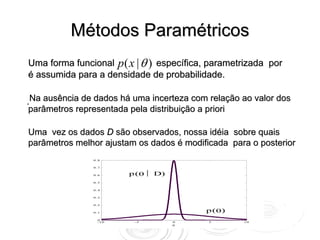

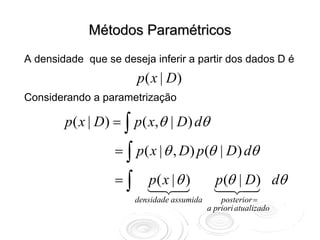

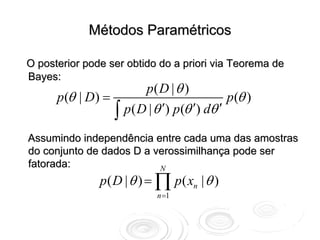

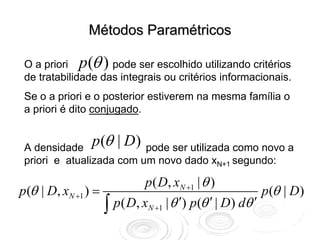

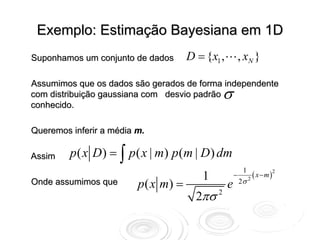

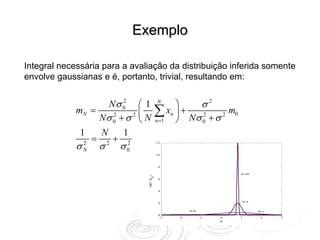

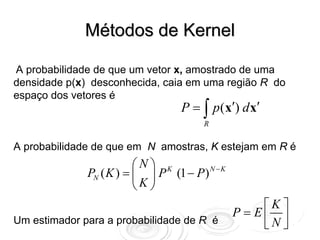

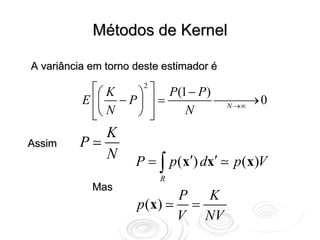

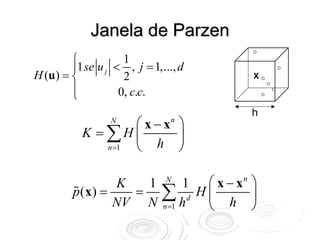

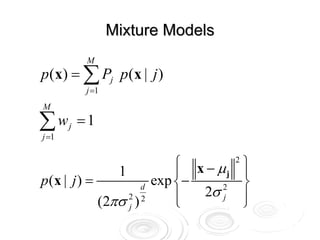

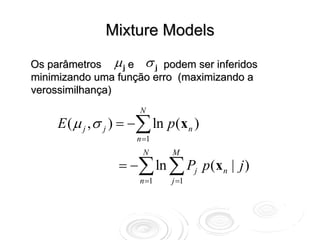

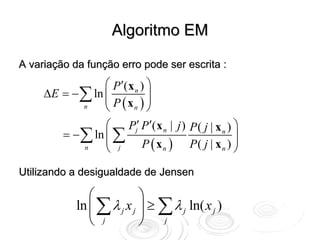

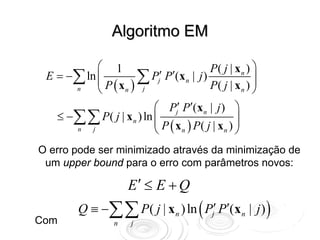

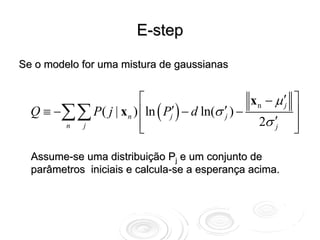

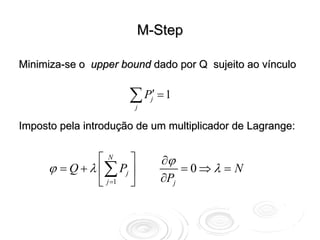

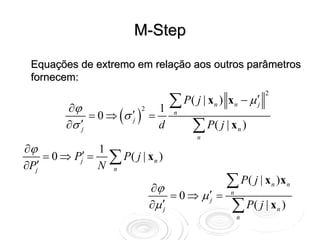

O documento discute métodos para estimar densidades de probabilidade a partir de dados, incluindo métodos paramétricos bayesianos, métodos de núcleo e misturas de distribuições. O algoritmo EM é descrito como uma abordagem para inferir parâmetros de misturas de distribuições maximizando a verossimilhança dos dados.