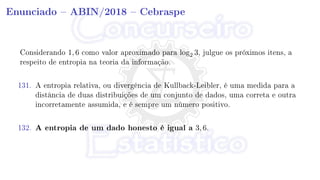

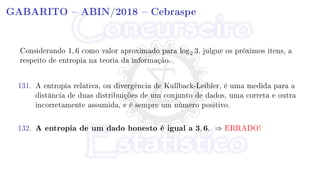

O documento discute a teoria da informação e o conceito de entropia de Shannon. Explica que a entropia quantifica a incerteza envolvida em uma variável aleatória e que para um dado honesto com 6 resultados igualmente prováveis, a entropia é igual a log2(6) ou aproximadamente 2,6 bits, e não 3,6 bits como afirmado no enunciado.