1. O documento apresenta conceitos fundamentais de álgebra linear como grupos, anéis e corpos, e ilustra esses conceitos com exemplos.

2. É introduzido o corpo dos números complexos C, definido como o conjunto {(a,b): a,b ∈ R} munido de operações de adição e multiplicação específicas.

3. Propriedades importantes dos números complexos são apresentadas, incluindo a representação na forma a + bi e operações como conjugação e módulo.

![Representação Trigonométrica dos Números Complexos

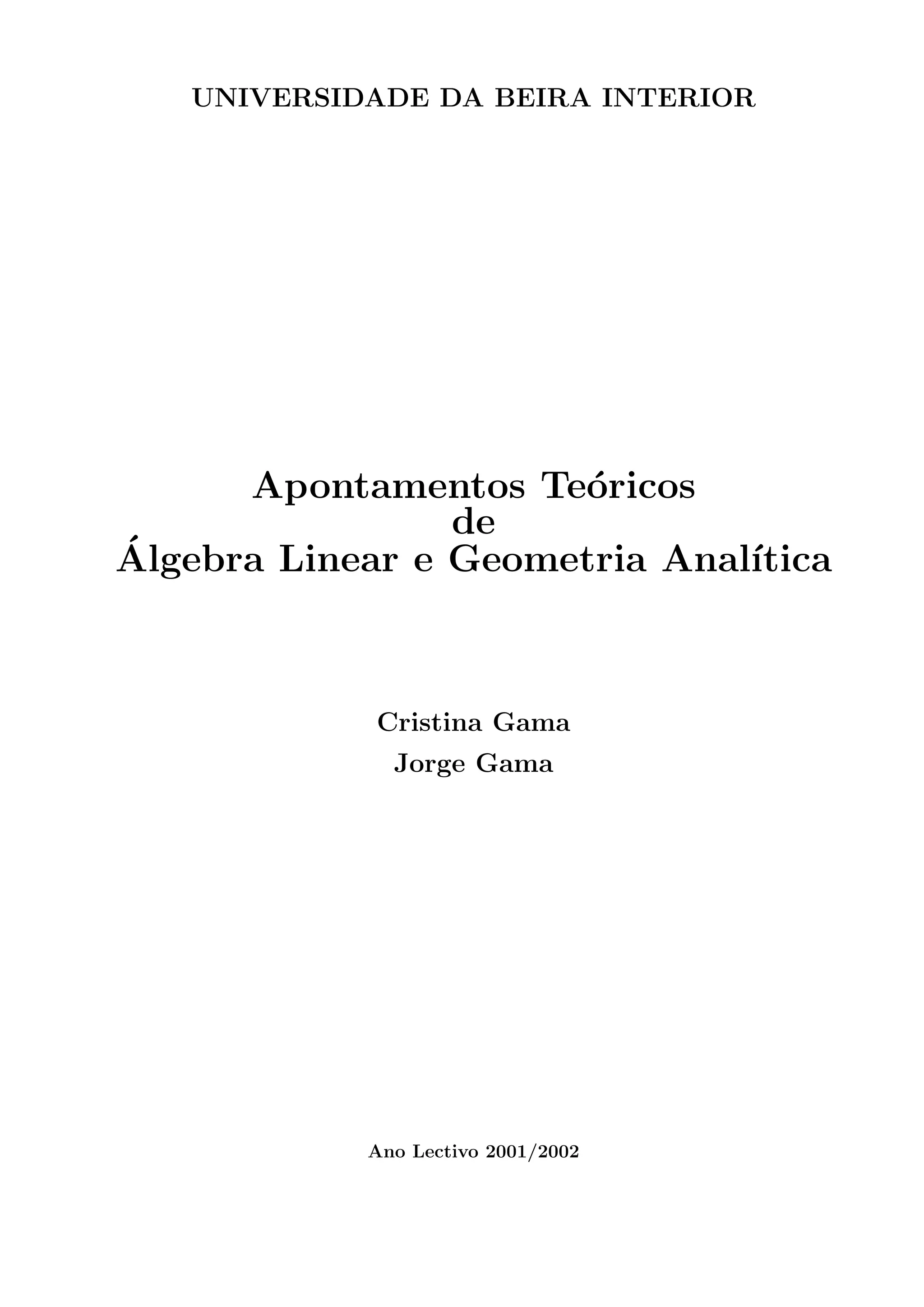

Já sabemos que dada uma recta orientada, existe uma correspondência biunı́voca entre

cada ponto da recta e o conjunto dos números reais, R. Assim, como identificamos o número

complexo (a, 0) com o número real a, os complexos da forma a + i0 serão representados na

recta.

Como representar, por exemplo, os imaginários puros? Repare-se que uma rotação de

180o

em torno da origem corresponde a uma multiplicação por −1. Ora, uma rotação de

90o

deverá corresponder a multiplicar por k de modo que k2

= −1. Logo, k terá que ser

a unidade imaginária i. Convencionaremos que o sentido positivo das rotações é o sentido

contrário ao dos ponteiros do relógio. Portanto, passaremos a representar os números reais

num eixo horizontal (eixo real) e os imaginários puros num eixo vertical (eixo imaginário).

Assim, um ponto P do plano de abcissa a e ordenada b será a imagem do complexo z = a+bi.

-

6

r

O

P

a

b

ρ

θ

Plano de Argand

Sabemos que o comprimento OP é o número real |z| =

√

a2 + b2 (Teorema de Pitágoras).

Representemos este número por ρ. Repare-se que o ponto P fica bem definido se consider-

armos ρ e o ângulo θ que o segmento [OP] faz com a parte positiva do eixo real.

Chama-se argumento principal ao ângulo θ ∈] − π, π]. Assim, a imagem do complexo

z fica bem definida se conhecermos ρ := |z| e θ := arg(z). Observe-se que se fizermos

θ = arg(z) + 2kπ, k ∈ Z, obtemos sempre a mesma imagem. Portanto, a cada complexo

podemos associar uma infinidade de argumentos. Além do principal, o argumento positivo

mı́nimo de z = a + bi é tal que θ ∈ [0, 2π[ e tg θ =

b

a

.

Observe a figura anterior para concluir que para todo o complexo z = a + bi,

a = ρ cos θ

b = ρ sen θ

Assim, a forma trigonométrica de z é

z = ρ(cos(θ) + i sen(θ)).

Abreviadamente, z = ρ cis(θ).

Se z ∈ C é tal que z = a + bi = ρ cis(θ), então z = a − bi = ρ cis(−θ).

6](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-7-320.jpg)

(1 ≤ i ≤ m, 1 ≤ j ≤ n)

ou, apenas, por A.

Duas matrizes A = [aij] e B = [bij] dizem-se iguais se, e somente se, são do mesmo tipo

e aij = bij, para todos os valores de i e j.

Designa-se por MK(m, n) o conjunto de todas as matrizes sobre o corpo K e de ordem

(m, n) (m linhas, n colunas).

Se K = R, a matriz diz-se real. Se K = C, a matriz diz-se complexa.

Matrizes Especiais

Seja A = [aij] ∈ MK(m, n).

1. Se n = 1, a matriz A diz-se matriz coluna.

a11

a21

.

.

.

am1

2. Se m = 1, a matriz A diz-se matriz linha.

a11 a12 · · · a1n

10](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-11-320.jpg)

![3. Se m = n, a matriz A diz-se quadrada de ordem n.

a11 a12 · · · a1n

a21 a22 · · · a2n

.

.

. · · · · · · · · ·

an1 an2 · · · ann

Numa matriz quadrada, os elementos a11, a22, . . . , ann dizem-se elementos principais

ou diagonais e formam a primeira diagonal ou diagonal principal. Os elementos

a1n, a2,n−1, . . . , an1 formam a segunda diagonal ou diagonal secundária.

Diagonal Principal Diagonal Secundária

3.1 Uma matriz quadrada A diz-se triangular superior se aij = 0, para i j.

Exemplo:

−2 1 3

0 4 −1

0 0 −5

3.2 Uma matriz quadrada A diz-se triangular inferior se aij = 0, para i j.

Exemplo:

2 0 0

−1 3 0

7 4 −2

3.3 Uma matriz quadrada A diz-se diagonal se aij = 0, para i 6= j.

Exemplo:

−1 0 0 0

0 3 0 0

0 0 5 0

0 0 0 −1

3.4 Uma matriz quadrada A diz-se escalar se é diagonal e aii = a 6= 0, para todo o i.

Exemplo:

3 0 0 0

0 3 0 0

0 0 3 0

0 0 0 3

Utilizando-se o sı́mbolo de Kronecker, δij, definido por

δij =

0, se i 6= j,

1, se i = j,

uma matriz escalar pode representar-se apenas por [aδij].

11](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-12-320.jpg)

![Exemplo:

3 0 0 0

0 3 0 0

0 0 3 0

0 0 0 3

= [3δij]

A matriz identidade é a matriz escalar [δij]. Designa-se, em geral, por In.

I1 = [1] I2 =

1 0

0 1

I3 =

1 0 0

0 1 0

0 0 1

I4 =

1 0 0 0

0 1 0 0

0 0 1 0

0 0 0 1

. . .

4. Uma matriz formada por r linhas (r ≤ m) e s colunas (s ≤ n) de uma matriz A diz-se

uma submatriz de A do tipo r × s.

Exemplo:

A matriz

2 0

−1 4

é submatriz de

2 0 4 1

−1 4 −3 0

5 −6 8 1/2

.

5. A matriz A diz-se matriz nula se todos os elementos são nulos (aij = 0, para todos

os valores de i e j). Designa-se a matriz nula por 0m×n, ou simplesmente por 0, se não

houver ambiguidade quanto ao seu tipo.

Exemplo:

0 0 0

0 0 0

0 0 0

6. A matriz oposta da matriz A = [aij](m,n) é uma matriz do mesmo tipo definida por

−A = [−aij] .

Exemplo:

A =

−1 2

3 5

1/2 −

√

2

− A =

1 −2

−3 −5

−1/2

√

2

7. Denomina-se matriz transposta de A a matriz AT

que se obtém de A trocando orde-

nadamente as linhas por colunas e as colunas por linhas. Se A é do tipo m × n, AT

é do

tipo n × m.

Exemplo:

A =

2 −5 7

−3 2 1

AT

=

2 −3

−5 2

7 1

Propriedade 2.2 AT

T

= A.

12](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-13-320.jpg)

![Propriedades 2.4

1. (A∗

)T

= A.

2. (A∗) = AT

.

3. (A∗

)∗

= A.

12. Uma matriz A diz-se hermı́tica ou hermitiana se é igual à sua associada, isto é, se

A = A∗

.

Logo, os seus elementos verificam a relação aij = aji e é uma matriz quadrada.

Em particular, para i = j, tem-se aii = aii = a ∈ R, isto é, aii é um número real.

Exemplo:

5 5 + 2i 3i 0

5 − 2i −1 9 2 − i

−3i 9 7 7 + 2i

0 2 + i 7 − 2i −4

13. Uma matriz A diz-se hemi-hermı́tica ou hemi-hermitiana se satisfaz a relação

A = −A∗

.

Logo, os seus elementos verificam a relação aij = −aji e é uma matriz quadrada.

Em particular, para i = j, tem-se aii = −aii, isto é, Re(aii) = 0.

Exemplo:

5i 5 5 − i 3 − 2i

−5 −2i 2 + i 9i

−5 − i −2 + i 7i 9

−3 − 2i 9i −9 −i

Operações com Matrizes

1. Adição: Sejam A = [aij], B = [bij] ∈ MK(m, n). Define-se adição de A com B como

sendo a matriz S = A + B ∈ MK(m, n) cujos elementos são obtidos pela relação

sij = aij + bij.

Exemplo:

2 6 0

−1 4 7

+

1 0 4

−4 1 −3

=

3 6 4

−5 5 4

Propriedades 2.5 (Adição de Matrizes)

a) A adição de matrizes é comutativa, isto é,

∀A, B ∈ MK(m, n), A + B = B + A.

14](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-15-320.jpg)

![b) A adição de matrizes é associativa, isto é,

∀A, B, C ∈ MK(m, n), (A + B) + C = A + (B + C).

c) A adição de matrizes tem elemento neutro, a matriz nula

0 · · · 0

.

.

. · · ·

.

.

.

0 · · · 0

(m,n)

d) Todas as matrizes em MK(m, n) têm oposto. O elemento oposto de A ∈ MK(m, n) é

a matriz −A ∈ MK(m, n).

∴ (MK(m, n), +) é um grupo abeliano.

e) Sejam A1, A2, . . . , Ap ∈ MK(m, n). Então

(A1 + A2 + · · · + Ap)T

= AT

1 + AT

2 + · · · + AT

p .

f) Se A ∈ MC(n, n), então A + A∗

é hermı́tica e A − A∗

é hemi-hermı́tica.

g) Se A ∈ MK(n, n), então A + AT

é simétrica e A − AT

é anti-simétrica.

2. Multiplicação de uma Matriz por um Escalar:

Sejam A = [aij] ∈ MK(m, n) e λ ∈ K. É usual denominar qualquer elemento de um

corpo por escalar. Define-se produto do escalar λ pela matriz A como sendo a matriz

λA = [λaij].

Exemplo:

Se A =

2 5 7

1 0 −2

e λ = 2, então λA =

4 10 14

2 0 −4

.

Propriedades 2.6 Sejam A, B ∈ MK(m, n) e α, β ∈ K.

i) 1 · A = A;

ii) α(βA) = (αβ)A = β(αA);

iii) (α + β)A = αA + βA;

iv) α(A + B) = αA + αB;

v) Se K = C e m = n, uma matriz A pode exprimir-se como soma de uma matriz

hermı́tica e uma hemi-hermı́tica, ou de uma matriz simétrica e outra anti-simétrica.

3. Multiplicação de Matrizes:

Sejam A = [aik] ∈ MK(m, p) e B = [blj] ∈ MK(p, n). As matrizes A e B dizem-

-se encadeadas porque o número de colunas de A é igual ao número de linhas de B.

Define-se multiplicação da matriz A pela matriz B como sendo uma matriz C do tipo

m × n, cujos elementos cij satisfazem a igualdade

cij =

p

X

k=1

aikbkj,

15](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-16-320.jpg)

![Qualquer destas matrizes tem r filas independentes e quaisquer r + 1 filas passam a ser

dependentes. Logo, Car A = r.

Aplicação à Resolução de Sistemas de Equações Lineares

Considere-se um sistema de m equações com n incógnitas:

a11x1 + a12x2 + · · · + a1nxn = b1

· · · · · · · · · · · · · · · · · ·

am1x1 + am2x2 + · · · + amnxn = bm

Observe-se que fazendo

A =

a11 a12 · · · a1n

a21 a22 · · · a2n

.

.

. · · · · · · · · ·

am1 am2 · · · amn

(Matriz dos Coeficientes),

B =

b1

b2

.

.

.

bm

(Matriz dos Termos Independentes) e X =

x1

x2

.

.

.

xn

,

o sistema de equações é equivalente à equação matricial AX = B.

Sabemos que as operações elementares transformam o sistema dado num sistema equiva-

lente. Assim, podemos encontrar a(s) solução(ões), caso exista(m), aplicando o método de

condensação à matriz ampliada ou completa:

[A|B] =

a11 · · · a1n | b1

.

.

. · · ·

.

.

. |

.

.

.

am1 · · · amn | bm

.

Atenção: A troca de duas colunas em A correspondem a uma troca de incógnitas.

Condensando [A|B], ou melhor, condensando A, até determinar a sua caracterı́stica r,

temos:

1o

Caso: m = n = r

α11 α12 · · · α1n | β1

0 α22 · · · α2n | β2

· · ·

...

... · · · |

.

.

.

0 · · · 0 αnn | βn

19](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-20-320.jpg)

![3o

Caso: Se r m, temos que

α11 α12 · · · α1r | · · · α1n | β1

0 α22 · · · α2r | · · · α2n | β2

· · ·

... ... · · · | · · · · · · |

.

.

.

0 · · · 0 αrr | · · · αrn | βr

−− −− −− −− | −− −− | −−

0 · · · · · · 0 | 0 · · · · · · 0 | βr+1

· · · · · · · · · · · · | · · · · · · |

.

.

.

0 · · · · · · 0 | 0 · · · · · · 0 | βm

e duas possibilidades:

1. βr+1 = · · · = βm = 0;

2. βr+1, . . . , βm não todos nulos.

1. Se as últimas m − r linhas somente têm elementos nulos, as equações transformam-se em

0 = 0. Logo, fica

α11 α12 · · · α1r | · · · α1n | β1

0 α22 · · · α2r | · · · α2n | β2

· · ·

...

... · · · | · · · · · · |

.

.

.

0 · · · 0 αrr | · · · αrn | βr

e tal como antes,

sistema possı́vel

determinado, se r = n,

indeterminado, se r n, com grau de indeterminação n − r.

2. Se nas últimas equações algum βj 6= 0, obtemos 0x1 + 0x2 + · · · + 0xn = βj. Logo, o

sistema é impossı́vel. Neste caso, a caracterı́stica de [A|B] é maior que r, isto é, maior

do que a caracterı́stica de A.

Em Resumo:

Sistema Possı́vel: Car A = Car[A|B]

Sistema Possı́vel

Determinado, se Car A = n,

Indeterminado, se Car A n, com grau de indeterminação

n − Car A.

Sistema Impossı́vel: Car A Car[A|B]

Exercı́cios:

1. Resolva e classifique o seguinte sistema:

2x − y − z = 1

x + y − z = 2

−x + 2y + 2z = 4

21](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-22-320.jpg)

![2. Considere o sistema de equações lineares sobre R, nas incógnitas x, y, z e t:

x = a − b

5ax − 2by + az + t = 1

−bz = 1

−3ax + 2by − az + (b − a)t = 2a − 1

Utilizando o método de condensação, discuta o sistema em função dos parâmetros a e b.

Cálculo da Matriz Inversa de uma Matriz Regular

Seja A uma matriz quadrada de ordem n. Sabemos que A é regular (isto é, invertı́vel) se

existe uma matriz quadrada, com a mesma ordem, B tal que

AB = BA = I.

Vamos determinar a matriz B tal que

AB = I

e em seguida mostraremos que essa matriz B também é inversa à esquerda, isto é, BA = I.

Representemos B por X, e Xj e Ij, respectivamente, as j-ésimas colunas de X e I. Assim,

a equação matricial AX = I é equivalente a n sistemas de equações lineares:

AXj = Ij

j = 1, . . . , n

Pelo que vimos anteriormente, tais sistemas têm solução única se, e somente se, Car A = n.

Cada um dos sistemas é resolvido passando da matriz ampliada [A|Ij] para a matriz [I|Xj].

Isto é equivalente à passagem de [A|I] para [I|X] efectuando as operações elementares nos

n sistemas.

Exercı́cio: Determine a inversa à direita da matriz

A =

2 0 2

−1 1 −3

0 2 1

.

Mostremos agora que a existência de uma inversa à direita garante a existência de inversa

à esquerda e que elas são iguais.

Sabemos que se A tem inversa X à direita se, e somente se, Car A = n (ordem de A).

Desta forma, AT

também tem inversa à direita, digamos Y, isto é, AT

Y = I. Logo,

AT

Y

T

= IT

⇔ Y T

A = I,

isto é, a matriz A tem inversa à esquerda.

22](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-23-320.jpg)

![- Multiplicação escalar: definida por

( ) ( )

n

2

1

n

2

1 x

,

,

x

,

x

x

,

,

x

,

x α

α

α

=

α K

K ;

(em que as operações que figuram nos n-uplos dos segundos membros das

igualdades anteriores são as operações adição e multiplicação em k).

Nota: Dado um corpo K, sempre que seja feita referência ao espaço vectorial K

n

sobre o

corpo K, assumiremos que as operações consideradas são as usuais, a menos que seja dito

o contrário.

7. Para cada n IN , o conjunto IR

∈

n

(respectivamente, C

n

) é um espaço vectorial real

(respectivamente, complexo).

8. Para cada IN,o conjunto C

∈

n

n

é um espaço vectorial real.

9. O conjunto de todos os polinómios na variável x, com coeficientes em K, de grau não

superior a n ( IN) é um espaço vectorial sobre K (K = IR ou K = C

) com as operações

definidas por:

∈

n

( ) ( )

( ) ( ) ( ) ( ) n

n

n

2

2

2

1

1

0

0

n

n

2

2

1

0

n

n

2

2

1

0

x

b

a

x

b

a

x

b

a

b

a

x

b

x

b

x

b

b

x

a

x

a

x

a

a

+

+

+

+

+

+

+

+

=

=

+

+

+

+

+

+

+

+

+

L

L

L

e

( ) ( ) ( ) ( ) ( n

n

2

2

1

0

n

n

2

2

1

0 x

a

x

a

x

a

a

x

a

x

a

x

a

a α

+

+

α

+

α

+

α

=

+

+

+

+

α L

L ) .

10. O conjunto de todos os polinómios na variável x, com coeficientes em K, é um espaço

vectorial sobre K, com as operações definidas de forma análoga às definidas em 9 (ditas

usuais).

Propriedades dos Espaços Vectoriais:

1. ( ) y

x

y

x

,

E

y

,

x

,

K α

−

α

=

−

α

∈

∀

∈

α

∀

De facto, tem-se

( ) ( )

[ ] x

y

y

x

y

y

x α

=

+

−

α

=

α

+

−

α ,

atendendo-se à propriedade i) da multiplicação escalar e a ( )

+

,

E ser um grupo.

2. 0

0

,

K =

α

∈

α

∀

É um caso particular de 1. para .

y

x =

3. ( ) ( )

y

y

,

E

y

,

K α

−

=

−

α

∈

∀

∈

α

∀

É um caso particular de 1. para .

0

x =

4. ( ) x

x

x

,

E

x

,

K

, β

−

α

=

β

−

α

∈

∀

∈

β

α

∀

De facto, tem-se

( ) ( )

[ ] x

x

x

x α

=

β

+

β

−

α

=

β

+

β

−

α

25](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-26-320.jpg)

![é também um subespaço vectorial de E.

Demonstração: Exercício.

Seja E um espaço vectorial sobre um corpo K e E

x

,

,

x

,

x n

2

1 ∈

K . Todo o vector v que

se pode exprimir sob a forma

n

n

2

2

1

1 x

x

x

v α

+

+

α

+

α

= L ,

com ,

i diz-se combinação linear dos vectores

,

K

i ∈

α n

,

,

1 K

= .

x

,

,

x

,

x n

2

1 K

Analogamente, se A é um subconjunto de E, então qualquer vector de E da forma

n

n

2

2

1

1 x

x

x α

+

+

α

+

α L ,

com e

K

,

,

, n

2

1 ∈

α

α

α K ,

A

x

,

,

x

,

x n

2

1 ∈

K diz-se combinação linear (finita) de elementos

de A.

Obs.: É óbvio que qualquer elemento de A é combinação linear de elementos de A. De facto,

se podemos escrever

,

A

x ∈

,

x

0

x

0

x

1

x n

2 ⋅

+

+

⋅

+

⋅

= L

com .

A

x

,

,

x

,

x n

3

2 ∈

K

Exercício: Dados os vectores, em IR

4

,

( b

,

a

,

1

,

1

u = ) ( )

3

,

1

,

1

,

3

v = ( )

5

,

1

,

0

,

2

w = ,

determine o valor das constantes a e b por forma a ser possível escrever o vector u

como combinação linear dos vectores v e w.

Teorema 3.5: Seja E um espaço vectorial sobre um corpo K e A uma parte não vazia de E. O

conjunto F de todas as combinações lineares de elementos de A é o “menor” subespaço

vectorial de E que contém A.

Demonstração: Exercício.

Sendo A uma parte não vazia do espaço vectorial E definido sobre um corpo K, o

subespaço F de E formado por todas as combinações lineares de elementos de A diz-se

subespaço gerado por A, ou, também, que A gera o subespaço F.

No caso de F coincidir com o próprio E, diz-se que os vectores de A constituem um

sistema de geradores de E.

Notação: O subespaço gerado por A representa-se por

A ou [ ]

A ou ainda ,

x

,

,

x

,

x n

2

1 K

se .

{ }

n

2

1 x

,

,

x

,

x

A K

=

Em resumo: se F for o subespaço gerado pelo conjunto { }

n

2

1 x

,

,

x

,

x K ,

27](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-28-320.jpg)

![Exercícios:

1. Indique a condição a que deve satisfazer λ de modo a que os vectores ( ), ( ) e

constituam uma base de IR

1

,

0

,

1 0

,

,

0 λ

( λ

,

0

,

1 ) 3

.

2. Considere o seguinte subespaço vectorial do espaço vectorial IR

4

:

( )

{ ∈

= t

,

z

,

y

,

x

A IR

4

: }

0

t

z

y

x =

+

−

− .

Determine uma base e a dimensão do subespaço A.

Pelo que vimos anteriormente, fixada uma base { }

n

2

1 e

,

,

e

,

e K no espaço E, cada

vector de E fica bem definido pelas suas coordenadas, isto é, pelos escalares que aparecem

em:

( )

n

2

1 ,

,

, α

α

α K ou [ ]

n

2

1 α

α

α L ou em .

α

α

α

n

2

1

M

Exemplo: No espaço dos polinómios de grau não superior a 3, { }

3

2

x

,

x

,

x

,

1 é uma base. Nesta

base, as coordenadas do polinómio são

3

2

x

5

x

4

x

2 −

+

+

− [ ]

5

4

1

2 −

− .

Aplicações Lineares

Definição 3.16: Sejam E e F dois espaços vectoriais definidos sobre o mesmo corpo K e ϕ

uma aplicação de E em F. Se é tal que

ϕ

( ) ( ) ( )

y

x

y

x

,

E

y

,

x ϕ

+

ϕ

=

+

ϕ

∈

∀

( ) ( )

x

x

,

E

x

,

K αϕ

=

α

ϕ

∈

∀

∈

α

∀

então diz-se que é uma aplicação linear, um homomorfismo ou uma transformação

linear de E em F.

ϕ

Uma aplicação linear de E em E diz-se um endomorfismo.

Um aplicação linear bijectiva diz-se também um isomorfismo de E em F. Caso exista

esse isomorfismo diz-se que E e F são espaços isomorfos. Um isomorfismo de E em E

denomina-se automorfismo.

Observação: Pode mostrar-se que as duas proposições da definição de aplicação linear são

equivalentes à proposição: ( ) ( ) (y

x

y

x

,

E

y

,

x

,

K

, )

βϕ

+

αϕ

=

β

+

α

ϕ

∈

∀

∈

β

α

∀ .

Exemplos:

31](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-32-320.jpg)

![1. A aplicação f de IR

3

em IR

2

definida por ( ) ( )

z

y

x

,

x

z

,

y

,

x

f +

+

= .

2. Homotetia (em IR

3

): .

( ) ( z

2

,

y

2

,

x

2

z

,

y

,

x a )

3. Rotação (em IR

2

): ( ) ( x

,

y

y

,

x −

a ) (rotação de

2

π

)

ou ( ) ( ) ( )

+

−

2

y

x

2

,

2

y

x

2

y

,

x a (rotação de

4

π

)

Exercício: Verifique se a seguinte aplicação é linear:

:

f IR

3

→ IR

2

( ) ( )

z

y

,

y

x

z

,

y

,

x −

−

a .

Representaremos por L o conjunto de todas as aplicações lineares de E em F,

com E e F espaços vectoriais sobre um mesmo corpo K.

( F

,

E )

Observação: Prova-se que o conjunto L ( )

F

,

E é um espaço vectorial sobre K, para as

operações:

Adição: ∈

ψ

ϕ,

∀ L ,

( )

F

,

E ( )( ) ( ) ( )

x

x

x ψ

+

ϕ

=

ψ

+

ϕ .

Multiplicação Escalar: ∈

ϕ

∀

∈

α

∀ ,

K L ( )

F

,

E , ( )( ) ( )

[ ]

x

x ϕ

α

=

αϕ .

Propriedades das Aplicações Lineares:

Sejam ∈

ϕ L ( )

F

,

E e ψ L

∈ ( )

G

,

F , com E, F e G espaços vectoriais sobre o mesmo

corpo K.

1. ( ) .

0

0 =

ϕ

2. é uma aplicação linear de E em G.

ϕ

ψ o

3. é um subespaço vectorial de F.

( )

E

ϕ

4. , denominado núcleo da aplicação linear ϕ , é um

subespaço vectorial de E.

{ }

( ) ( )

{ 0

x

:

E

x

0

N 1

=

ϕ

∈

=

ϕ

= −

ϕ }

5. ( ) ( ) ( )

( )

E

dim

N

dim

E

dim ϕ

+

= ϕ .

6. A aplicação é injectiva se, e somente se,

ϕ { }

0

N =

ϕ .

Exercício: Considere a aplicação linear

:

f IR

3

→ IR

2

( ) ( )

z

y

,

y

x

z

,

y

,

x −

−

a .

a) Determine . A aplicação f é injectiva?

f

N

b) Determine dim (f (IR

3

)).

Teorema 3.17: Sejam E e F dois espaços vectoriais sobre o mesmo corpo K, { }

uma base de E e uma aplicação linear de E em F. Sejam f respectivamente, as

imagens por dos vectores da base de E, isto é,

n

2

1 e

,

,

e

,

e K

ϕ ,

f

,

,

f

, n

2

1 K

ϕ n

2

1 e

,

,

e

,

e K

32](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-33-320.jpg)

![∑

=

β

=

α

n

1

j

j

ij

i t

ou

β

=

α T ,

onde designa a matriz coluna e

α [ T

n

1 α

α L ] β a matriz coluna [ ]T

n

1 β

β L .

Analogamente, se T designar a matriz quadrada de ordem n cuja coluna j é formada

pelas coordenadas de e relativamente à base

′

j { }

n

2

1 e

,

,

e

,

e ′

′

′ K , isto é, se T é a matriz de

passagem da base {

′

}

n

1 e

,

e ′

2 , e

,

′

′ K para a base { }

n

2 e

,

,

e K

1,

e , tem-se

α

′

=

β T .

Combinando estas duas relações, tem-se

α

α

α

′

⋅

=

β

β

β

=

α

α

α

n

2

1

n

2

1

n

2

1

T

T

T

M

M

M

e também

β

β

β

⋅

′

=

α

α

α

′

=

β

β

β

n

2

1

n

2

1

n

2

1

T

T

T

M

M

M

.

Então , isto é, é a matriz inversa de T, ou seja T

n

I

T

T

T

T =

⋅

′

=

′

⋅ T′ 1

T−

=

′ .

Considere-se agora uma aplicação linear ∈

ϕ L ( )

F

,

E e vejamos que alterações

ocorrem na matriz de ϕ quando se mudam as bases de E e F.

Teorema 3.20: Sejam e

{ }

n

2

1 e

,

,

e

,

e K { }

n

2

1 e

,

,

e

,

e ′

′

′ K duas bases de E e T a matriz de

passagem da base { }

n

2

1 e

,

,

e

, K

e para a base { }

n

2 e

,

,

e

1,

e ′

′

′ K . Sejam { } e

duas bases de F e S a matriz de passagem da base

m

2

1 f

,

,

f

,

f K

{ m

2

1 f

,

,

f

,

f ′

′

′ K } { }

m

f

,

2

1 ,

f

,

f K para a base

. Seja A=

{ }

m

2

1 f

,

,

f

,

f ′

′

′ K ( )

}

f

{

},

e

{

, i

j

ϕ

M e A′ = ( )

}

f

{ i

},

e

{

, j

M ′

′

ϕ . Então podemos afirmar que

T

A

S

A 1

⋅

⋅

=

′ −

.

As matrizes A e , do tipo

A′ n

m× , por satisfazerem à relação ou à

relação equivalente , com S e T matrizes regulares, de ordem m e n

respectivamente, dizem-se matrizes equivalentes.

T

A

S

A 1

⋅

⋅

=

′ −

1

T

A

A −

⋅

′

S⋅

=

É óbvio que A e têm a mesma característica. No caso particular em que

A′ ,

F

E =

isto é, no caso em que ∈

ϕ L , tem-se

( E

,

E )

T

A

T

A 1

⋅

⋅

=

′ −

,

36](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-37-320.jpg)

![Observação: Se uma função n-linear é anti-simétrica e σ é uma permutação de S , então

n

( ) ( ) ( )

( ) ( ) ( )

n

2

1

n

2

1 x

,

,

x

,

x

f

x

,

,

x

,

x

f K

K σ

ε

=

σ

σ

σ .

A partir de agora consideraremos sempre um corpo K de característica diferente 2. O

corpo dos reais ou dos complexos são considerados corpos de característica zero (ou infinita).

Seja A uma matriz quadrada de ordem n sobre K, isto é,

=

nn

2

n

1

n

n

2

22

21

n

1

12

11

a

a

a

a

a

a

a

a

a

A

L

L

L

L

L

L

L

.

É evidente que uma matriz pode identificar-se com um elemento de n

n

n

K

K

K ×

×

× L

n

,

bastando identificar cada uma das suas linhas, L como elementos de

,

L

,

,

L

, n

2

1 K K . Assim,

no contexto de podemos definir a seguinte função n-linear:

( n

,

n

MK )

Definição 4.13: Chama-se determinante de ( )

n

,

n

M

A K

∈ à função n-linear alternada das

linhas de A definida por:

[ ] ( ) ( ) ( ) ( )

∑

∈

σ

σ

σ

σ ⋅

σ

ε

=

=

=

n

S

n

n

2

2

1

1

ij a

a

a

A

A

det

a

A L

a .

Observação: O determinante de uma matriz quadrada não é mais do que a soma de todos os

produtos de n elementos da matriz, correspondentes a cada uma das permutações de S ,

afectados pelo sinal da permutação correspondente. Assim, o número de parcelas é igual a n .

n

!

]

A partir da definição, podemos facilmente constatar que:

- Se A , então .

[ 11

a

= 11

a

A

det =

- Se A , então det

=

22

21

12

11

a

a

a

a

21

12

22

11 a

a

a

a

A −

= , já que S , sendo a

permutação par e a permutação ímpar.

=

1

2

2

1

,

2

1

2

1

2

2

1

2

1

1

2

2

1

Assim, o determinante de uma matriz quadrada de ordem 2 é igual à diferença entre o

produto dos elementos principais e o produto dos elementos da diagonal secundária.

- Se A , então

=

33

32

31

23

22

21

13

12

11

a

a

a

a

a

a

a

a

a

43](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-44-320.jpg)

![32

23

11

33

21

12

31

22

13

32

21

13

31

23

12

33

22

11

33

32

31

23

22

21

13

12

11

a

a

a

a

a

a

a

a

a

a

a

a

a

a

a

a

a

a

a

a

a

a

a

a

a

a

a

−

−

−

+

+

= ,

já que as permutações de S são:

3

3

2

1

3

2

1

, , , , , .

1

3

2

3

2

1

2

1

3

3

2

1

1

2

3

3

2

1

3

1

2

3

2

1

2

3

1

3

2

1

Em termos práticos, o cálculo do determinante de uma matriz quadrada de ordem 3

pode ser efectuado usando a Regra de Sarrus: as parcelas de sinal positivo do

determinante são referentes ao produto dos elementos principais e aos produtos dos

elementos que se dispõem nos vértices dos dois triângulos cuja base é paralela à diagonal

principal, e as parcelas de sinal negativo do determinante são referentes ao produto dos

elementos da diagonal secundária e aos produtos dos elementos que se dispõem nos

vértices dos dois triângulos cuja base é paralela à diagonal secundária. Observe o

esquema:

33

32

31

23

22

21

13

12

11

a

a

a

a

a

a

a

a

a

Exercício: Calcule o determinante das seguintes matrizes:

a) b) c)

−

1

3

5

2

−

−

−

3

3

1

1

2

1

4

0

2

−

−

−

1

2

3

2

4

2

1

2

1

No cálculo do determinante de uma matriz de ordem superior ou igual a 4 não é usual

aplicar-se a definição de determinante, pois torna-se um cálculo fastidioso. No entanto,

iremos estudar propriedades que facilitam esses cálculos. Antes dessas propriedades,

estudemos agora as propriedades básicas dos determinantes.

Propriedades dos Determinantes:

Seja A uma matriz quadrada de ordem n.

1. (n-linear) Se uma fila de A se decompuser numa soma de filas, o determinante de A é

igual à soma dos determinantes de duas matrizes em que nessa fila se usa uma parcela de

cada vez, mantendo-se as restantes. Isto é,

[ ] [ ] [ ]

n

i

1

n

i

1

n

i

i

1 F

,

,

F

,

,

F

det

F

,

,

F

,

,

F

det

F

,

,

F

F

,

,

F

det K

K

K

K

K

K ′

+

=

′

+ .

2. (n-linear) Se multiplicarmos uma fila de A por um escalar α , então o determinante vem

multiplicado por , isto é,

α

[ ] [ ]

n

i

1

n

i

1 F

,

,

F

,

,

F

det

F

,

,

F

,

,

F

det K

K

K

K α

=

α .

44](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-45-320.jpg)

![Assim, também temos que A

A n

α

=

α .

3. (Anti-simetria) Ao trocarmos entre si duas filas paralelas de A, o determinante troca de

sinal, isto é,

[ ] [ ]

n

i

j

1

n

j

i

1 F

,

,

F

,

,

F

,

,

F

det

F

,

,

F

,

,

F

,

,

F

det K

K

K

K

K

K −

= .

4. (Função alternada) Se as filas de A são linearmente dependentes, então o determinante

de A é igual a zero.

5. Não se altera o determinante de A quando a uma fila se adiciona uma combinação linear

de outras filas paralelas. Basta observar que:

[ ] [ ] [ ]

n

j

j

1

n

i

1

n

j

i

1 F

,

,

F

,

,

F

,

,

F

det

F

,

,

F

,

,

F

det

F

,

,

F

F

,

,

F

det K

K

K

K

K

K

K α

+

=

α

+ .

6. . Pois, representando a por a , cada parcela de det é da forma

A

det

A

det T

= ji

T

ij

T

A

( ) ( ) ( ) ( ) ( ) ( ) ( ) ( ) ( )

( ) ( ) ( )

n

n

1

1

1

n

n

1

1

n

n

1

1

T

n

n

T

1

1 1

1

1

1 a

a

a

a

a

a

a

a −

−

−

−

σ

σ

−

σ

σ

σ

σ

σ

σ σ

ε

=

σ

ε

=

σ

ε

=

σ

ε L

L

L

L ,

isto é, corresponde a outro termo de , com o mesmo sinal.

A

det

7. ∗

=

= A

det

A

det

A

det .

8. Se A é uma matriz triangular, então

nn

22

11 a

a

a

A

det L

= .

Em particular, .

1

I

det =

9. A característica da matriz A é inferior à ordem se, e somente se, , isto é, A é

uma matriz singular se, e somente se, det

0

A

det =

0

A = . Evidentemente, A é regular se, e somente

se, .

0

A

det ≠

10. B

A

B

A ⋅

=

⋅ .

11. Se A é regular, então

A

1

A 1

=

−

.

12. A característica da matriz A é igual à mais alta ordem das submatrizes quadradas de A

com determinante não nulo.

Exercício: Sejam A e B duas matrizes quadradas de ordem 2 tais que .

Calcule

B

det

2

A

det −

=

=

( )

( )

[ ]

T

1

AB

2

det

−

.

Complementos Algébricos

Definição 4.14: Seja A uma matriz quadrada de ordem n. Chama-se menor de ordem m de A

ao determinante de qualquer submatriz de A de ordem m ( n

m ).

Dois menores dizem-se complementares se num deles estão representadas

exactamente as linhas e colunas de A que não figuram no outro.

Um menor diz-se principal se a sua diagonal tem somente elementos principais da

matriz inicial.

Um menor de A diz-se par ou ímpar conforme é par ou ímpar a soma dos índices das

linhas e das colunas de A nele representadas.

45](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-46-320.jpg)

![Teorema 4.16: A soma dos produtos dos elementos de uma fila pelos complementos

algébricos dos elementos homólogos de outra fila paralela é nula, isto é,

hn

in

2

h

2

i

1

h

1

i A

a

A

a

A

a

0 +

+

+

= L (i h

≠ )

ou

nk

nj

k

2

j

2

k

1

j

1 A

a

A

a

A

a

0 +

+

+

= L ( k

j ≠ ).

Demonstração: Essa soma é igual ao determinante da matriz obtida substituindo a linha i pela

linha h (ou coluna j pela coluna k). Desta forma, a matriz fica com duas filas iguais e portanto

o determinante é nulo.

Este teorema e o teorema de Laplace permitem escrever:

∑

∑ =

=

=

=

n

1

i

ij

ij

n

1

j

ij

ij A

a

A

a

A e 0 ,

)

h

i

e

k

j

(

A

a

A

a

n

1

i

ik

ij

n

1

j

hj

ij ≠

≠

=

= ∑

∑ =

=

isto é, usando o símbolo de Kronecker,

A

A

a ih

n

1

j

hj

ij δ

=

∑

=

ou A

A

a jk

n

1

i

ik

ij δ

=

=

∑ .

Teorema 4.17: (Teorema de Laplace Generalizado) Um determinante de uma matriz é

igual à soma dos produtos dos menores de ordem m contidos em m filas paralelas pelos

respectivos complementos algébricos.

Exercício: Seja . Utilize o teorema de Laplace generalizado para

calcular

−

−

−

=

1

2

5

3

4

2

0

1

0

1

1

3

4

1

0

0

2

1

0

0

4

5

0

3

1

A

A .

Definição 4.18: Seja A uma matriz quadrada. Chama-se adjunta de A à matriz que desta se

obtém substituindo cada elemento pelo seu complemento algébrico e transpondo a matriz

resultante.

Notação: A adjunta de uma matriz A é representada por adj A ou .

Â

De acordo com a definição anterior, se [ ]

ij

a

A = , então a matriz adjunta de A é tal

que adjA .

[ ] [ ji

T

ij A

A =

= ]

Exercício: Determine a matriz adjunta da matriz .

−

−

=

0

1

1

0

0

1

2

1

0

A

47](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-48-320.jpg)

![Teorema 4.19: Seja A uma matriz quadrada de ordem n regular. Então I

A

adjA

A ⋅

=

⋅ e

1

n

A

adjA

−

= .

Demonstração: Basta observar que multiplicando A e , obtemos:

adjA

[ ] ,

b

adjA

A ij

=

⋅ com ∑ δ

=

=

k

ij

jk

ik

ij A

A

a

b e [ ] ,

c

A ij

=

⋅

adjA com ∑ δ

=

=

k

ij

kj

ki

ij A

a

A

c .

Assim, podemos concluir que I

A

A ⋅

=

⋅

adjA

adjA

A =

⋅ . E desta fórmula, usando as

propriedades dos determinantes e o facto de A ser regular, temos que

1

n

n

A

adjA

A

adjA

A

I

A

adjA

A

−

=

⇔

=

⋅

⇔

⋅

=

⋅

Corolário 4.20: Se A é uma matriz quadrada regular, então

adjA

A

1

A 1

⋅

=

−

.

Demonstração: Usando-se o teorema 4.19, resulta de imediato que

I

A

adjA

A

1

adjA

A

1

A =

⋅

⋅

=

⋅

⋅ .

Este corolário dá-nos assim um novo processo para calcular a inversa de uma matriz

regular.

Exercício: Utilizando a última propriedade, determine, caso exista, a matriz inversa da matriz

−

−

=

0

1

1

0

0

1

2

1

0

A .

Resolução de Sistemas de Equações Lineares Usando a Teoria dos Determinantes

Seja

=

+

+

+

=

+

+

+

m

n

mn

2

2

m

1

1

m

1

n

n

1

2

12

1

11

b

x

a

x

a

x

a

b

x

a

x

a

x

a

L

M

L

,

um sistema de m equações lineares com n incógnitas, sobre um corpo K. Já sabemos que este

sistema é equivalente à equação matricial AX B

= , com

48](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-49-320.jpg)

![Definição 5.5: Sejam E um espaço euclidiano e { }

0

E

y

,

x ∈ . Define-se ângulo formado pelos

vectores x e y por meio da igualdade

θ

( )

y

x

y

x

cos

⋅

=

θ , π

≤

θ

≤

0 .

Observações:

1. Da definição anterior conclui-se que ( ) θ

⋅

⋅

= cos

y

x

y

x .

2. O ângulo θ já que, pela desigualdade de Cauchy-Schwarz,

[ π

∈ ,

0 ]

( )

( ) ( ) 1

y

x

y

x

1

1

y

x

y

x

y

x

y

x ≤

⋅

≤

−

⇔

≤

⋅

⇔

⋅

≤

e a função cos(x) é uma bijecção de [ ]

π

,

0 em [ ]

1

,

1

− .

Cálculo do Produto Interno de Dois Vectores

Sejam { uma base do espaço unitário E e

}

n

2

1 e

,

,

e

,

e K E

y

,

x ∈ . Então, existem ,

K

, i

i ∈

β

α

tais que

,

n

,

,

1

i K

=

n

n

2

2

1

1 e

e

e

x α

+

+

α

+

α

= L

e

n

n

2

2

1

1 e

e

e

y β

+

+

β

+

β

= L .

Assim, podemos escrever:

( ) ( )

( ) ( ) ( )

( ) ( ) ( )

( )

∑∑

= =

β

α

=

β

α

+

+

β

α

+

β

α

+

+

β

α

+

+

β

α

+

β

α

=

β

+

+

β

α

+

+

α

=

n

1

i

n

1

j

j

i

j

i

n

n

n

n

2

n

2

n

1

n

1

n

n

1

n

1

2

1

2

1

1

1

1

1

n

n

1

1

n

n

1

1

e

e

e

e

e

e

e

e

e

e

e

e

e

e

e

e

e

e

y

x

L

L

L

L

L

(1)

Se representarmos ( )

j

i e

e por a , podemos obter a matriz

ij [ ]

ij

a

=

A e deste modo, a expressão (1)

para o produto interno de x por y pode escrever-se na forma matricial:

( ) Y

A

X

y

x T

⋅

⋅

= , (2)

em que

α

α

=

n

1

X M , e

β

β

=

n

1

Y M [ ]

ij

a

A = .

57](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-58-320.jpg)

![Se E é um espaço real e det 1

P = , então dizemos que as duas bases o.n. têm a mesma

orientação e obtém-se uma a partir da outra por uma rotação.

Exemplos: As bases { } e

( ) ( ) ( )

1

,

0

,

0

,

0

,

1

,

0

,

0

,

0

,

1 ( ) ( ) ( )

{ }

0

,

1

,

0

,

1

,

0

,

0

,

0

,

0

,

1 não têm a mesma orientação,

pois

1

0

1

0

1

0

0

0

0

1

P

det −

=

= .

Uma rotação em IR

2

é uma aplicação linear que pode ser representada pela matriz ortogonal:

θ

θ

θ

−

θ

=

cos

sen

sen

cos

P .

Produto Vectorial e Misto em IR

3

Definição 5.14: Sejam x e y dois vectores de IR

3

(com o produto escalar usual). Define-se

produto vectorial (ou externo) de x por y, que denotamos por y

x ∧ , do seguinte modo:

- Se x e y são linearmente dependentes, 0

y

x =

∧ .

- Se x e y são linearmente independentes, y

x ∧ é tal que

1. é ortogonal a x e a y.

y

x ∧

2. é uma base directa (ou positiva) (isto é, a matriz de passagem da base

para esta base tem determinante positivo).

( y

x

,

y

,

x ∧

( )

( ,

1

,

0

,

0

,

0

,

1

)

))

( ) ( 1

,

0

,

0

,

0

3. θ

⋅

⋅

=

∧ sen

y

x

y

x , com [ ]

π

∈

θ ,

0 , o ângulo formado pelos vectores x e y.

Observação: A partir de agora consideraremos sempre a base canónica de IR

3

, inclusivé na

Geometria Analítica, representada por três segmentos de recta de origem O e tal que um

observador com a cabeça no sentido de , vê e à sua direita e e à sua esquerda (isto é,

rodando no sentido directo um ângulo de

3

e 1 2

1

e 2

π obtém-se ). Fixando esta base como

positiva, diremos que a base com orientação contrária (isto é, obtida por uma mudança de base

cuja matriz tem determinante negativo) é inversa (ou negativa). Por isto, utiliza-se a notação

em lugar de { }

2

e

( 3

2

1 e

,

e

,

e )

)

3

2

1 e

,

e

,

e .

Cálculo do produto vectorial:

Se ( é uma base de IR

3

2

1 e

,

e

,

e

3

o.n. directa e

3

3

2

2

1

1 e

x

e

x

e

x

x +

+

= , 3

3

2

2

1

1 e

y

e

y

e

y

y +

+

= ,

então

( ) ( ) ( ) 3

1

2

2

1

2

1

3

3

1

1

2

3

3

2 e

y

x

y

x

e

y

x

y

x

e

y

x

y

x

y

x −

+

−

−

−

=

∧ .

59](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-60-320.jpg)

![( ) ( ) ( ) ( ) y

z

x

x

y

z

z

x

y

z

y

x ∧

−

=

∧

−

=

∧

−

=

∧ .

3. O produto misto não se altera por permutação circular dos três vectores ou pela troca dos

sinais e

∧ , isto é,

( ) ( ) ( ) ( )

z

y

x

y

x

z

x

z

y

z

y

x ∧

=

∧

=

∧

=

∧ .

4. ( ) z

y

x ∧

( )

é o volume do paralelepípedo definido pelos três vectores. Observe-se ainda que

cos

z

y

x

z

y

x θ

⋅

⋅

∧

=

∧ , com [ ]

π

∈

θ ,

0 , o ângulo formado pelos vectores e z.

y

x ∧

x

θ z y

y

x ∧

61](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-62-320.jpg)

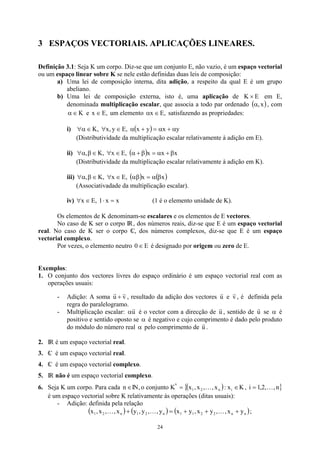

![Estudo das Quádricas com as Equações na Forma Canónica

Definição 6.8: Uma quádrica é um conjunto de pontos de R

3

cujas coordenadas cartesianas

satisfazem uma equação algébrica inteira do 2º grau.

A equação de uma quádrica é então da forma:

0

a

z

a

2

z

a

y

a

2

yz

a

2

y

a

x

a

2

xz

a

2

xy

a

2

x

a 44

34

2

33

24

23

2

22

14

13

12

2

11 =

+

+

+

+

+

+

+

+

+

Se designarmos por A a matriz simétrica tal que [ ]

ij

a

=

A e por X a matriz coluna tal que

, então a equação de uma quádrica pode escrever-se na forma matricial:

[ T

1

z

y

x

X = ]

0

AX

XT

= .

Por meio de uma apropriada mudança de referencial (translação da origem e mudança

de base), é possível, para o referencial o.n. escolhido, obter uma equação simplificada da

quádrica, chamada equação canónica (ou equação reduzida).

Equações das quádricas na forma reduzida:

1. Considere-se a equação

1

c

z

b

y

a

x

2

2

2

2

2

2

=

+

+ .

A quádrica representada por esta equação denomina-se elipsóide. Estudemos as

particularidades desta quádrica observando as projecções (ou traço) sobre os planos

coordenados:

- Traço em XOY ( 0

z = ): 1

b

y

a

x

2

2

2

2

=

+ (elipse);

- Traço em YOZ ( 0

x = ): 1

c

z

b

y

2

2

2

2

=

+ (elipse);

- Traço em XOZ ( 0

y = ): 1

c

z

a

x

2

2

2

2

=

+ (elipse).

Assim, obtemos a figura seguinte para um elipsóide:

Os parâmetros a, b e c são os semi-eixos.

82](https://image.slidesharecdn.com/apostiladealgebralinear-230129200250-d27ddb70/85/Apostila-de-Algebra-Linear-pdf-83-320.jpg)