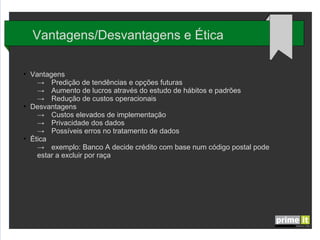

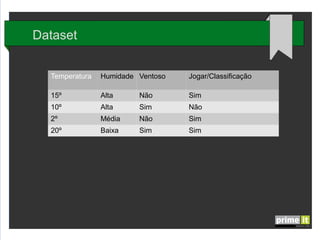

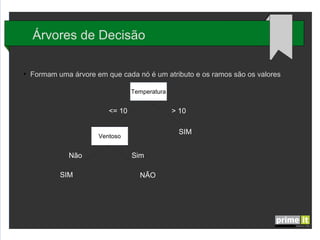

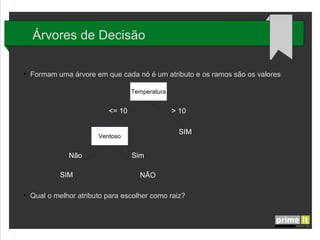

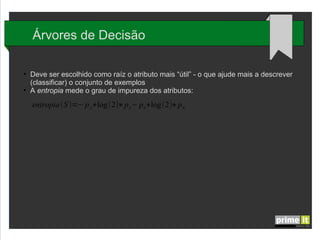

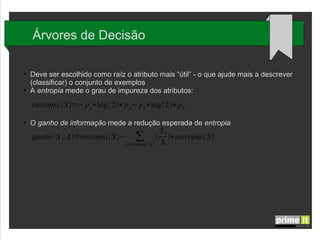

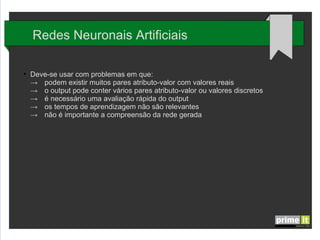

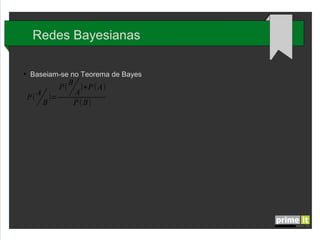

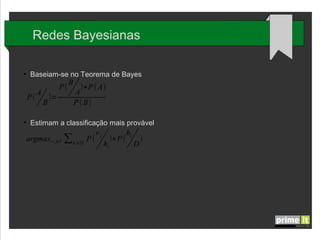

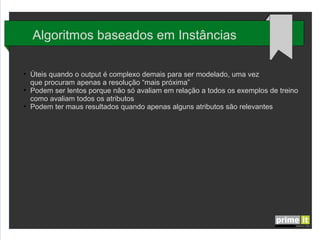

O documento discute Big Data e técnicas de análise de dados. Aborda porque Big Data é importante, fatores-chave como infraestrutura e gestão de dados, e aplicações em empresas. Também explica conceitos como árvores de decisão, redes neurais e algoritmos genéticos.