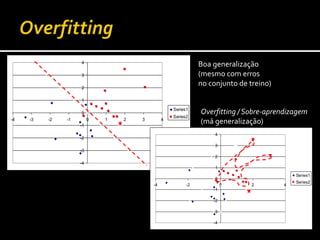

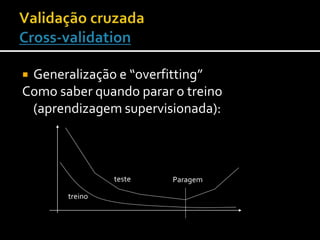

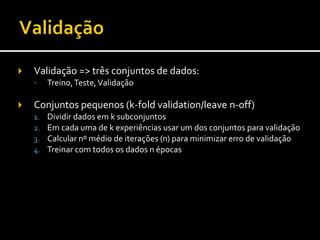

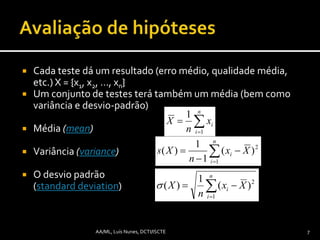

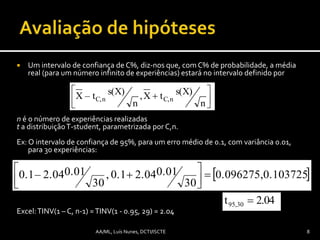

O documento discute conceitos fundamentais de aprendizagem automática, incluindo generalização versus overfitting, avaliação de modelos em conjuntos de treino e teste, e validação cruzada para evitar overfitting. Ele também explica como calcular e interpretar intervalos de confiança para comparar resultados de modelos.