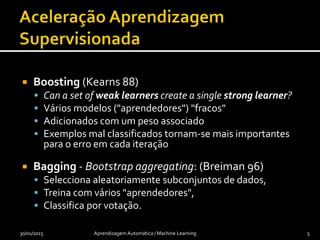

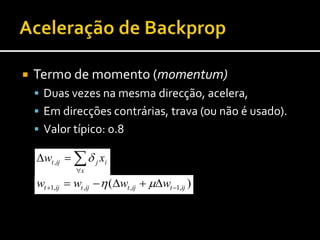

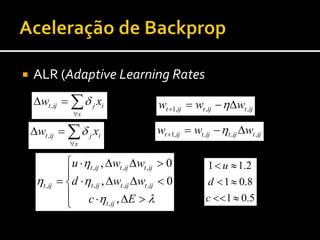

Este documento discute vários métodos para acelerar e melhorar a aprendizagem automática, incluindo usar pequenas populações iniciais, mutação em vez de cruzamento, conhecimento específico do problema, reprocessamento retrospectivo de experiências, shaping, boosting, bagging e taxas de aprendizagem adaptativas. Referências relevantes são fornecidas.