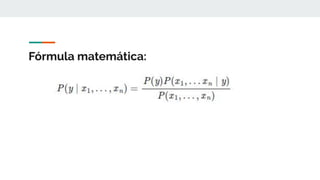

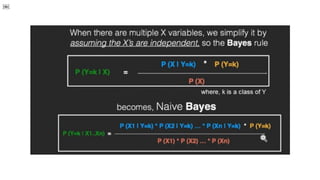

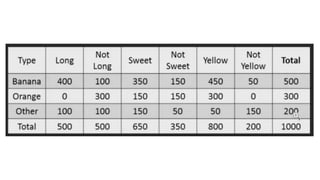

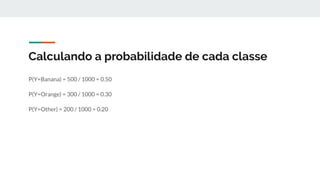

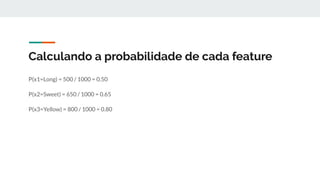

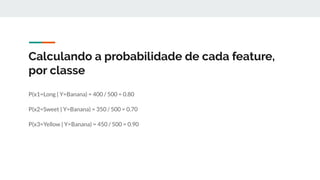

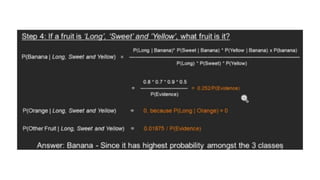

O documento introduz o algoritmo de classificação Naive Bayes, explicando que ele é baseado no Teorema de Bayes e trata cada variável de forma condicionalmente independente. Também apresenta a fórmula matemática do Naive Bayes e demonstra como calcular as probabilidades para classificar novos dados.

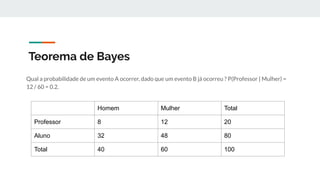

![Teorema de Bayes

P(E|F) = P(E)/[P(F|E)P(E) + P(F|Ẽ)P(Ẽ)]

P(F|E), a probabilidade de que alguém com a doença obtenha um resultado positivo, é 0,99.

P(E), a probabilidade de que qualquer pessoa tenha doença é 1/10.000 = 0.0001.

P(F| Ẽ), a probabilidade de que alguém sem a doença obtenha um teste positivo é 0,01.

P(Ẽ), a probabilidade de que qualquer pessoa não tenha a doença é 0,9999.](https://image.slidesharecdn.com/introducaoamachinelearnnapratica-200401002006/85/Introducao-a-Machine-Learning-na-Pratica-7-320.jpg)