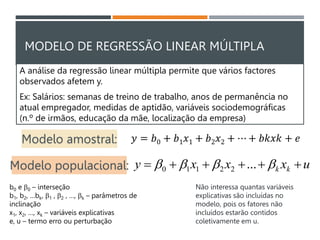

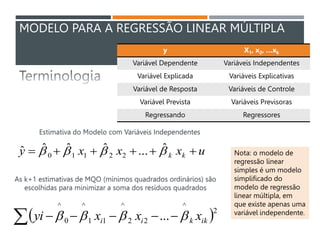

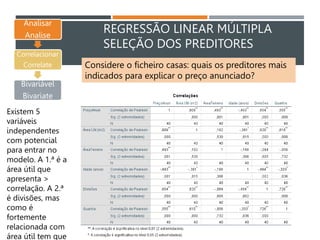

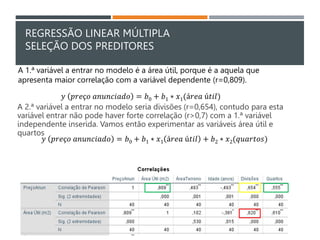

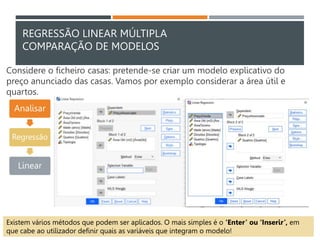

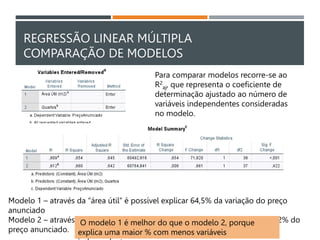

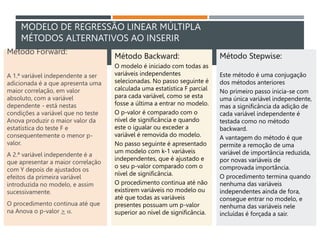

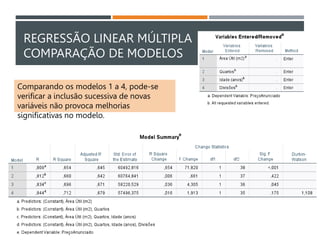

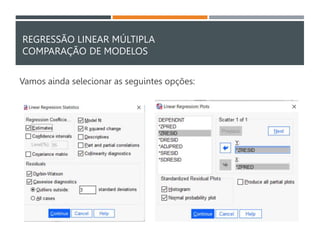

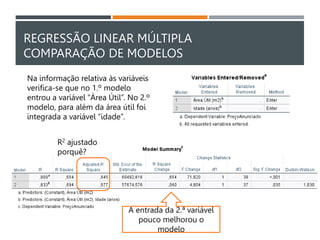

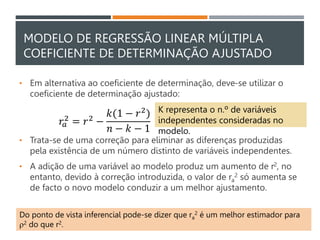

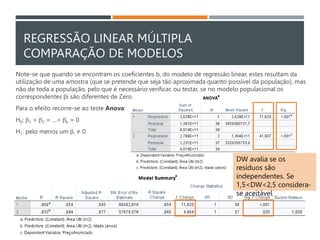

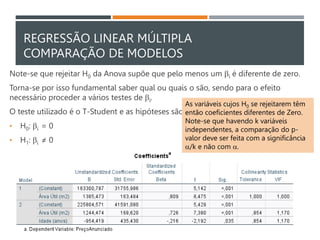

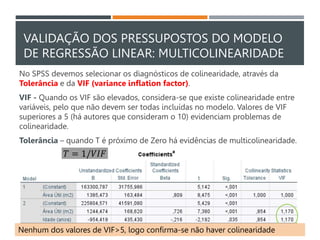

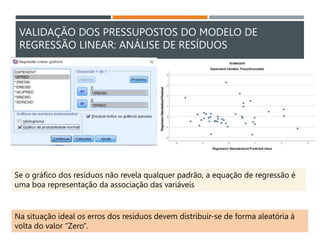

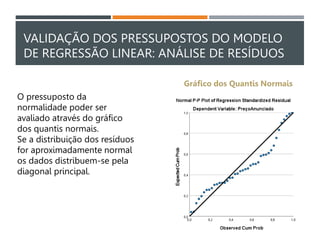

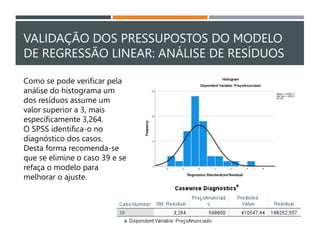

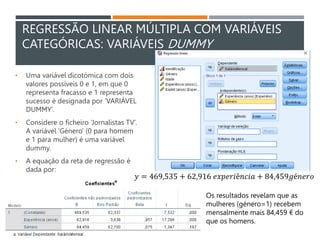

O documento discute análise multivariada de dados e regressão linear múltipla. Apresenta modelos de regressão linear múltipla e discute métodos para seleção de variáveis preditoras e comparação de modelos. Também aborda pressupostos como multicolinearidade.