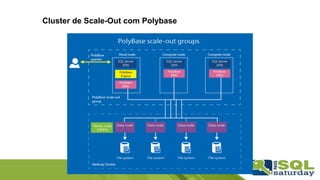

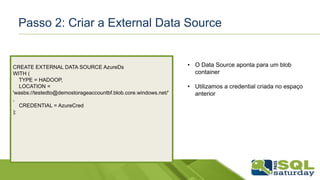

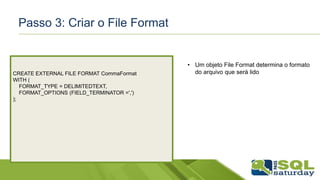

O documento discute a integração de dados de Big Data com sistemas OLTP usando Polybase no SQL Server. Ele fornece detalhes sobre configuração de Polybase para acessar dados em um cluster Hadoop ou Azure Blob Storage, incluindo a criação de credenciais, data sources, file formats e tabelas externas. O documento também mostra uma demonstração ao vivo da conexão com um cluster Hortonworks Sandbox.

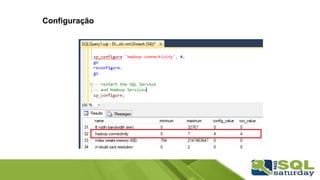

![Hadoop Connectivity

Valor Tipo de Conexão

0 Desabilitada

1

Hortonworks HDP 1.3 no Windows Server

Azure blob storage (WASB[S])

2 Hortonworks HDP 1.3 no Linux

3 Cloudera CDH 4.3 no Linux

4

Hortonworks HDP 2.0 no Windows Server

Azure blob storage (WASB[S])

5 Hortonworks HDP 2.0 no Linux

6 Cloudera 5.1 no Linux

7

Hortonworks 2.1 and 2.2 no Linux

Hortonworks 2.2 no Windows Server

Azure blob storage (WASB[S])](https://image.slidesharecdn.com/integrandobigdataaooltpcompolybase-160420010323/85/Integrando-big-data-ao-oltp-com-polybase-18-320.jpg)

![Passo 4: Criar a External Table

CREATE EXTERNAL TABLE Tempo (

[Data] Date,

Hora varchar(15),

Dia varchar(15),

Temperatura int,

Vento int

)

WITH (

--Set the file to be the HVAC sensor sample file

LOCATION='/example/data/Weather.txt',

DATA_SOURCE = AzureDs,

FILE_FORMAT = CommaFormat,

);

• Um objeto File Format determina o formato

do arquivo que será lido

• O LOCATION pode apontar um arquivo ou

uma pasta

• Uso de Schema-On-Read](https://image.slidesharecdn.com/integrandobigdataaooltpcompolybase-160420010323/85/Integrando-big-data-ao-oltp-com-polybase-24-320.jpg)