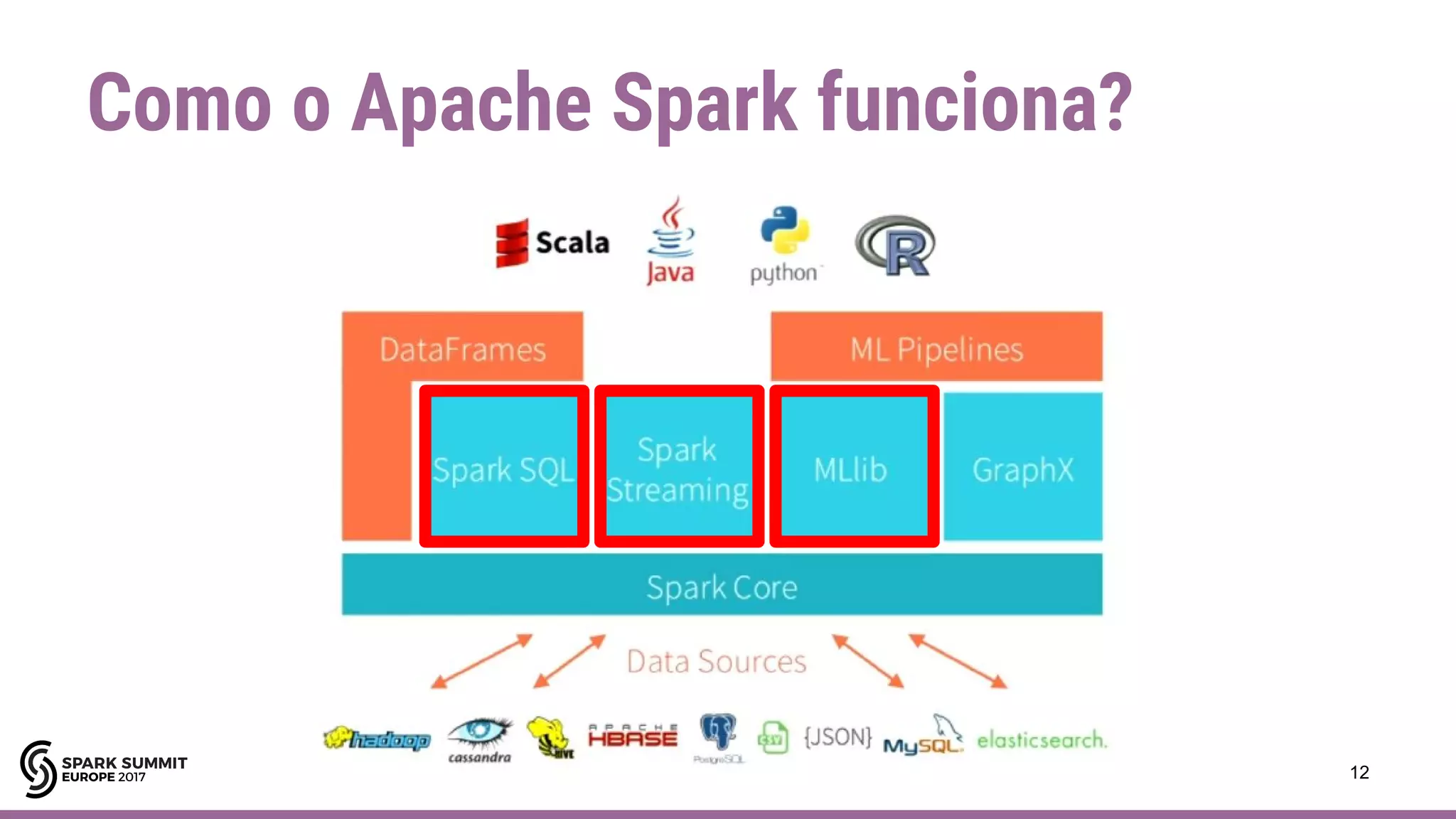

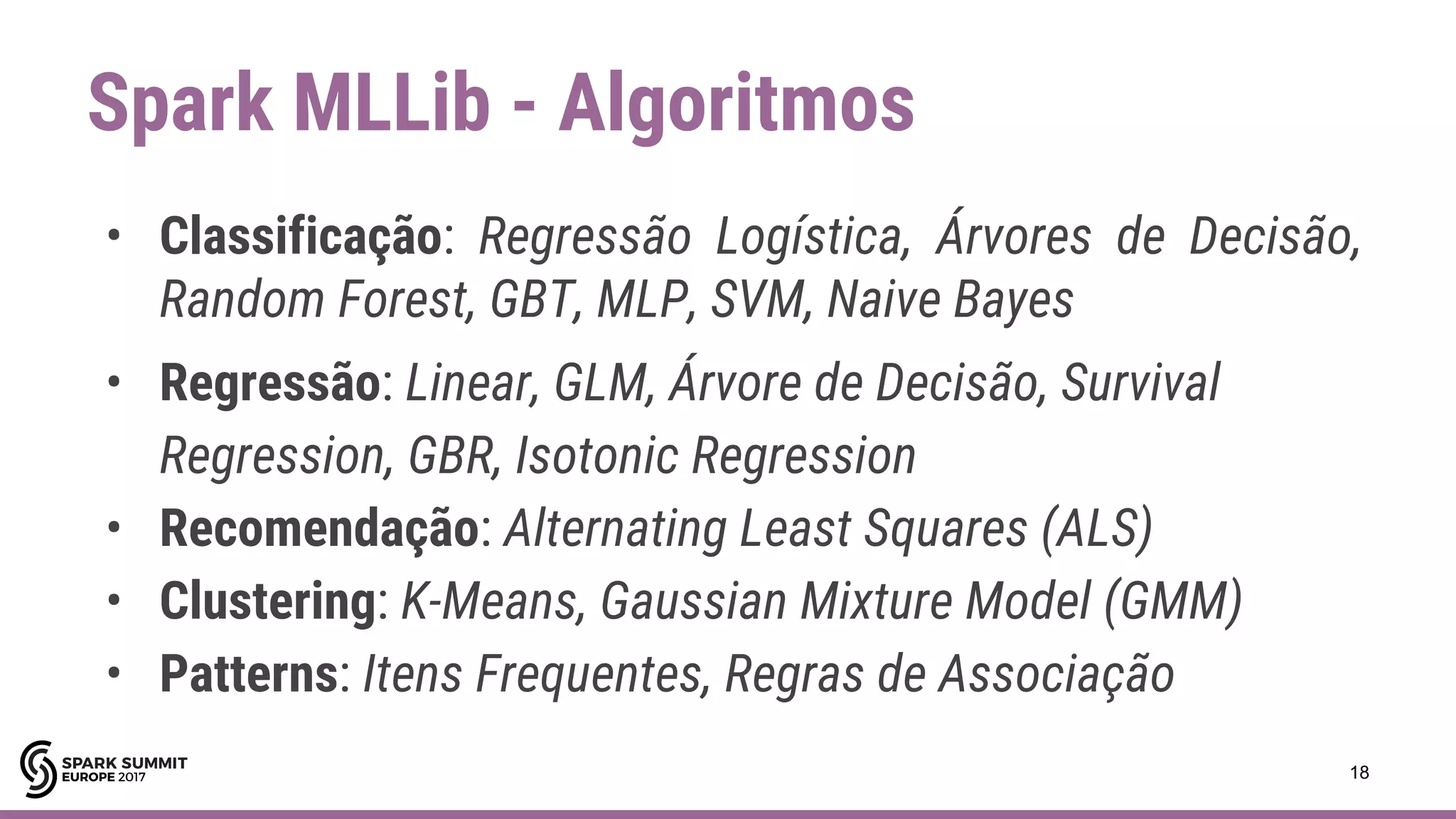

Apache Spark é um framework para processamento de dados em larga escala. Ele funciona armazenando dados em memória para processamento paralelo rápido. O documento descreve casos de uso do Spark, incluindo SQL, streaming, machine learning e considerações sobre limitações.