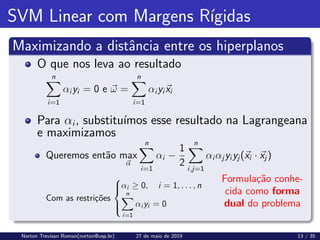

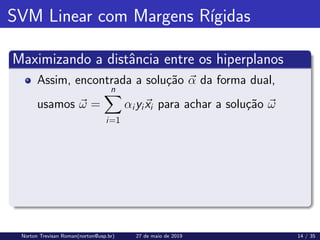

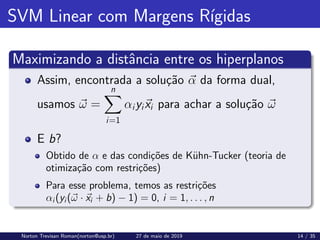

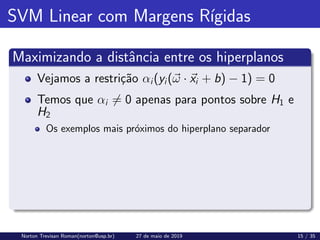

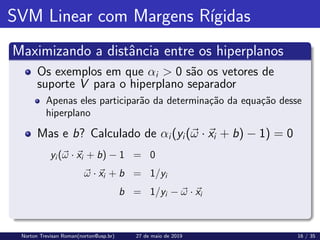

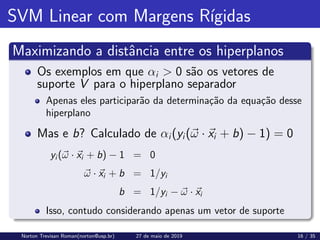

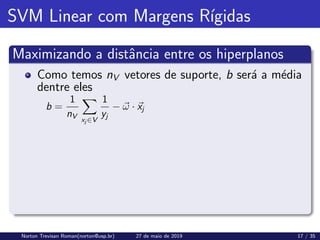

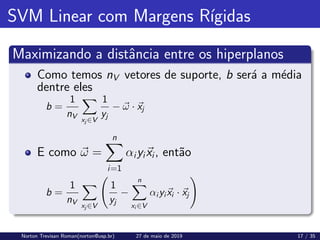

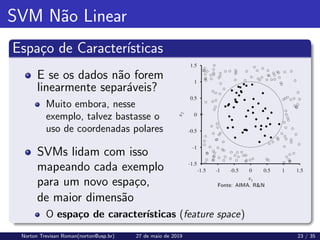

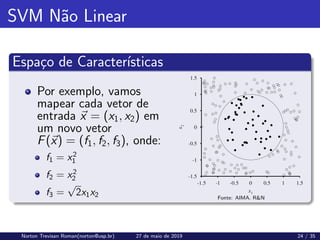

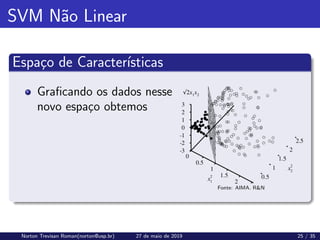

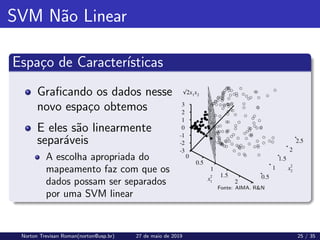

O documento descreve o algoritmo de máquina de vetor de suporte (SVM), explicando como ele busca encontrar o hiperplano separador de margem máxima entre os dados de treinamento de duas classes. O SVM define fronteiras lineares ótimas para dados linearmente separáveis, maximizando a distância entre o hiperplano separador e os exemplos de treinamento mais próximos, chamados de vetores de suporte. O problema é formulado como um problema de otimização para encontrar os parâmetros ω e b que maximizam essa distância de separação.

![SVM Linear com Margens Rı́gidas

Distância entre os Hiperplanos

Queremos, no entanto,

maximizar a margem

Maximizar a distância d

entre os hiperplanos H1 e

H2

Fonte: [3]

Norton Trevisan Roman(norton@usp.br) 27 de maio de 2019 8 / 35](https://image.slidesharecdn.com/aula21-210424145517/85/ACH2044-Inteligencia-Artificial-Aula-21-18-320.jpg)

![SVM Linear com Margens Rı́gidas

Distância entre os Hiperplanos

Queremos, no entanto,

maximizar a margem

Maximizar a distância d

entre os hiperplanos H1 e

H2

Projetamos então o

vetor ~

x1 − ~

x2 na direção

de ~

ω

Onde ~

x1 ∈ H1 e ~

x2 ∈ H2, Fonte: [3]

Norton Trevisan Roman(norton@usp.br) 27 de maio de 2019 8 / 35](https://image.slidesharecdn.com/aula21-210424145517/85/ACH2044-Inteligencia-Artificial-Aula-21-19-320.jpg)

![SVM Linear com Margens Rı́gidas

Distância entre os Hiperplanos

E

~

d = (~

x1 −~

x2)

~

ω

k~

ωk

·

(~

x1 − ~

x2)

k~

x1 − ~

x2k

Fonte: [3]

Norton Trevisan Roman(norton@usp.br) 27 de maio de 2019 9 / 35](https://image.slidesharecdn.com/aula21-210424145517/85/ACH2044-Inteligencia-Artificial-Aula-21-20-320.jpg)

![SVM Linear com Margens Rı́gidas

Distância entre os Hiperplanos

E

~

d = (~

x1 −~

x2)

~

ω

k~

ωk

·

(~

x1 − ~

x2)

k~

x1 − ~

x2k

Uma vez que

~

ω · ~

x1 + b = +1 e ~

ω · ~

x2 + b = −1

Então

~

ω · (~

x1 − ~

x2) = ~

ω · ~

x1 − ~

ω · ~

x2

Fonte: [3]

= (1 − b) − (−1 − b) = 2

Norton Trevisan Roman(norton@usp.br) 27 de maio de 2019 9 / 35](https://image.slidesharecdn.com/aula21-210424145517/85/ACH2044-Inteligencia-Artificial-Aula-21-21-320.jpg)

![SVM Linear com Margens Rı́gidas

Distância entre os Hiperplanos

E ~

d =

2(~

x1 − ~

x2)

k~

ωkk~

x1 − ~

x2k

Fonte: [3]

Norton Trevisan Roman(norton@usp.br) 27 de maio de 2019 10 / 35](https://image.slidesharecdn.com/aula21-210424145517/85/ACH2044-Inteligencia-Artificial-Aula-21-22-320.jpg)

![SVM Linear com Margens Rı́gidas

Distância entre os Hiperplanos

E ~

d =

2(~

x1 − ~

x2)

k~

ωkk~

x1 − ~

x2k

Assim, d = k~

dk =

2

k~

ωk

d0

= 1

k~

ωk

é então a distância

mı́nima entre o hiperplano

separador e os dados de

treinamento

Fonte: [3]

Norton Trevisan Roman(norton@usp.br) 27 de maio de 2019 10 / 35](https://image.slidesharecdn.com/aula21-210424145517/85/ACH2044-Inteligencia-Artificial-Aula-21-23-320.jpg)

![SVM Linear com Margens Rı́gidas

Distância entre os Hiperplanos

E ~

d =

2(~

x1 − ~

x2)

k~

ωkk~

x1 − ~

x2k

Assim, d = k~

dk =

2

k~

ωk

d0

= 1

k~

ωk

é então a distância

mı́nima entre o hiperplano

separador e os dados de

treinamento

Fonte: [3]

Queremos maximizar d0

Norton Trevisan Roman(norton@usp.br) 27 de maio de 2019 10 / 35](https://image.slidesharecdn.com/aula21-210424145517/85/ACH2044-Inteligencia-Artificial-Aula-21-24-320.jpg)

![SVM Linear com Margens Suaves

Dados com ruı́do

Em algumas situações,

mesmo sendo linearmente

separáveis, os dados

apresentam ruı́dos

Fonte: [3]

Norton Trevisan Roman(norton@usp.br) 27 de maio de 2019 20 / 35](https://image.slidesharecdn.com/aula21-210424145517/85/ACH2044-Inteligencia-Artificial-Aula-21-48-320.jpg)

![SVM Linear com Margens Suaves

Dados com ruı́do

Em algumas situações,

mesmo sendo linearmente

separáveis, os dados

apresentam ruı́dos

Para esses casos,

relaxamos as restrições do

SVM Fonte: [3]

yi (~

ω · ~

xi + b) ≥ 1 − ξi

onde ξi ≥ 0 é uma variável de folga

Norton Trevisan Roman(norton@usp.br) 27 de maio de 2019 20 / 35](https://image.slidesharecdn.com/aula21-210424145517/85/ACH2044-Inteligencia-Artificial-Aula-21-49-320.jpg)

![SVM Linear com Margens Suaves

Dados com ruı́do

O classificador permite

que alguns exemplos

caiam no lado errado do

limite de decisão

Associa, contudo, uma

penalidade proporcional à

distância necessária para

movê-los de volta ao lado

certo Fonte: [3]

Norton Trevisan Roman(norton@usp.br) 27 de maio de 2019 21 / 35](https://image.slidesharecdn.com/aula21-210424145517/85/ACH2044-Inteligencia-Artificial-Aula-21-50-320.jpg)

![SVM Linear com Margens Suaves

Dados com ruı́do

O resultado é a mesma

expressão para o

classificador com margens

rı́gidas

Mas com uma expressão

diferente para αi (e

consequentes ω e b)

Não veremos detalhes aqui Fonte: [3]

Norton Trevisan Roman(norton@usp.br) 27 de maio de 2019 22 / 35](https://image.slidesharecdn.com/aula21-210424145517/85/ACH2044-Inteligencia-Artificial-Aula-21-51-320.jpg)

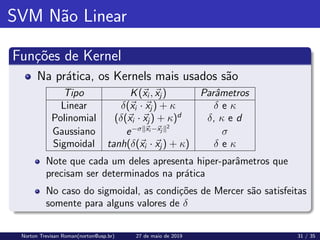

![SVM Não Linear

Funções de Kernel

E podemos usar qualquer função como Kernel?

Não. Apenas funções que satisfaçam as condições

estabelecidas pelo teorema de Mercer

Um Kernel que satisfaz as condições de Mercer dá

origem a matrizes positivas semi-definidas [K]

Em que cada elemento Kij é definido como Kij = K(~

xi , ~

xj ),

para i, j = 1, . . . , n

Norton Trevisan Roman(norton@usp.br) 27 de maio de 2019 30 / 35](https://image.slidesharecdn.com/aula21-210424145517/85/ACH2044-Inteligencia-Artificial-Aula-21-65-320.jpg)