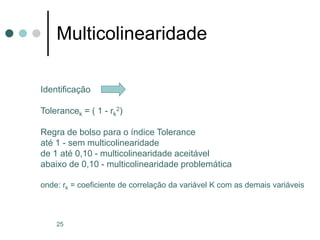

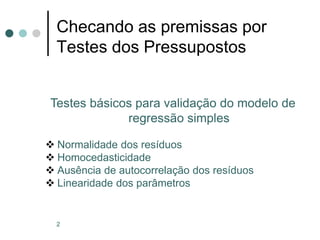

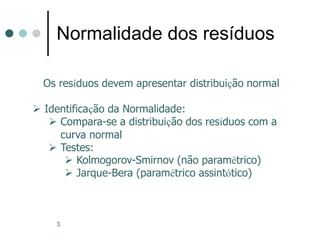

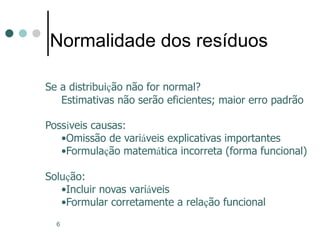

O documento discute a análise de pressupostos da regressão linear, incluindo normalidade dos resíduos, homocedasticidade e ausência de autocorrelação. Para cada pressuposto, são apresentados testes específicos e suas interpretações, bem como consequências e possíveis soluções em caso de violações. Além disso, abrange a multicolinearidade e suas implicações na regressão múltipla, juntamente com métodos para identificação e avaliação desta condição.

![5

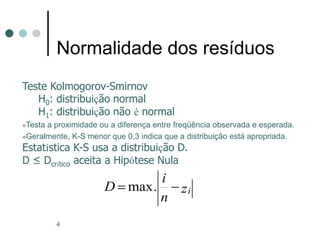

Normalidade dos resíduos

Teste de Jarque-Bera

H0: distribuição normal

H1: distribuição não é normal

JB ≤ JBcrítico aceita a Hipótese Nula

Estatística JB qui-quadrado (א2) (com 2 gl)

JB = n . [ A2/6 + (C-3)2/24]

onde:

A = assimetria

C = curtose](https://image.slidesharecdn.com/multicolinearidade-240602193350-a7809c1a/85/regressao-linear-multicolinearidade-ppt-5-320.jpg)

![22

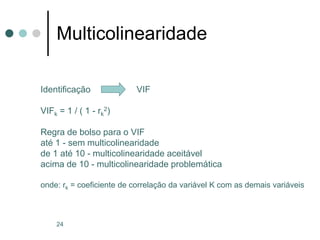

Multicolinearidade

Identificação Teste de Farrar & Glauber

c2 crítico com g.l. = k . (k-1) / 2

1 r12 ........r1k

c2 = -[n - 1 - 1/6 . (2.k+5)] . Ln(det r21 1 ........r2k )

rk1 rk2 ........ 1

onde: n = número de observações

k = número de variáveis

Ln = logaritmo neperiano

det = determinante

rij = coeficiente de correlação parcial](https://image.slidesharecdn.com/multicolinearidade-240602193350-a7809c1a/85/regressao-linear-multicolinearidade-ppt-22-320.jpg)