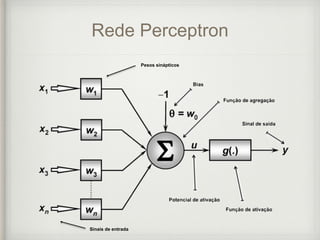

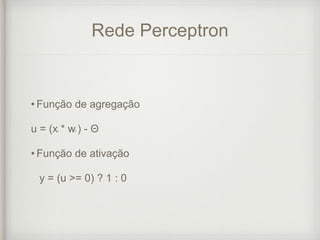

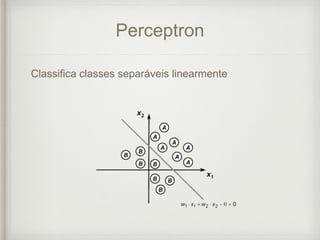

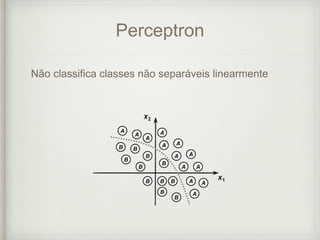

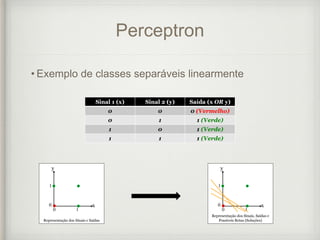

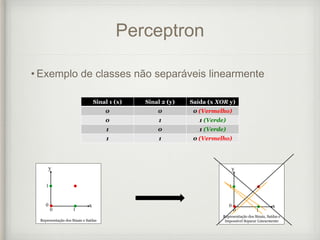

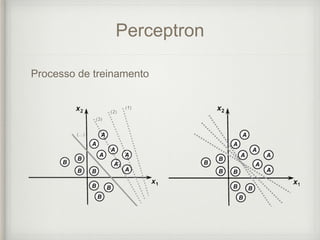

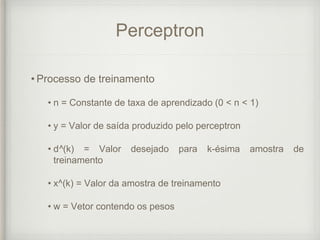

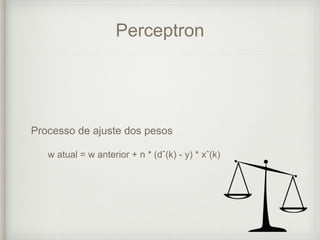

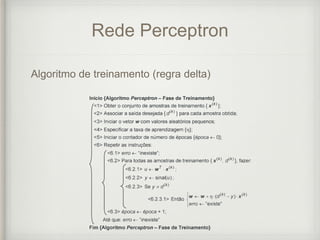

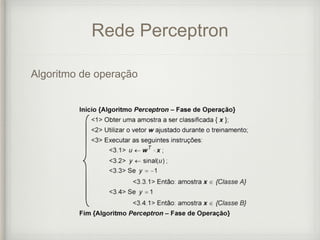

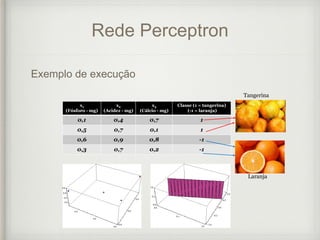

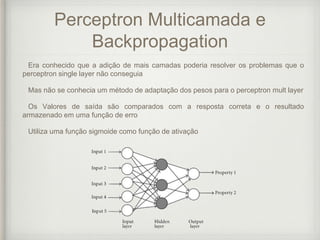

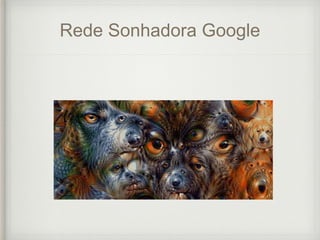

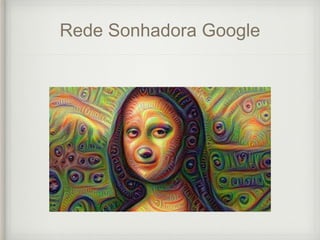

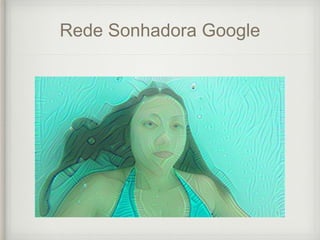

Este documento discute redes neurais artificiais, incluindo neurônios naturais e artificiais, o histórico do desenvolvimento de redes neurais, perceptrons, redes perceptron multicamadas e backpropagation. Exemplos recentes de aplicações de redes neurais como Neurogrid, redes sonhadoras do Google e sistemas de reconhecimento de voz e imagens também são discutidos.