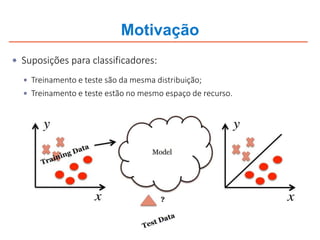

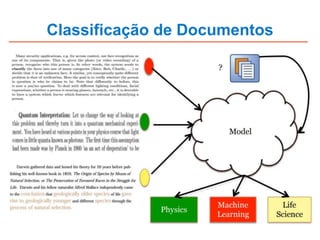

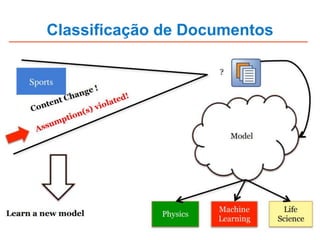

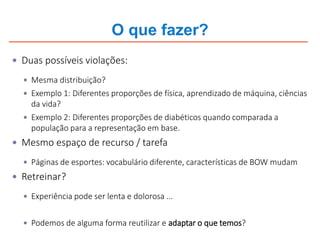

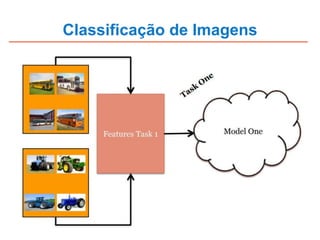

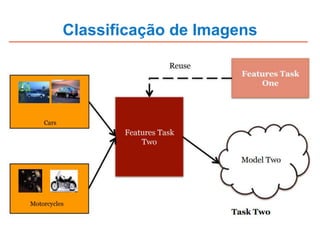

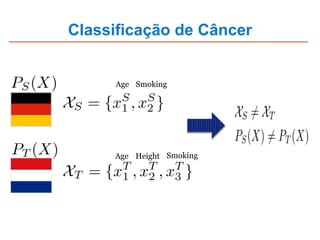

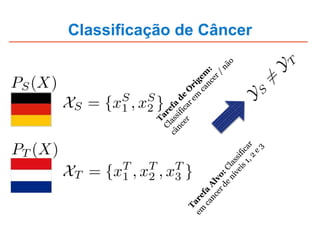

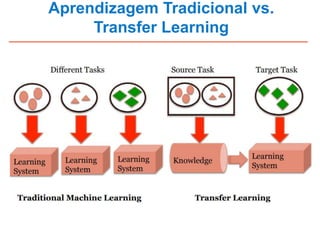

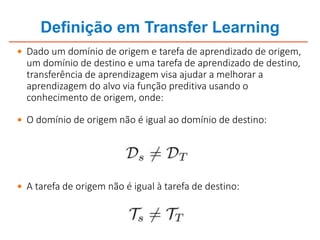

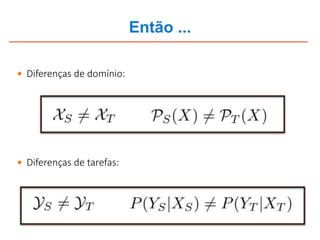

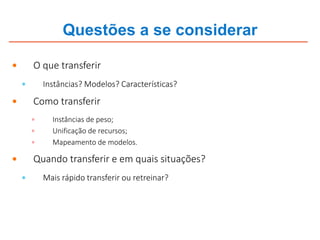

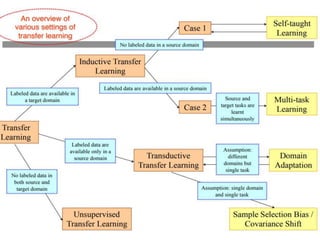

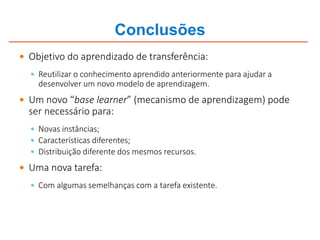

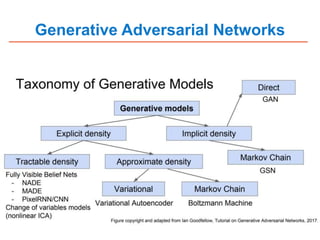

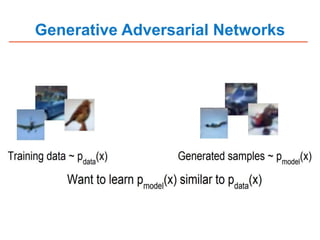

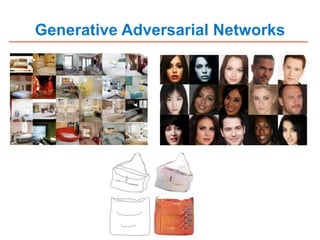

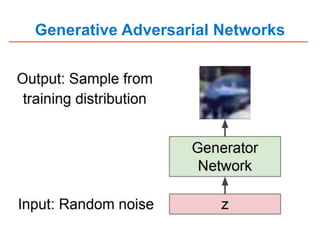

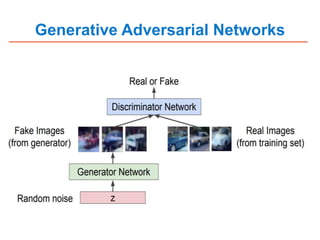

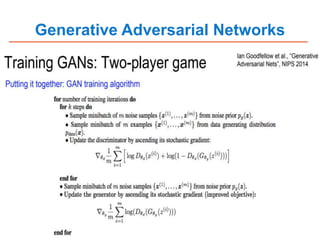

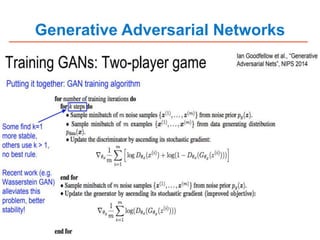

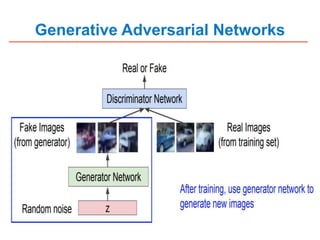

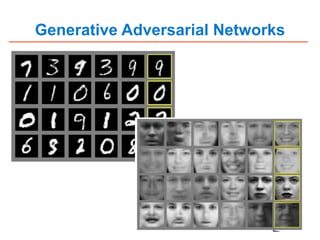

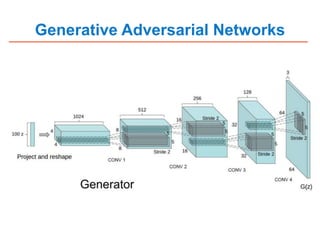

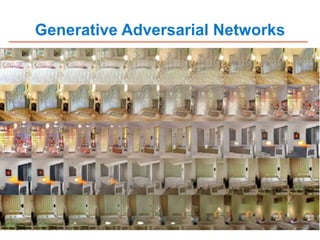

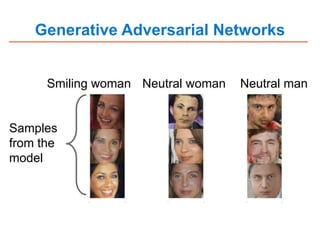

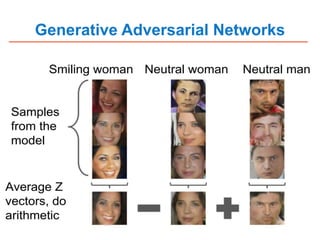

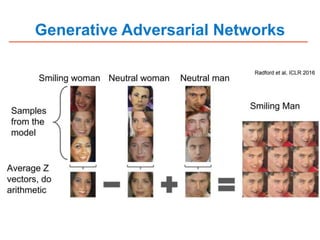

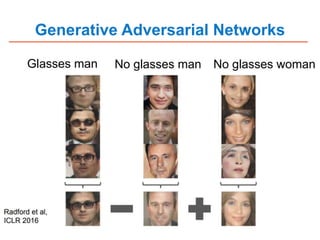

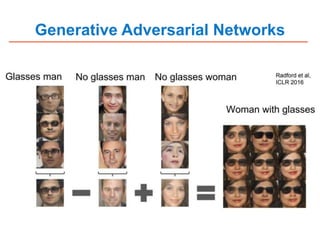

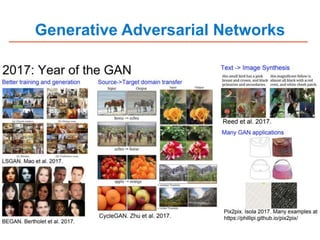

O documento discute transfer learning e GANs. Ele explica como o conhecimento prévio pode ser reutilizado em novos modelos de aprendizado de máquina através de transfer learning ou redes adversárias generativas. Transfer learning pode ajudar a aplicar classificadores existentes a novos problemas ou domínios, enquanto GANs geram novos dados sintéticos que imitam os dados reais.