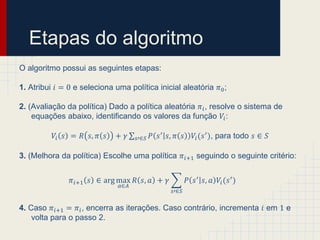

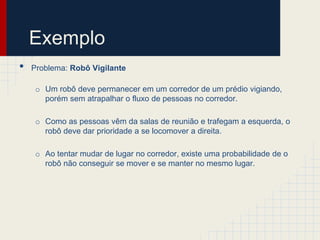

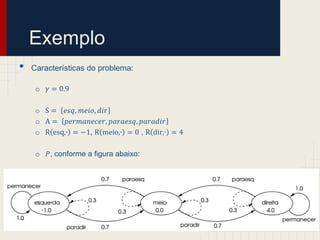

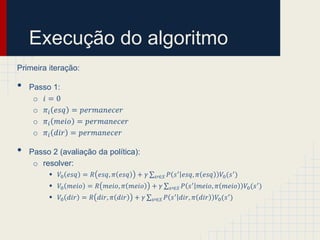

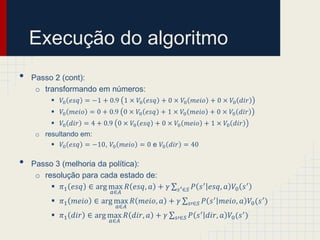

O documento descreve um algoritmo de iteração de políticas para resolver problemas de decisão de Markov. Ele começa com uma política aleatória e repetidamente avalia e melhora a política atual até convergir para uma política ótima. O algoritmo é demonstrado em um exemplo de um robô que deve patrular um corredor.

![Processo de Decisão Markoviano

• Para resolver um Processo de Decisão Markoviano, consideramos a

seguinte estrutura de tupla 𝑀 = 𝑆, 𝐴, 𝑃, 𝑅 , onde:

o 𝑆 é o conjunto finito de estados possíveis do problema

o 𝐴 é o conjunto finito de ações executáveis no ambiente do

problema

o 𝑃 ∶ 𝑆 × 𝐴 × 𝑆 ↦ [0,1] é uma função de transição de estados

probabilística

o 𝑅 ∶ 𝑆 × 𝐴 ↦ ℜ é uma função que associa uma recompensa a uma

ação aplicada em um determinado estado

• Uma solução para um MDP pode ser dada pela função 𝜋 ∶ 𝑆 ↦ 𝐴, que

define qual ação será tomada dado um estado. Esta função é chamada

de política de um MDP.](https://image.slidesharecdn.com/iteraodepoltica-121004232343-phpapp02/85/Iteracao-de-politica-3-320.jpg)