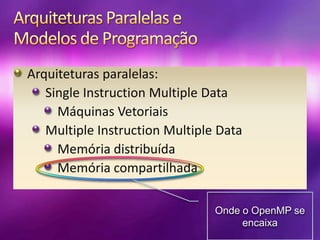

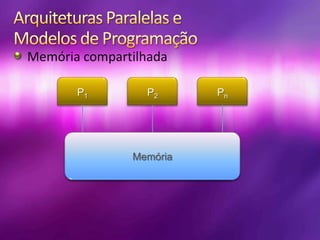

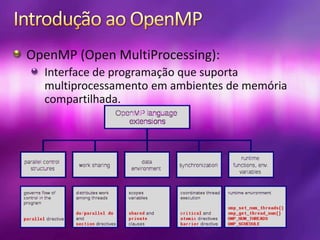

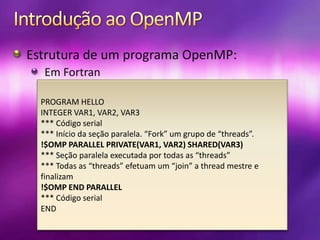

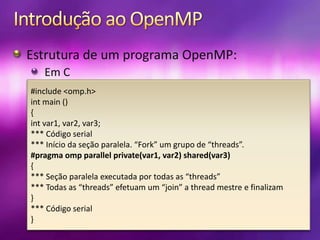

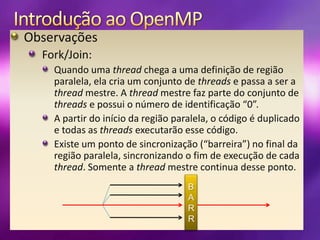

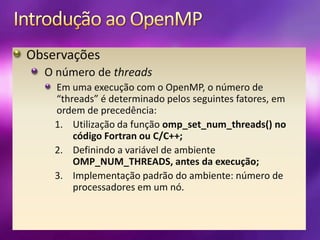

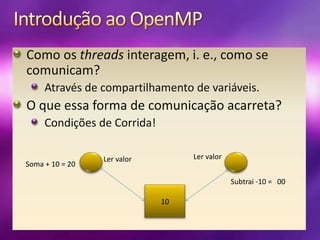

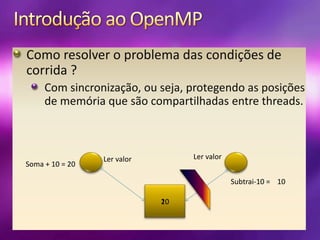

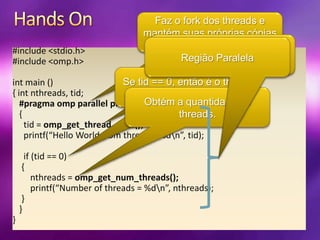

O documento apresenta uma introdução ao OpenMP, que é uma interface para programação paralela em ambientes de memória compartilhada. Ele discute conceitos de threads, gerenciamento de paralelismo, estruturas de programas em Fortran e C, e destaca a importância da sincronização para evitar condições de corrida. Por meio de exemplos práticos, o documento também esclarece como gerenciar o número de threads e regiões paralelas.