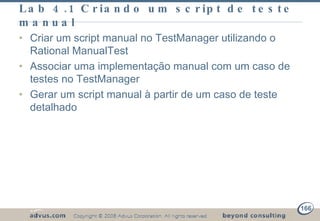

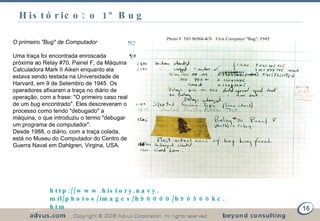

O documento apresenta um plano de treinamento sobre testes funcionais que inclui três dias de aulas. No primeiro dia serão abordados fundamentos de testes e derivação de casos de teste a partir de casos de uso. Nos dias seguintes serão apresentados recursos de uma ferramenta de teste funcional e realizados laboratórios sobre projeto de testes, criação de scripts manuais e automatizados e geração de relatórios.

![Motivação técnica Tempo do Projeto aplicado em Testes (aceitação + homologação) 15-40% (Média 23%) Maturidade do Processo de Testes (TPI/TMM) 1.3 [escala 1-5] Índice de Retrabalho 25-70% [média 32%] Proporção de falhas especificação/programação 1,6:1 [62%] Eficácia dos Testes 18-75% [média 35%] Custo dos Testes (% custo dos projetos gastos em Testes, prevenção e correção) 45%-60% [média 52%]](https://image.slidesharecdn.com/testesfuncionaiscompleto-12569300287194-phpapp01/85/Testes-Funcionais-10-320.jpg)

![Workflow da Disciplina de Testes Definir Missão de Avaliação Verificar Enfoque do Teste Validar Estabilidade da Construção [Outra Técnica] Testar e Avaliar Avaliar Missão de Aceitação Aprimorar Ativos de Testes [Outro Ciclo de Teste]](https://image.slidesharecdn.com/testesfuncionaiscompleto-12569300287194-phpapp01/85/Testes-Funcionais-40-320.jpg)