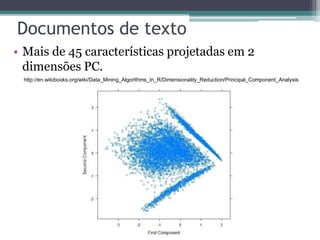

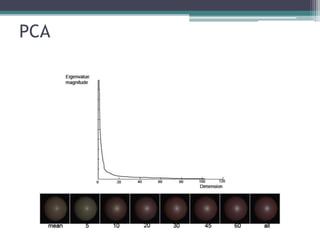

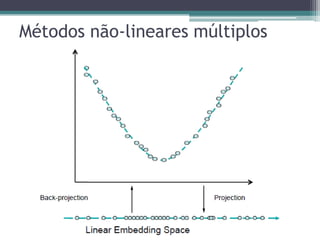

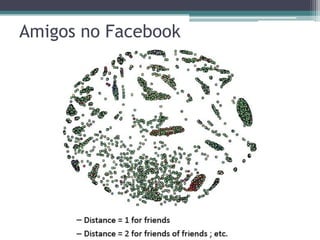

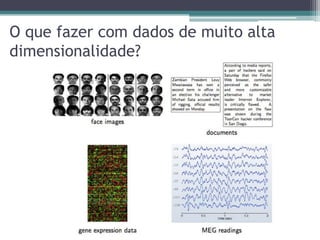

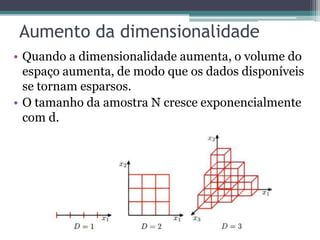

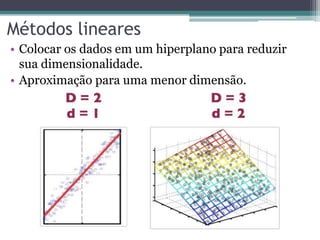

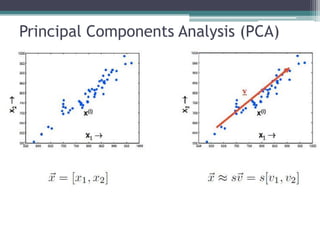

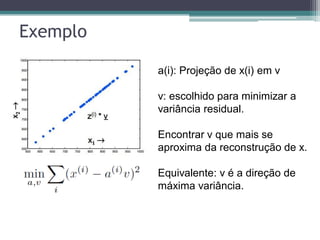

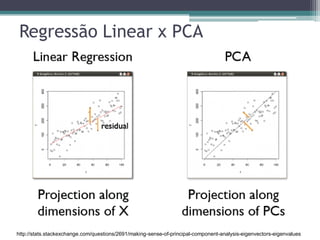

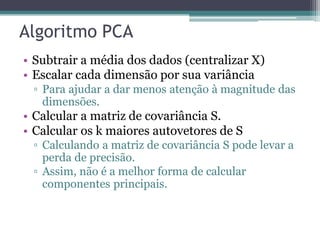

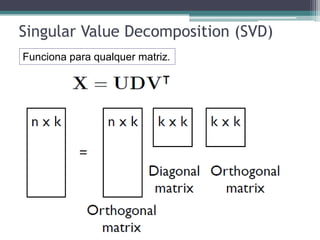

O documento discute técnicas para lidar com dados de alta dimensionalidade, incluindo redução de dimensionalidade linear como PCA e não-linear como Isomap. Exemplos demonstram como PCA pode ser usado para reduzir a dimensionalidade de imagens de rostos e documentos de texto, preservando a maior parte da variância. Métodos não-lineares são necessários quando os dados não são linearmente separáveis.

![Autofaces

• Podemos reconstruir cada face como uma combinação linear

“faces” base ou autofaces [M. Turk and A. Pentland (1991)].

Face média

Autofaces](https://image.slidesharecdn.com/apresentacao-highdimensionaldata-140614072319-phpapp01/85/High-Dimensional-Data-60-320.jpg)