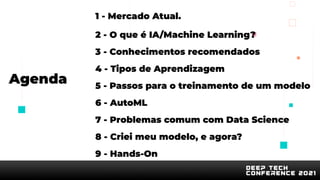

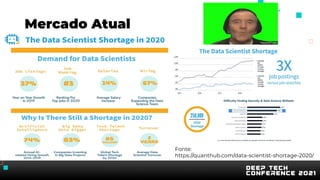

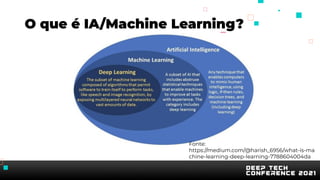

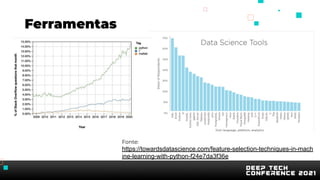

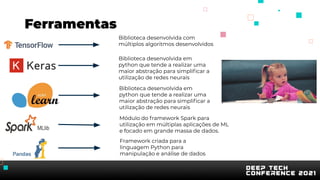

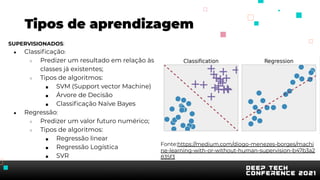

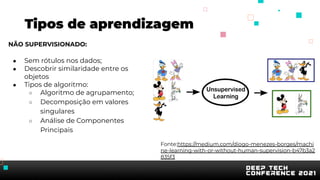

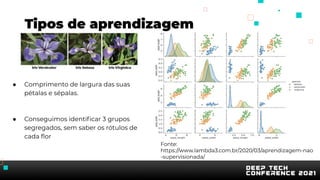

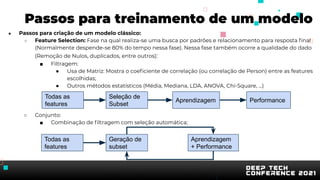

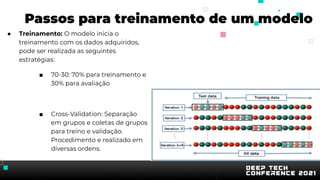

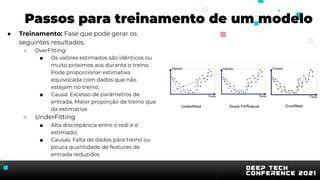

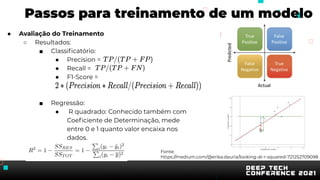

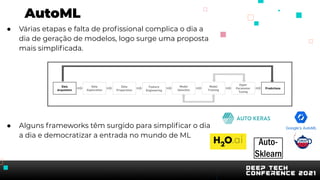

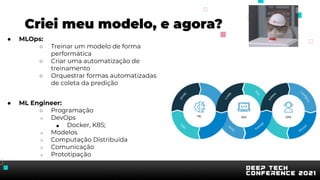

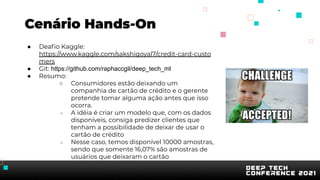

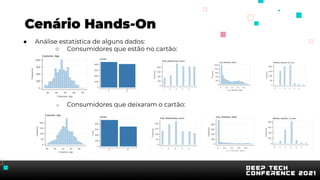

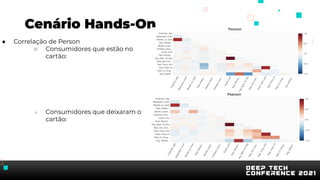

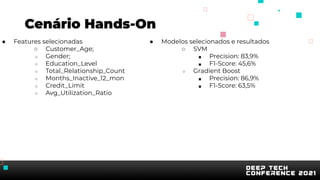

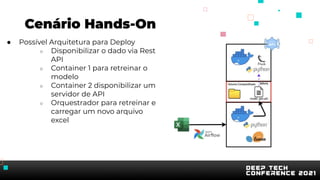

O documento apresenta uma introdução sobre inteligência artificial e machine learning. A agenda inclui tópicos como o mercado atual, definição de IA/ML, conhecimentos recomendados, tipos de aprendizagem, passos para treinamento de modelos, AutoML, problemas comuns e implementação de modelos. O palestrante também apresenta uma demonstração prática usando um conjunto de dados sobre clientes de cartão de crédito.