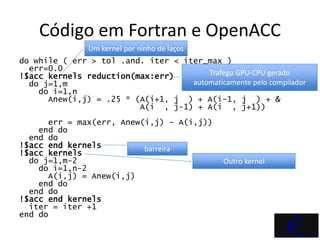

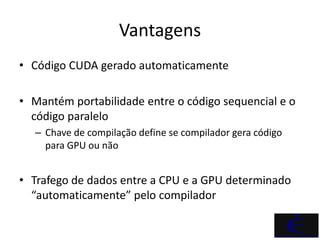

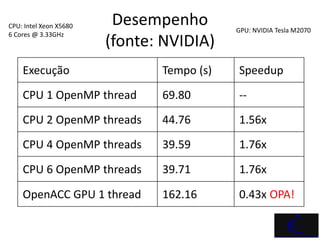

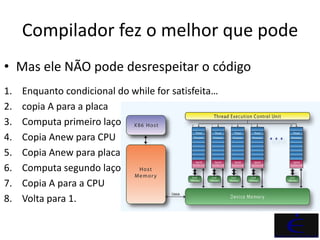

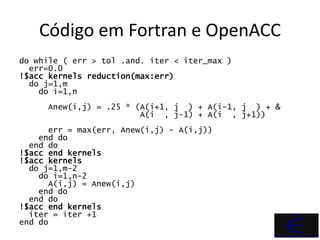

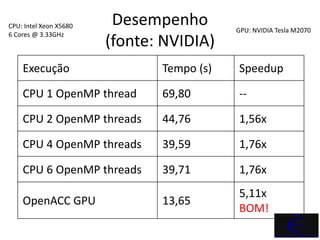

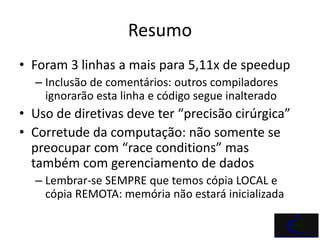

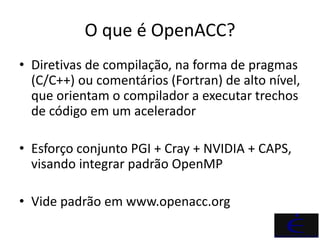

OpenACC é um padrão que permite a aceleração de códigos por meio de diretivas de compilação que orientam o compilador a utilizar aceleradores como GPUs. O documento detalha exemplos práticos de uso de OpenACC em Fortran, demonstrando sua eficácia na melhoria de desempenho e portabilidade do código. Além disso, apresenta comparações de desempenho entre execução em CPU e GPU, ressaltando o aumento significativo de speedup obtido com a implementação de OpenACC.

![Sintaxe

• C:

#pragma acc nome_diretiva [cláusula [,cláusula]…]

bloco estruturado de código

• Fortran:

!$acc nome_diretiva [cláusula [,cláusula]…]

bloco estruturado de código

!$acc end nome_diretiva](https://image.slidesharecdn.com/jpanetta-aula4-parte2-120731125046-phpapp02/85/Introducao-ao-Processamento-Paralelo-4-2-3-320.jpg)