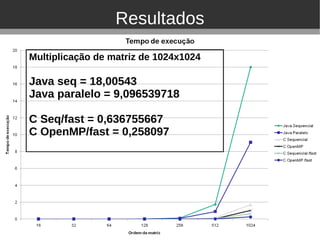

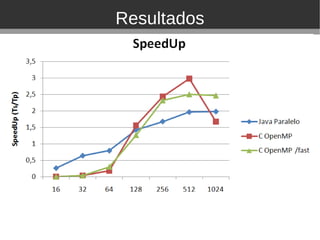

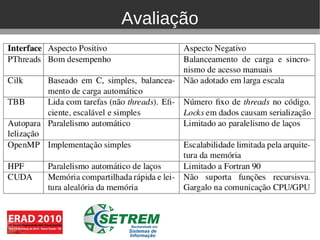

O documento discute ferramentas de programação paralela para arquiteturas multicore, incluindo Pthreads, Cilk, TBB, OpenMP, HPF e CUDA. Ele apresenta exemplos de aplicações paralelas em áreas como medicina, meteorologia e astronomia. Resultados experimentais mostram que OpenMP e C paralelo podem acelerar multiplicação de matrizes em relação a sequencial.