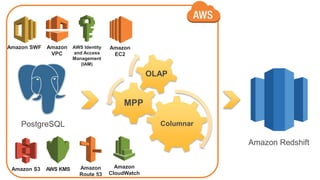

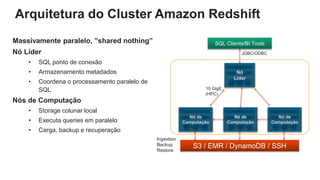

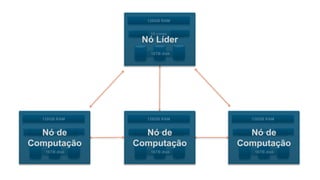

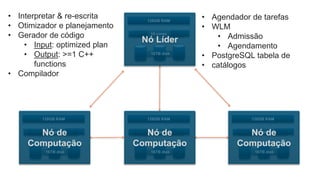

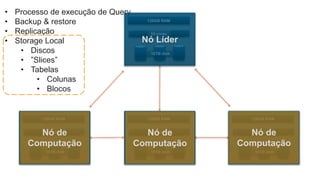

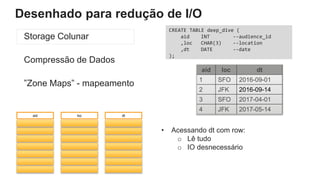

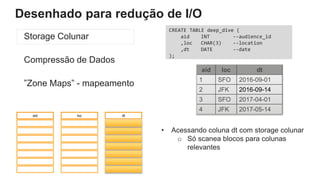

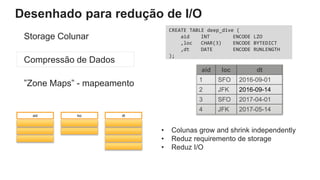

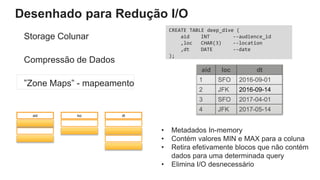

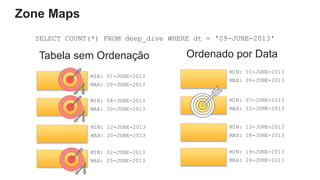

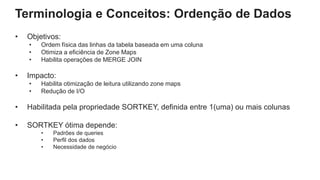

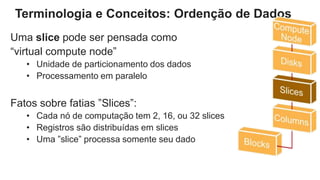

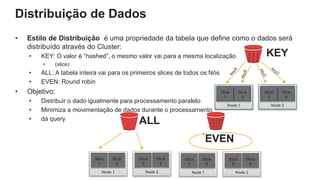

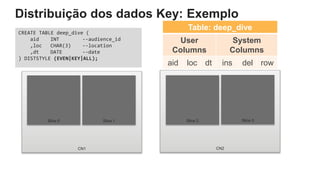

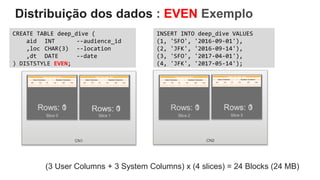

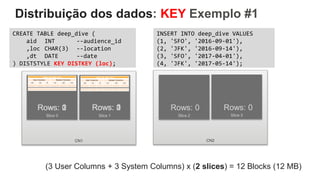

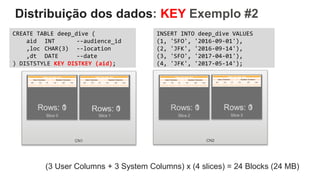

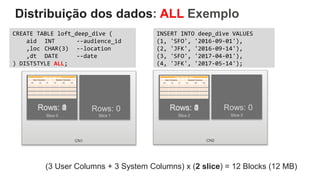

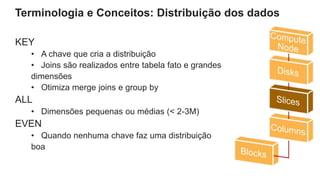

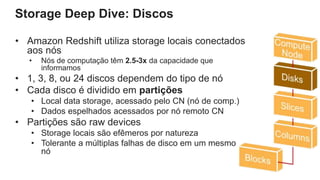

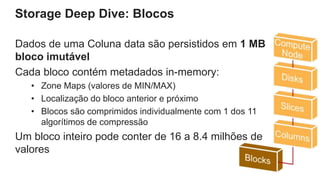

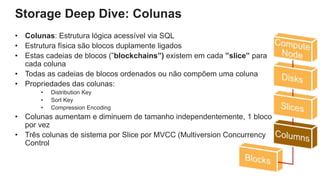

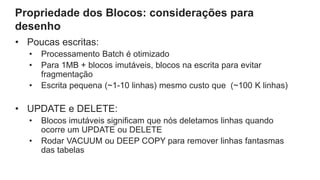

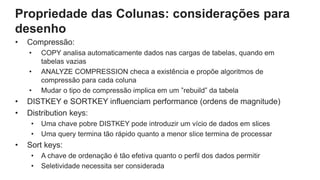

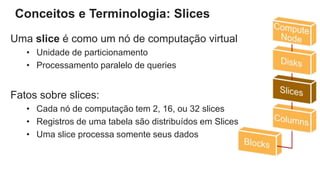

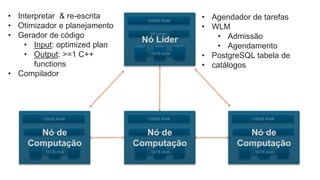

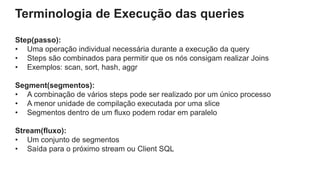

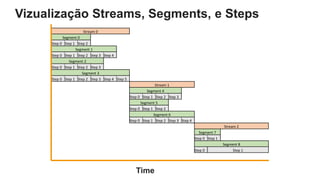

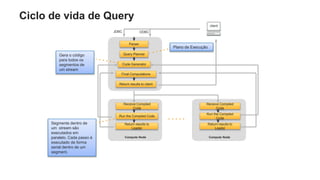

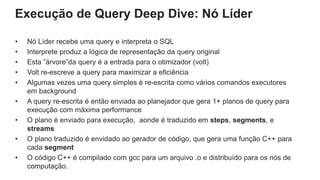

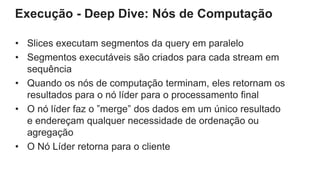

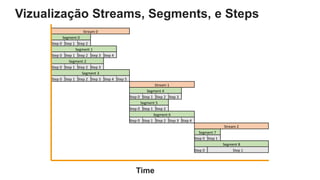

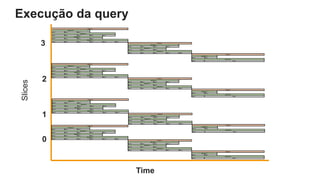

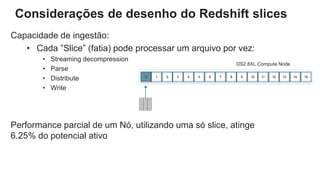

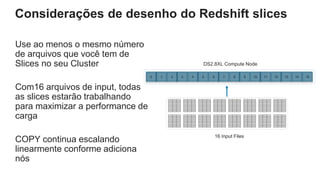

O documento é uma apresentação técnica sobre o Amazon Redshift, abordando sua arquitetura e o ciclo de vida das consultas. Ele detalha a armazenamento colunar, a compressão de dados, a distribuição de dados em 'slices' e o funcionamento dos nós de computação. Além disso, discute conceitos como zone maps, sort keys e o processo de execução de queries, ilustrando como esses elementos colaboram para otimizar desempenho e eficiência.