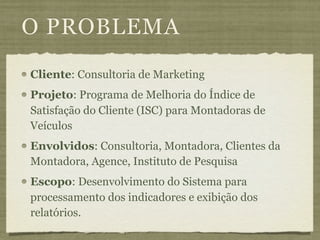

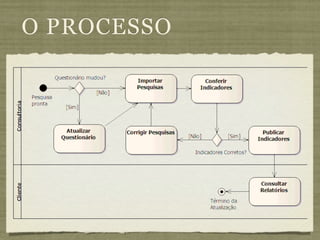

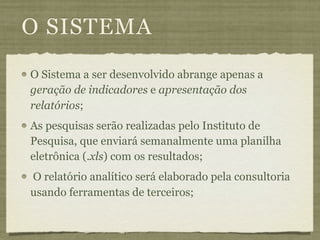

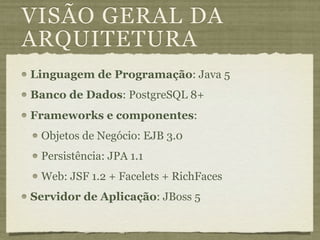

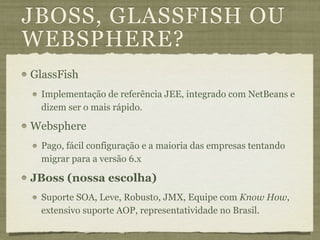

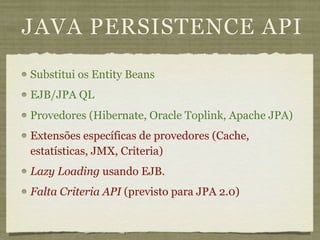

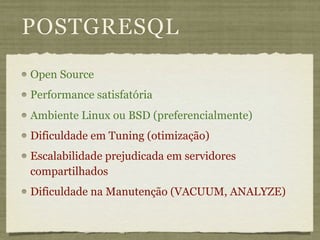

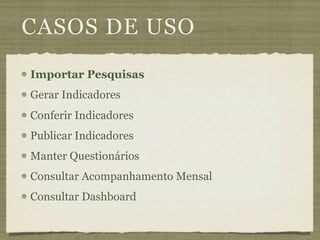

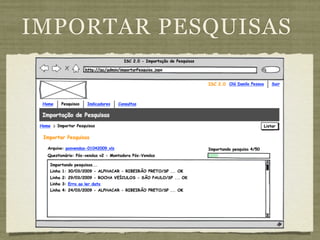

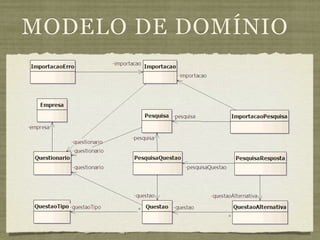

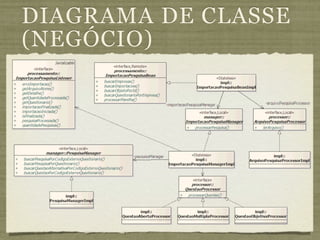

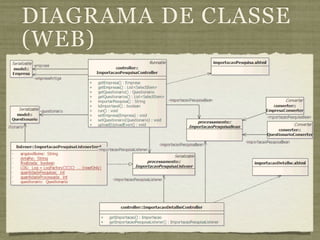

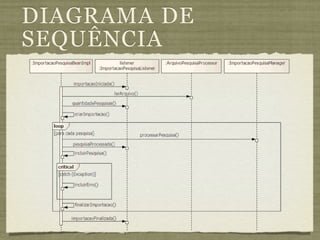

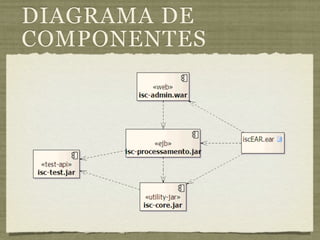

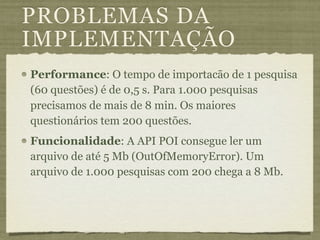

O documento descreve um sistema para gerar indicadores de satisfação de clientes para montadoras de veículos. O sistema irá importar pesquisas de satisfação, gerar os indicadores, e disponibilizar relatórios. As tecnologias escolhidas foram Java, EJB, JPA, JSF e JBoss para aproveitar as vantagens da plataforma Java e padrões JEE.