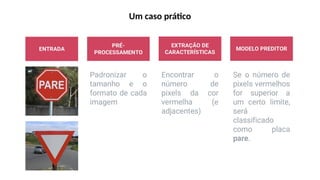

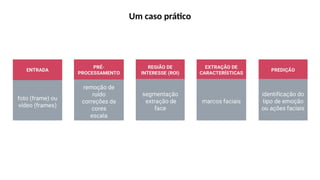

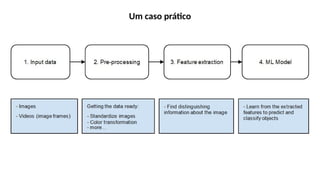

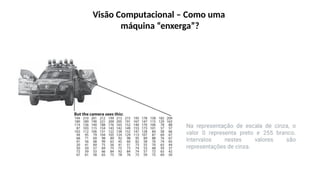

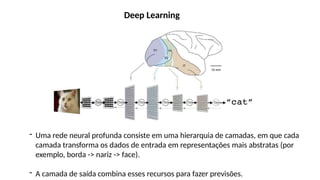

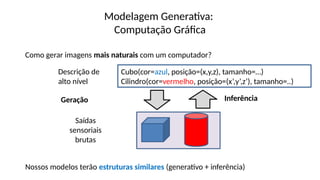

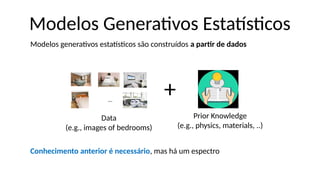

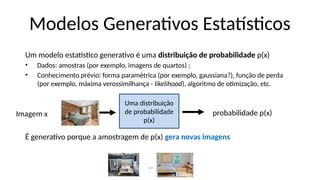

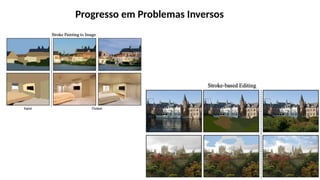

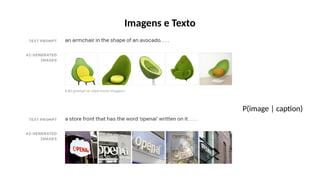

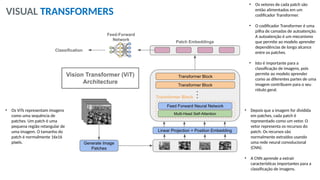

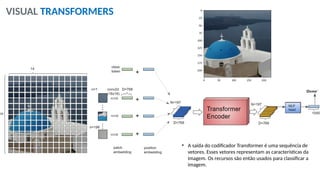

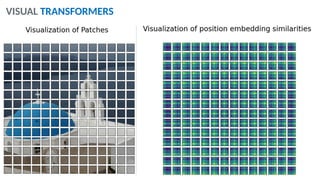

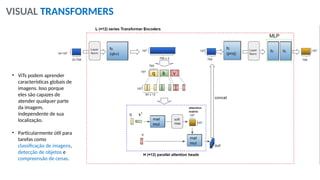

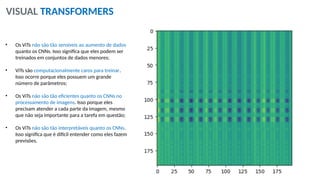

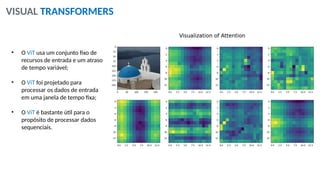

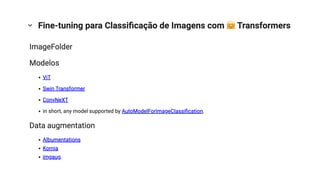

O documento aborda a visão computacional, explorando como máquinas podem 'enxergar' através de deep learning e inteligência artificial generativa. Discute técnicas, desafios e soluções na modelagem generativa, destacando o uso de visual transformers e suas implicações em tarefas de classificação e compreensão de imagens. O autor enfatiza a importância de sistemas de visão computacional que garantam inteligibilidade, conscientização sobre dados e segurança.