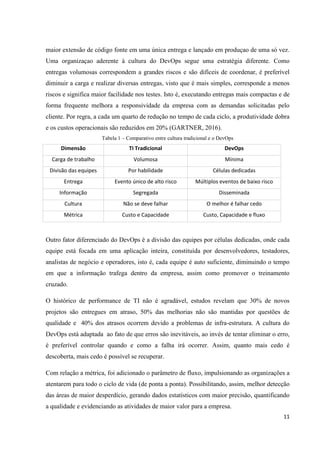

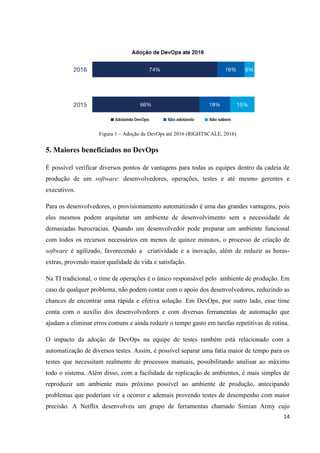

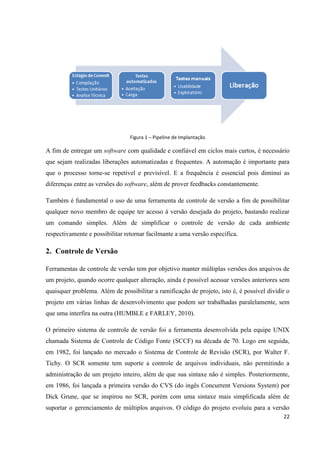

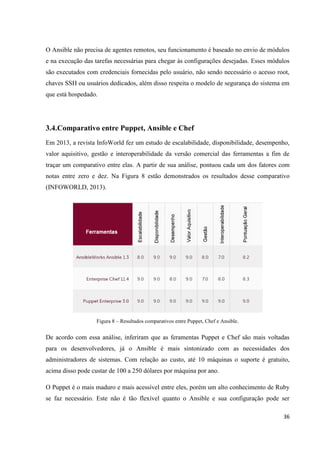

Este documento apresenta o crescimento da cultura DevOps no mercado de tecnologia da informação. Ele descreve os principais conceitos de DevOps como automação, colaboração entre equipes de desenvolvimento e operações, e entrega contínua. Além disso, explica ferramentas populares de DevOps como Docker, Chef e Puppet que auxiliam na automação de processos.