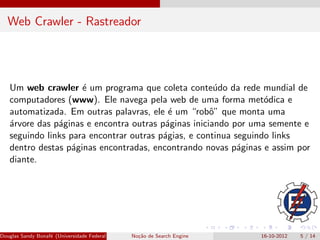

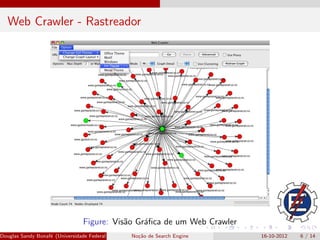

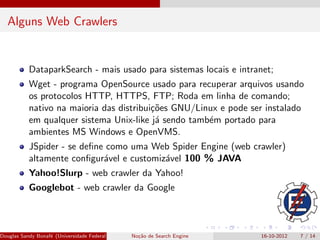

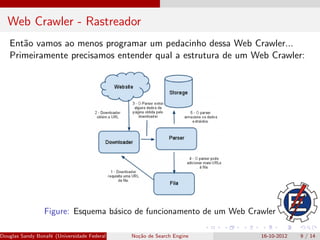

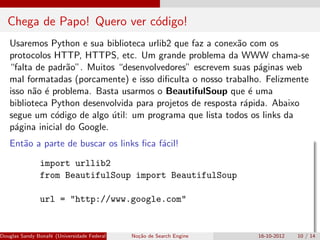

O documento explora o funcionamento de motores de busca, com ênfase em web crawlers, que são programas automatizados que coletam conteúdo da web. Aborda também a importância da programação em Python para desenvolver esses crawlers, utilizando bibliotecas como urllib2 e BeautifulSoup. Por fim, o autor compartilha exemplos práticos de código para listar links a partir de uma página web.

![Chega de Papo! Quero ver c´digo!

o

Ent˜o a parte de buscar os links fica f´cil!

a a

request = urllib2.Request(url)

response = urllib2.urlopen(request)

document = response.read()

#normaliza o documento para que o mesmo seja acess´vel v

ı

soup = BeautifulSoup(document)

# retorna uma lista com todos os links do documento

links = soup.findAll(’a’)

for link in links:

print link[’href’]

Douglas Sandy Bonaf´ (Universidade Federal de Itajub´ No¸˜o de Search Engine

e a - UNIFEI IESTI)

ca 16-10-2012 11 / 14](https://image.slidesharecdn.com/palestrase-121017055852-phpapp02/85/Nocoes-de-Search-Engine-11-320.jpg)