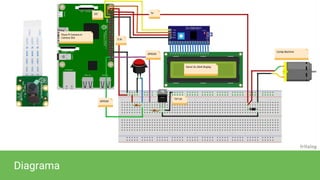

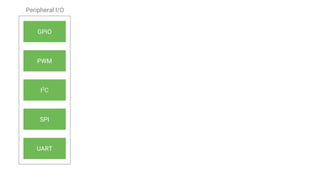

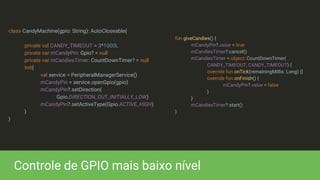

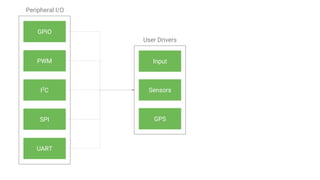

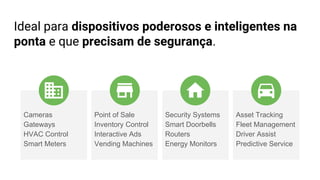

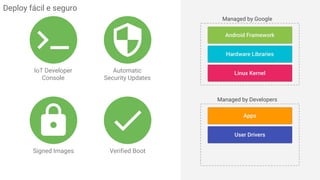

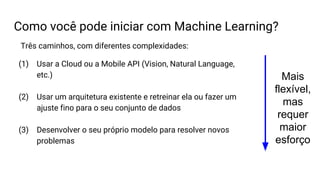

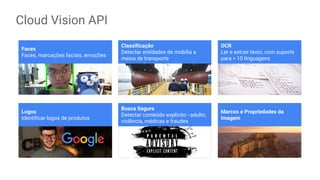

Este documento aborda o uso de Android Things e IoT para desenvolvimento de aplicações, com foco em segurança e prototipagem de dispositivos. Existem discussões sobre machine learning, APIs de visão computacional, reconhecimento de fala e integrações práticas com dispositivos embarcados. Exemplos práticos são fornecidos, incluindo a criação de uma máquina inteligente de doces e leitura de botões com GPIO.

![Escalar S = 42

Vetor V = [1, 2, 3, 4]

Matriz M = [[1, 0],[0, 1]]

Cubo ...

Vetor n-dimensional, onde n = [0, 1, 2, 3, ...]](https://image.slidesharecdn.com/androidthingsandmachinelearning-170522135019/85/Internet-das-Coisas-com-Android-things-e-Machine-Learning-51-320.jpg)

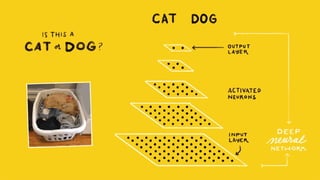

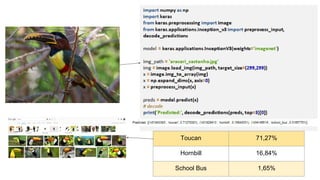

![Import keras

img_width, img_height, img_channels = 120, 120, 3

train_data_dir = 'train'

validation_data_dir = 'valid'

nb_train_samples = 4000

nb_validation_samples = 400

epochs = 1

batch_size = 32

a = Input(shape=(img_width, img_height, img_channels))

model = keras.applications.inception_v3.InceptionV3(weights='imagenet', include_top=False, input_tensor=a)

model.trainable = False

x = model.output

x = keras.layers.Flatten()(x)

x = keras.layers.Dense(256, activation='relu')(x)

x = keras.layers.Dropout(0.5)(x)

predictions = keras.layers.Dense(1, activation='sigmoid')(x)

model_final = keras.models.Model(inputs=model.input, outputs=predictions)

model_final.compile(loss='binary_crossentropy', optimizer="adadelta", metrics=['accuracy'])

Predito: Cachorro

Predito: Gato](https://image.slidesharecdn.com/androidthingsandmachinelearning-170522135019/85/Internet-das-Coisas-com-Android-things-e-Machine-Learning-58-320.jpg)

![from keras.models import Sequential

from keras.layers import Dense

from keras.optimizers import RMSprop

from tensorflow.contrib.learn.python.learn.datasets.mnist import read_data_sets

mnist = read_data_sets( "MNIST_data/", one_hot=True)

batch_size = 100

epochs = 20

x_train, y_train = mnist.train.next_batch( 50000)

x_test, y_test = mnist.test.next_batch( 10000)

model = Sequential()

model.add(Dense( 32, activation='relu', input_shape =(784,)))

model.add(Dense( 128, activation='relu'))

model.add(Dense( 32, activation='relu'))

model.add(Dense( 10, activation='softmax'))

model.summary()

model.compile( loss='categorical_crossentropy', optimizer=RMSprop(), metrics=['accuracy'])

history = model.fit(x_train, y_train, batch_size=batch_size, verbose=1, validation_data =(x_test, y_test))

score = model.evaluate(x_test, y_test, verbose=0)

print('Test loss:', score[0])

print('Test accuracy:', score[1])

model.save( 'my_model.h5')](https://image.slidesharecdn.com/androidthingsandmachinelearning-170522135019/85/Internet-das-Coisas-com-Android-things-e-Machine-Learning-60-320.jpg)