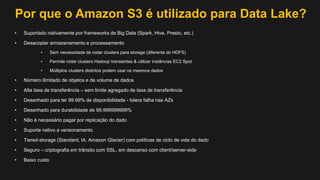

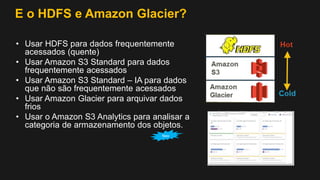

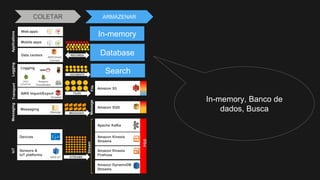

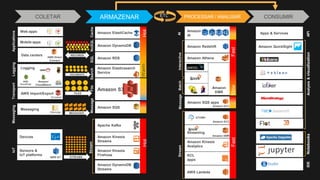

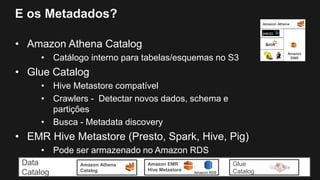

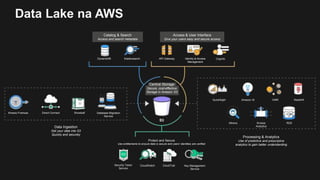

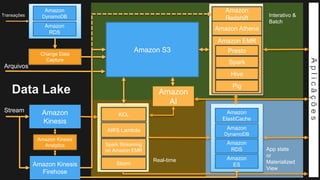

1) O documento discute como construir um Data Lake na AWS utilizando várias tecnologias da AWS.

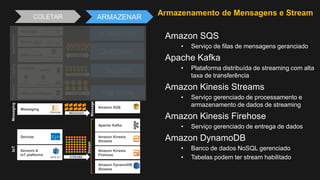

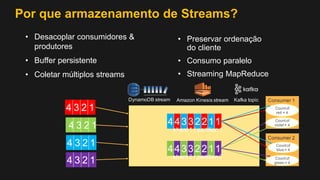

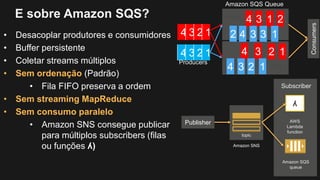

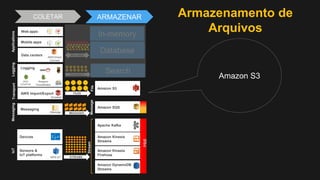

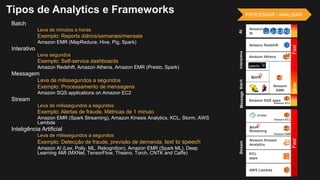

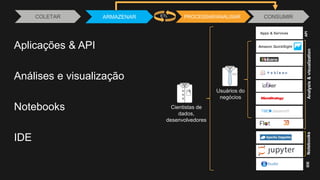

2) É apresentada uma agenda com conceitos de Data Lake, simplificando o Data Lake e quais tecnologias utilizar.

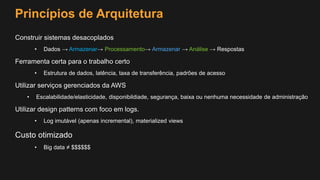

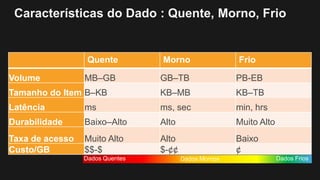

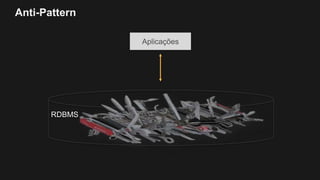

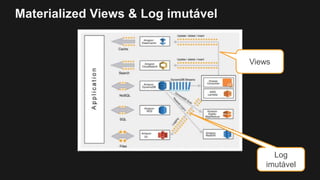

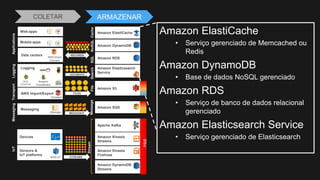

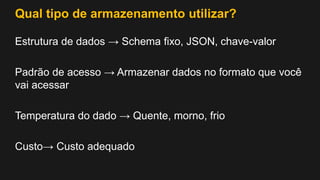

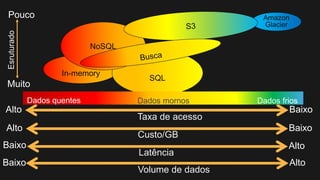

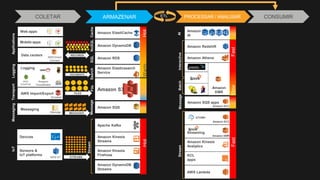

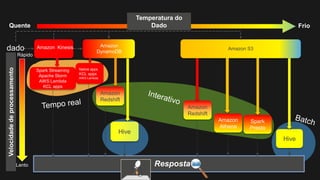

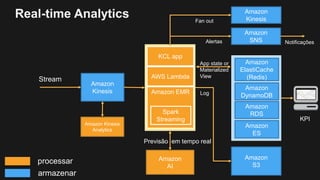

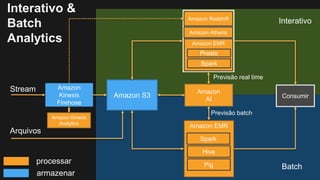

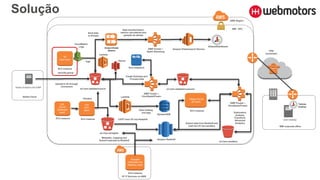

3) Uma arquitetura de referência e design patterns são discutidos.