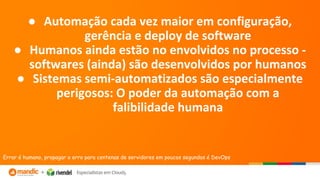

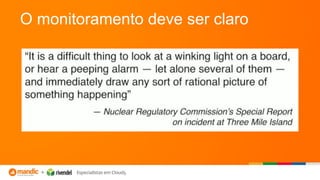

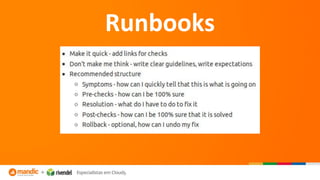

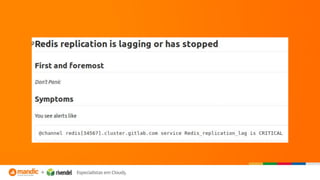

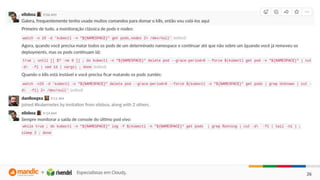

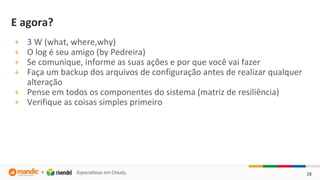

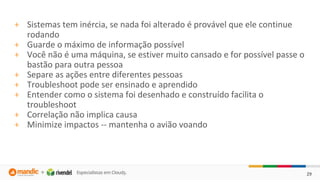

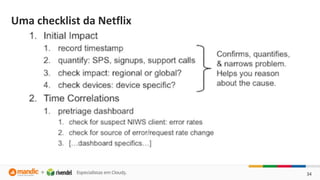

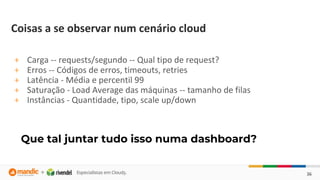

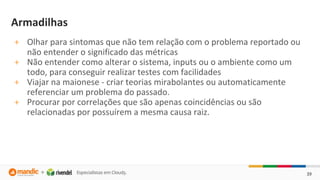

O documento discute a importância do monitoramento e da observabilidade para identificar problemas nos sistemas antes que aconteçam e entender as causas quando acontecem. Também fornece dicas sobre como realizar troubleshooting de forma estruturada utilizando checklists e evitando armadilhas comuns.