This document describes a web crawler project developed by Israel José da Cunha for the Distributed Systems course at Universidade do Vale do Sapucaí. It discusses the key aspects of web crawlers like crawling policies, prioritization strategies, and parallelization techniques. It also provides examples of Java code for implementing a web crawler class and controller class.

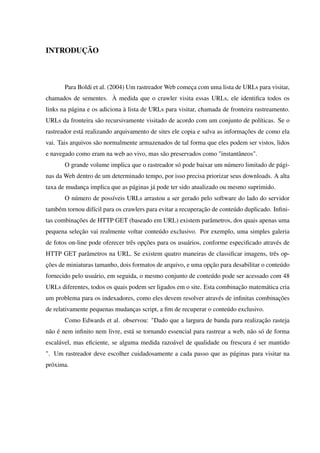

![Código 4 – Exemplo de classe de controle. Fonte: code.google.com/crawler4j

1

2 public class Controller {

3 public static void main(String [] args) throws Exception {

4 String crawlStorageFolder = "/data/crawl/root";

5 int numberOfCrawlers = 7;

6

7 CrawlConfig config = new CrawlConfig ();

8 config. setCrawlStorageFolder ( crawlStorageFolder );

9

10 PageFetcher pageFetcher = new PageFetcher(config);

11 RobotstxtConfig robotstxtConfig = new RobotstxtConfig

();

12 RobotstxtServer robotstxtServer = new RobotstxtServer (

robotstxtConfig , pageFetcher);

13 CrawlController controller = new CrawlController (

config , pageFetcher , robotstxtServer );

14

15

16 controller.addSeed("http :// www.univas.edu.br/menu/cpa/

apresentacao_cpa .asp");

17 controller.addSeed("http :// www.univas.edu.br/

portal_aluno.asp");

18 controller.addSeed("http :// www.univas.edu.br/");

19

20

21 controller.start(MyCrawler.class , numberOfCrawlers );

22 }

23 }

10](https://image.slidesharecdn.com/webcrawler-161218031303/85/Web-crawler-11-320.jpg)

![REFERÊNCIAS

BOLDI, P. et al. UbiCrawler: A Scalable Fully Distributed Web Crawler. [S.l.]: Università

degli Studi di Milano, University of Iowa, Università di Modena e Reggio Emilia, 2004.

CHO, H. G.-M. J.; PAGE, L. Efficient crawling through URL ordering. [S.l.]: Proceedings of

the Seventh World-Wide Web Conference, 1998.

DILIGENTI, M. et al. Focused Crawling Using Context Graphs. [S.l.]: Università di Siena,

2000.

GANJISAFFAR, Y. Sample Usage. 2013. <https://code.google.com/p/crawler4j/>. Acessado

em 20/05/2014.

ZEINALIPOUR-YAZTI, D.; DIKAIAKOS, M. Design and Implementation of Distributed.

[S.l.]: University of California, 2000.](https://image.slidesharecdn.com/webcrawler-161218031303/85/Web-crawler-13-320.jpg)