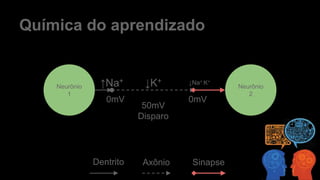

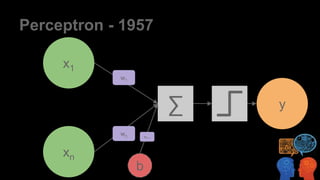

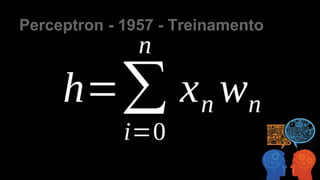

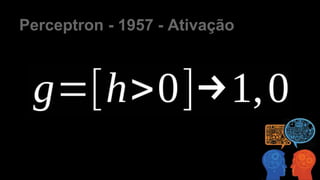

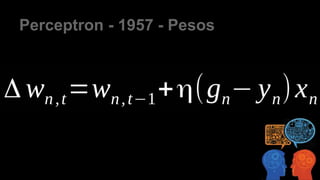

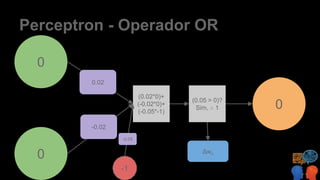

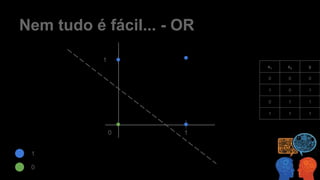

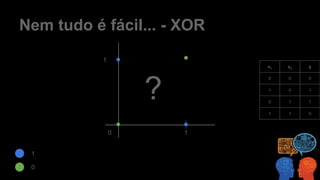

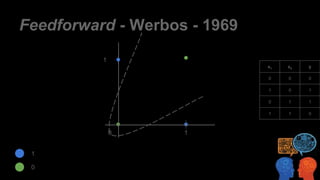

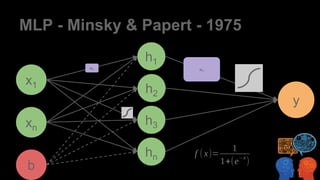

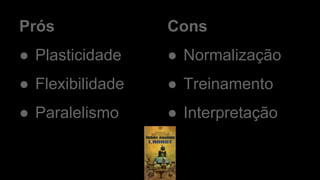

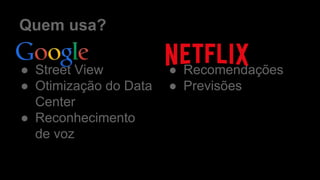

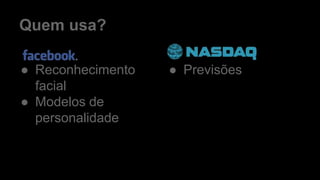

O documento discute redes neurais artificiais, abordando sua estrutura, funcionamento e evolução, desde os perceptrons até o deep learning. Destaca as vantagens, como plasticidade e flexibilidade, além das desvantagens relacionadas à normalização e interpretação. O uso atual dessas tecnologias em áreas como reconhecimento de imagem, recomendações e previsões é igualmente mencionado.