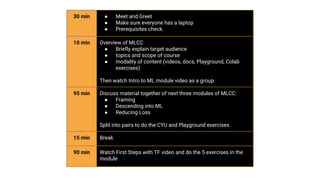

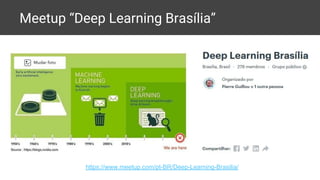

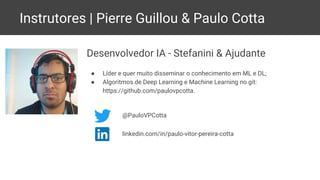

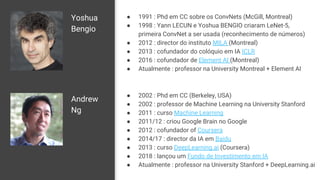

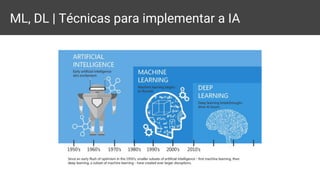

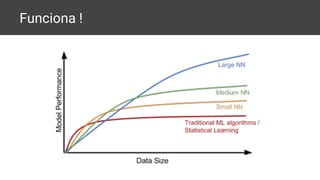

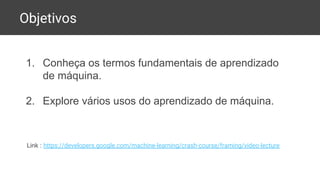

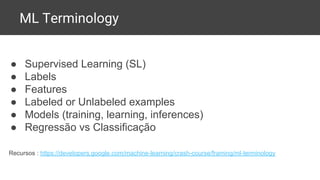

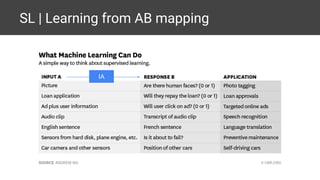

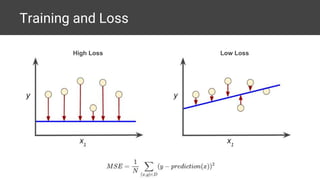

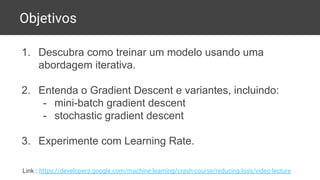

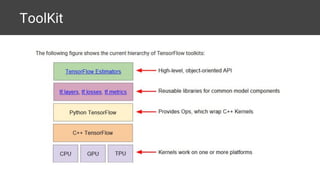

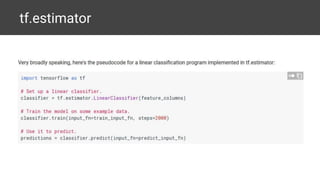

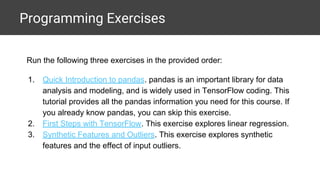

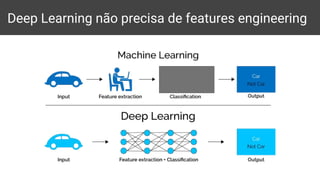

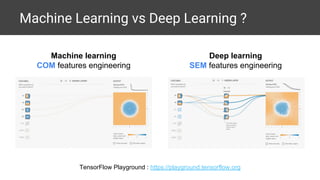

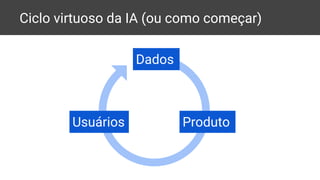

O 'Machine Learning Crash Course Study Jam' de Brasília, realizado em julho de 2018, abordou conceitos de inteligência artificial, aprendizado de máquina e aprendizado profundo, incluindo treinamento de modelos com TensorFlow. A agenda incluiu discussões sobre módulos do curso, vídeos informativos e exercícios práticos, liderados por instrutores experientes na área. O evento teve como objetivo fornecer uma compreensão prática do aprendizado de máquina e suas aplicações.