Este documento descreve um projeto sobre redes de alto débito e versões do protocolo TCP desenvolvidas para este tipo de redes. O projeto inclui um estudo das limitações do TCP original e das várias versões propostas para melhorar o desempenho em redes de alto débito e latência. Os autores irão implementar e testar uma nova abordagem para o TCP nestas redes, comparando a sua eficiência com outras versões existentes.

![Lista de Figuras

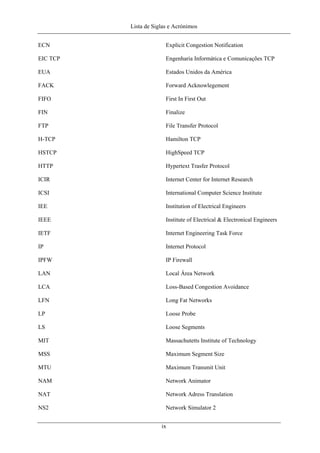

Lista de Figuras

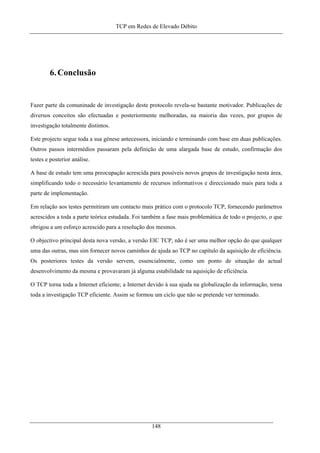

Figura 2.1 – Esquema resumido do processo de conhecimento para a nova versão do protocolo................3

Figura 2.2 – Intercepção da nova versão com a inovação e a precaução necessárias. ..................................5

Figura 2.3 – Representação da matéria que envolve o âmbito......................................................................6

Figura 2.4 – Representação do âmbito, considerando as várias interfaces do TCP. .....................................7

Figura 2.5 – Representação dos tipos de reacção e controlo.........................................................................8

Figura 2.6 – Localização do âmbito através de uma comunicação entre emissor, receptor e rede. ..............8

Figura 2.7 – Representação do WBS...........................................................................................................10

Figura 2.8 – Gráfico de Gantt, representativo da sequência e relacionamento entre actividade.................11

Figura 3.1 – Esquema representativo da relação entre o TCP e os custos económicos. .............................13

Figura 3.2 – Crescimento da largura de banda disponibilizada (Fonte: [67]). ............................................16

Figura 3.3 – Mapa representativo das diversas ligações de alto débito entre continentes (Fonte:

Telegeography Research)............................................................................................................................17

Figura 3.4 – Mapa representativo de toda a disponibilização de largura de banda para Internet nos

diversos continentes (Fonte: Telegeography Research)..............................................................................17

Figura 3.5 – Relação ano, largura de banda teórica disponibilizada e ligações intercontinentais (Fonte:

Telegeography Research)............................................................................................................................18

Figura 3.6 – Tráfego médio, gerado pelas diversas ligações intercontinentais (Fonte: Telegeography

Research).....................................................................................................................................................18

Figura 3.7 – Timeline de desenvolvimento TCP.........................................................................................20

Figura 3.8 – Representação da analogia entre uma região e as versões TCP..............................................23

Figura 3.9 – O Cabeçalho TCP. ..................................................................................................................31

Figura 3.10 – Primeiro segmento TCP de uma sessão de dados.................................................................34

Figura 3.11 – Primeiro segmento TCP, após estabelecimento da sessão....................................................34

Figura 3.12 – Exemplo de troca de dados 1. ...............................................................................................36

xi](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-15-320.jpg)

![TCP em Redes de Elevado Débito

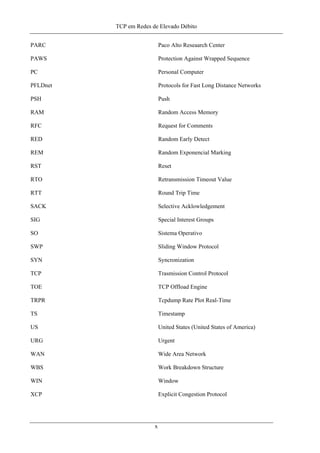

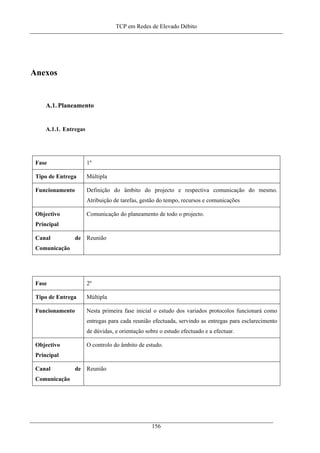

Figura 3.13 – Exemplo de troca de dados 2. .............................................................................................. 37

Figura 3.14 – O mecanismo de Piggybacking (Fonte: Washinton University).......................................... 38

Figura 3.15 – Representação do mecanismo Sliding Window................................................................... 39

Figura 3.16 – Representação das várias movimentações ao longo das trocas de segmentos TCP............. 39

Figura 3.17 – Movimentos do Sliding Window. ........................................................................................ 40

Figura 3.18 – Relação Window/Buffer....................................................................................................... 40

Figura 3.19 – Relação RTT/segmentos TCP.............................................................................................. 42

Figura 3.20 – Relação RTT/Janela. ............................................................................................................ 42

Figura 3.21 – Relação largura de banda/segmentos TCP........................................................................... 43

Figura 3.22 – Problema da janela com ligação de alto débito.................................................................... 43

Figura 3.23 – Reprentação do Silly Window Syndrome (Fonte: [3])......................................................... 44

Figura 3.24 – Cálculo do RTT medido por analisador de tráfego, comparado com o calculado TCP

(Fonte: [1]). ................................................................................................................................................ 47

Figura 3.25 – Representação da técnica exponential backoff..................................................................... 49

Figura 3.26 – Processo de activação do Persist Timer. .............................................................................. 50

Figura 3.27 – Exemplo de funcionamento do protocolo Sack.................................................................... 51

Figura 3.28 – Representação dos blocos da Sack Option........................................................................... 52

Figura 3.29 – Representação do retransmission ambiguity problem.......................................................... 54

Figura 3.30 – Representação dos campos do Timestamp Option............................................................... 55

Figura 3.31 – Análise do tráfego automóvel e populacional (Fonte: Universidade Técnica de Dresden e

Crowd Dynamics)....................................................................................................................................... 59

Figura 3.32 – Exemplo hidráulico de uma situação de congestão (Fonte: [3]). ......................................... 60

Figura 3.33 – Funcionamento da janela de receptor/janela congestão. ...................................................... 61

Figura 3.34 – Representação do estado de equilíbrio (Fonte: [13]). .......................................................... 62

Figura 3.35 – Representação do comportamento do Slow Start (Fonte: [13]). .......................................... 62

Figura 3.36 – Representação da perfomance de uma implementação 4.3BSD (Fonte: [13])..................... 63

Figura 3.37 – Representação da perfomance de uma implementação 4.3 BSD+ (Fonte [13])................... 64

Figura 3.38 – Representação gráfica da relação Slow Start/Congestion Avoidance (Fonte: [1]). ............. 66

Figura 3.39 – Probabilidade de existir perda de segmento......................................................................... 67

xii](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-16-320.jpg)

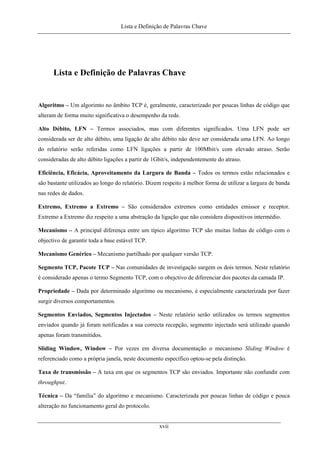

![Lista de Figuras

Figura 3.40 – Representação dos algoritmos de congestão em funcionamento (Fonte: [6]).......................69

Figura 3.41 – Representação do padrão problemático Fast Retransmit/Fast Recovery. .............................70

Figura 3.42 – Resumo de todas as operações e algoritmos de congestão, proporcionados pelas versões

TCP Tahoe, Reno e newReno. ....................................................................................................................72

Figura 3.43 – Relação throughput/velocidade transmissão [Fonte: [15]]. ..................................................76

Figura 3.44 – Gráfico característico do TCP Vegas....................................................................................77

Figura 3.45 – Comportamento do TCP Reno numa LFN de 10Gbit/s (Fonte: [9]).....................................84

Figura 3.46 – Representação do padrão gráfico do normal TCP (TCP Reno), MulTCP(N=10) e

HighSpeed TCP, numa LFN de 10Gbit/s (Fonte: [9]). ...............................................................................87

Figura 3.47 – Representação das modificações na janela de congestão efectuadas pelo TCP Scalable

(Fonte: [25]). ...............................................................................................................................................88

Figura 3.48 - Representação do padrão gráfico do normal TCP (TCP Reno), MulTCP(N=10) e Scalable

TCP (a=0.01, b=0.125) numa LFN 10Gbit/s (Fonte: [9])...........................................................................88

Figura 3.49 – Representação do algoritmo Binary Search Increase............................................................89

Figura 3.50 – Funções de crescimento BIC e CUBIC (Fonte: [27]). ..........................................................90

Figura 3.51 – Arquitectura FAST TCP (adaptado de [30] )........................................................................91

Figura 3.52 – Representação do funcionamento das janelas de congestão e atraso Compound TCP.........93

Figura 4.1 – Cenário Simulado Inicial. .......................................................................................................97

Figura 4.2 – Cenário Final...........................................................................................................................98

Figura 4.3 – CPU a utilizar 100% da capacidade de processamento ........................................................100

Figura 4.4 – Largura de banda ocupada com velocidade de 1Gbit/s, sem qualquer tipo de atraso...........101

Figura 4.5 – Simulação com atraso de 1000ms e 100Mbit/s (dummynet)................................................102

Figura 4.6 – Simulação com buffer de 16MB e buffer de 67MB (DummyNet). ......................................103

Figura 4.7 – Simulação com buffer máximo de 67MB e atraso de 1000ms (Netem) ...............................104

Figura 4.8 – Simulação com buffer de 16MB e buffer de 67MB, ambos com atraso de 50ms. ...............105

Figura 4.9 – Simulação com atraso configurado a 350ms, 300ms e 250ms..............................................105

Figura 4.10 – Simulação com a versão newReno (amostragem 10s)........................................................107

Figura 4.11 – Simulação com a versão TCP Vegas (amostragem 10s).....................................................108

Figura 4.12 – Simulação com a versão TCP Hybla (amostragem 10s).....................................................108

xiii](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-17-320.jpg)

![TCP em Redes de Elevado Débito

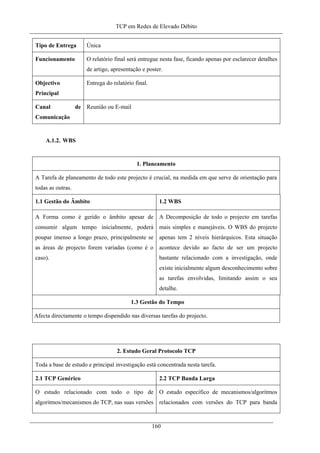

Figura 4.13 – Simulação com a versão Westwood+ (Amostragem 10s).................................................. 109

Figura 4.14 – Simulação com a versão Veno (amostragem 10s). ............................................................ 110

Figura 4.15 – Simulação com a versão Low Priority TCP (amostragem 10s). ........................................ 110

Figura 4.16 – Simulação com a versão HighSpeed TCP (amostragem 10s). ........................................... 111

Figura 4.17 – Simulação com a versão Scalable TCP (amostragem 10s). ............................................... 112

Figura 4.18 - Simulação com a versão BIC (amostragem 10s). ............................................................... 112

Figura 4.19 – Simulação com a versão CUBIC (amostragem 10s).......................................................... 113

Figura 4.20 – Simulação com a versão H-TCP (amostragem a 10s)........................................................ 114

Figura 4.21 – Simulação com a versão H-TCP (amostragem a 5s)......................................................... 114

Figura 4.22 – Simulação com todas as versões testadas........................................................................... 115

Figura 4.23 – Arquitectura NS (Fonte: [106]).......................................................................................... 116

Figura 4.24 – Cenário Lumbbell em NS2................................................................................................. 120

Figura 4.25 – Cenário Internet.................................................................................................................. 120

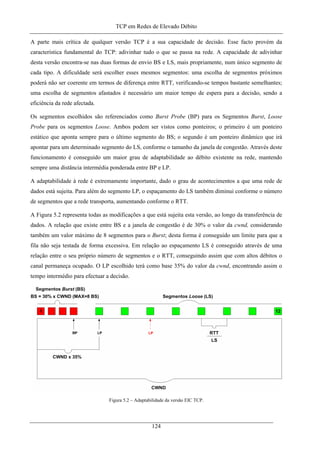

Figura 5.1 – Técnica de atenuação de Ack Compression......................................................................... 123

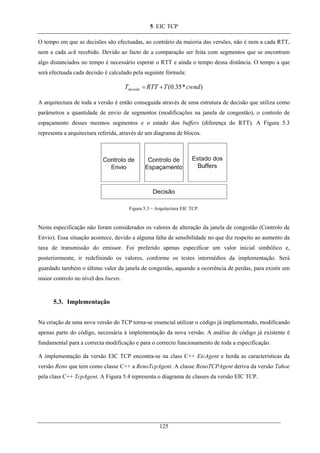

Figura 5.2 – Adaptabilidade da versão EIC TCP. .................................................................................... 124

Figura 5.3 – Arquitectura EIC TCP.......................................................................................................... 125

Figura 5.4 – Diagrama de Classes EIC TCP. ........................................................................................... 126

Figura 5.5 – Diagrama de fluxo da recepção de segmentos do EIC TCP................................................. 126

Figura 5.6 – Fluxograma de envio de segmentos do EIC TCP. ............................................................... 127

Figura 5.7 – Algoritmo da abertura de janela do EIC TCP ...................................................................... 128

Figura 5.8 – Simulação com a versão newReno Vs. EIC TCP e somatório das duas. ............................. 130

Figura 5.9 – Simulação com a versão TCP Vegas Vs. EIC TCP e somatório das duas........................... 131

Figura 5.10 - Simulação com a versão TCP Hybla Vs. EIC TCP e somatório das duas.......................... 131

Figura 5.11 – Simulação com a versão TCP Westwood+ Vs. EIC TCP e somatório das duas................ 132

Figura 5.12 – Simulação com a versão TCP Veno Vs. EIC TCP e somatório das duas. ......................... 132

Figura 5.13 – Simulação com a versão TCP Low Priority Vs. EIC TCP e somatório das duas............... 133

Figura 5.14 – Simulação com a versão HighSpeed Vs. EIC TCP e somatório das duas.......................... 134

Figura 5.15 – Simulação com a versão Scalable Vs. EIC TCP e somatório das duas.............................. 134

xiv](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-18-320.jpg)

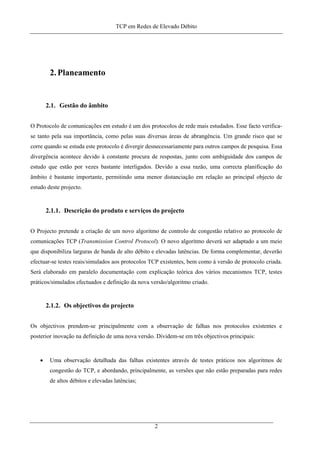

![TCP em Redes de Elevado Débito

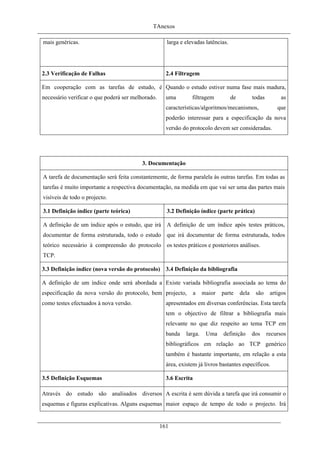

Lista de Tabelas

Tabela 3.1 – Valores da Window Scale Option.......................................................................................... 56

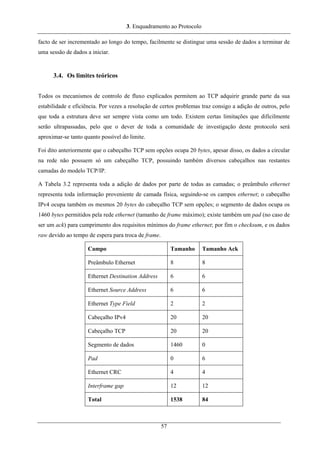

Tabela 3.2 – Tamanho do segmento que circula numa rede ethernet TCP/IP............................................ 58

Tabela 3.3 – Tabela com valores de tempo de resposta conforme tipo de ligação (Fonte: [62]). .............. 85

Tabela 3.4 – Valores de percentagem de utilização do TCP Tahoe, Reno e newReno.............................. 95

Tabela 4.1 – Especificações de Hardware e SO usado por PC................................................................... 98

Tabela 4.2 – Definição dos Agentes Emissores TCP. .............................................................................. 117

Tabela 4.3 – Definição dos Agentes Receptores TCP.............................................................................. 118

xvi](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-20-320.jpg)

![TCP em Redes de Elevado Débito

2.1.5.1. O Protocolo

O Protocolo TCP tem diversas áreas de estudo. É crucial o rigor em relação a área que o projecto se

insere, sendo que uma expansão demasiada nas restantes áreas deve ser evitada. As áreas de estudo são as

seguintes:

• Transferência de Dados;

• Confiabilidade;

• Controlo de Fluxo;

• Controlo de Congestão;

• Multiplexação;

• Conexões;

• Precedências;

• Segurança;

A principal área onde irá incidir o estudo é o controlo de fluxo e o controlo de congestão. Existe também

uma sub área que também se poderá revelar importante: a transferência dos dados. Informação mais

detalhada sobre o que abrange cada uma das áreas que não se inserem directamente no âmbito deste

projecto poderá ser importante, pois poderá transmitir uma melhor noção acerca do desvio de matéria.

Essa informação poderá ser encontrada principalmente na especificação do protocolo [38]. A Figura 2.3 é

uma representação das áreas em termos de importância para o âmbito.

Figura 2.3 – Representação da matéria que envolve o âmbito.

6](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-28-320.jpg)

![2. Planeamento

estável). Irão também ser utilizadas as aplicações necessárias para geração e monitorização de tráfego da

plataforma Linux, bem como aplicações com intuito estatístico e geradores de atraso. As aplicações que

serão utilizadas durante os testes serão: Xgraph [88], Gnuplot [89], Tcpdump [90], Iperf [91], Dummynet

[92], Netem [93], Trpr [94].

No caso da implementação irá ser utilizado software de simulação, mais propriamente o NS2 [103]

(Network Simulator, versão mais recente estável) para sistema operativo Linux. Poderão também ser

necessárias aplicações para criação de estatísticas geradas por este simulador. Essas aplicações poderão

ser o Xgraph ou o Gnuplot, já utilizados anteriormente.

2.1.7. O Hardware

O Hardware especificamente necessário neste projecto será 3 computadores pessoais com placas de rede

que suportem velocidades de 1Gbps. Adicionalmente será usado um switch de monitores. Este hardware

apenas é necessário para a fase inicial de testes. O caso ideal não é minimamente possível de realizar,

pelo que grande parte dos testes irão recorrer a simulações.

2.1.7.1. A Documentação

Num trabalho de investigação, toda a fase de documentação assume um carácter extra de importância,

i.e., todo o estudo efectuado deve ser correctamente estruturado e descrito em relatório, sob pena de toda

a parte prática de testes não ter a base teórica necessária ao leitor, que, ao contrário dos participantes do

projecto, não esteve presente em toda a investigação. Outra forma de abordar a importância da

documentação neste tipo de projectos, é o facto de um dos seus objectivos ser servir de referência a novos

projectos de investigação da mesma área.

No que diz respeito a toda a parte prática, os caminhos até chegar aos diversos cenários e testes devem ser

documentados, também com o propósito de poder servir de referência a projectos de características

semelhantes.

Os documentos devem também conter referências a diversas fontes informativas, com o intuito de

direccionar quem necessite de abordar um assunto específico mais detalhadamente. Estando o projecto

directamente ligado com a Internet, assim estarão as suas referências principais.

9](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-31-320.jpg)

![TCP em Redes de Elevado Débito

3.Enquadramento ao Protocolo

Como já foi referido anteriormente (ver Cap. 2.1), o protocolo TCP tem diversas áreas de estudo que se

dividem por toda a comunidade de investigação. A principal área de estudo abordada neste projecto teve

um desenvolvimento que originou diversos algoritmos próprios, mas continua a utilizar os mecanismos

essenciais do TCP genérico, para todo o correcto funcionamento do protocolo.

No que diz respeito aos diversos mecanismos de funcionamento, uma correcta explicação de todo o

estudo é essencial para os objectivos posteriores de testes e implementações, pois será a base de toda a

análise. O tipo de funcionamento poderá ser genérico, ou específico ao meio de transmissão de alto

débito.

Neste enquadramento, irão ser analisadas as razões que levaram às modificações do protocolo para que se

verificasse um melhor desempenho; primeiro considerando um meio genérico de transmissão; depois a

verificação de falta de eficiência em certos meios, desenvolvendo soluções; finalmente o meio de alto

débito. Irá também ser analisada toda a evolução no que diz respeito aos desenvolvimentos TCP por parte

de entidades e pessoas.

3.1. Necessidade e Motivação

Num mundo onde a capacidade das infra-estruturas de rede e a sua complexidade estão relacionadas

directamente com o débito na rede, e paralelamente, a entrega dos dados relacionada com o lucro

proporcionado pela infra-estrutura; o TCP assume um papel de importância crítica [9]. Essa importância

crítica, resulta do facto do protocolo ser o responsável pelo transporte fiável e eficiente dos dados. Assim

sendo, quanto melhor for a implementação do protocolo, melhor será a forma de entrega dos dados, e

consequentemente maior será a poupança de custos. Uma representação do tipo de interacções existentes

entre complexidade/capacidade da rede, o seu débito, e posterior entrega dos dados e lucro é representada

na Figura 3.1.

12](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-34-320.jpg)

![3. Enquadramento ao Protocolo

se assim, variadas formas de os eliminar ou minimizar. Este tipo de problemas vai ser focado em todo

este relatório.

A razão do interesse é óbvia: as larguras de banda utilizadas actualmente são de um índice completamente

diferente, comparando com as larguras de banda utilizada na criação dos normais algoritmos de congestão

(Cap. 3.5). Assim sendo, de que vale ter meios de transmissão bastante rápidos, se não existe quem os

consiga utilizar da melhor forma? Este tipo de perguntas foi o principal incentivo à investigação

desenvolvida sobre o protocolo TCP em meios de alto débito.

O limite da largura de banda existente tem vindo a subir de forma cada vez mais abrupta. As razões são

muitas: aumento da procura dos consumidores, aumento dos consumidores, mudança de conteúdos na

Internet, mais comunidades de investigação, etc. Na Figura 3.2 poderá verificar-se a azul o crescimento

verificado e esperado no que diz respeito aos limites máximos de largura de banda; a linha vermelha

corrige para o que se verificou na actualidade mais recente. Através da análise da Figura chegou-se

também a diversas conclusões:

• A largura de banda teve uma fase estática no seu crescimento, de 1980 a 1990. Essa fase deve-se

à prioridade dada a outros parâmetros, para que a criação de uma rede global de computadores

pudesse ser criada e mantida (Internet). Os principais parâmetros foram especificados no

protocolo TCP em 1981 [38];

• A largura de banda inicia o seu crescimento por volta do ano 1990, muito devido à chegada do

Cabo UTP. Os parâmetros para uma rede global estavam estabelecidos, procurava-se agora maior

adesão;

• Em 1995 surge o cabo UTP com capacidade para 100Mbit/s. As velocidades de fibra óptica

acompanhavam as do cabo, mas permitiam maiores distâncias, sendo por isso utilizadas no

backbone da Internet. A Internet é um sucesso, assim como as redes locais;

• A partir de 1995 o crescimento torna-se ainda mais exponencial, sendo alcançadas em 1998

velocidades de 1Gbit/s, tanto por parte do cabo UTP, como da fibra óptica. A velocidade de

1Gbit/s é um ponto crucial para o TCP, pois é a partir desta largura de banda que se começaram a

verificar os variados problemas;

• O crescimento continua passando pelos 10Gbit/s em 1999 [65], chegando a 100Gbit/s em 2005.

Porém estes valores só foram conseguidos através de fibra óptica. Verificam-se neste caso, cada

vez mais, uma perda de eficiência por parte do TCP;

• Esperava-se que por volta de 2010 se atingisse velocidades de 1Tbit/s, porém um recente recorde

de 14Tbit/s foi conseguido [66]. Espera-se então um grande desafio ao TCP.

15](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-37-320.jpg)

![TCP em Redes de Elevado Débito

Figura 3.2 – Crescimento da largura de banda disponibilizada (Fonte: [67]).

Por outro lado, no que diz respeito à largura de banda disponibilizada ao utilizador final, esta tem seguido

quase à regra a lei de Nielsen2

. Utilizando essa mesma regra, e considerando 4Mbit/s (velocidade média

de Internet disponibilizada actualmente ao normal utilizador), estima-se que apenas por volta do ano 2019

a barreira do 1Gbit/s será ultrapassada.

Desta forma, a preocupação com a eficiência do TCP em meios de altos débitos para os utilizadores finais

não é prioritária. A preocupação é totalmente direccionada para as ligações de todo o backbone da

Internet e ligações WAN, principalmente as ligações entre continentes, devido à sua elevada latência. Este

tipo de redes é conhecido como LFN (Long Fat Networks).

Na Figura 3.3 estão dispostas as diversas ligações entre continentes. Essas ligações são as que se sujeitam

mais aos diversos problemas do TCP, considerando as suas versões mais genéricas. Estas ligações variam

na sua maioria de 10Gbit/s a 500Gbit/s, existindo algumas ligações que poderão ultrapassar o limite de

500Gbit/s. As suas latências, geralmente, estão relacionadas com a distância, porém, o próprio meio físico

poderá também estar relacionado. A maioria de todas estas ligações é transatlântica, existindo um número

também significativo na ligação entre a América do Norte e o Japão. O protocolo de transporte utilizado

nestas redes é o TCP em, aproximadamente, 90% das ligações estabelecidas.

2

A Lei de Nielsen é bastante similar à mais popular lei de Moore, a lei defende que considerando o utilizador final, a largura de

banda disponibilizada cresce 50% a cada ano.

16](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-38-320.jpg)

![3. Enquadramento ao Protocolo

Planeamentos de grande procura de largura de banda no futuro e lucro a longo prazo, considerando a

implementação do meio físico apenas numa fase, etc.

• Mecanismos de controlo de congestão, falhas de eficiência a nível do protocolo de transporte, o

TCP.

As razões económicas e de mercado são as maiores responsáveis pela queda acentuada entre tráfego

utilizado e largura de banda disponibilizada. Apesar desse facto, o TCP não está isento de

responsabilidades. O TCP demora bastante a atingir a capacidade máxima da rede, e quando a adquire

existem problemas na sua manutenção (ver Cap. 3.6.1). As redes intercontinentais actuais são, na sua

maioria, construídas usando diversas ligações LFN com routers de alta capacidade. O TCP actual tem de

estar preparado para este tipo de cenário.

As necessidades e motivações aos melhoramentos no protocolo TCP são diversificadas, tais como os seus

variados problemas. Mesmo com todas as limitações, o TCP comportasse até bastante bem na maioria dos

ambientes de rede [9]. Porém, melhorá-lo especificamente para ligações de alto débito poderá trazer

diversas vantagens. Vantagens no campo económico, benefícios ao utilizador doméstico e,

principalmente, o aproveitamento da tecnologia que hoje dispõe são algumas delas.

3.2. O Desenvolvimento

Ao longo do tempo o TCP foi evoluindo de diversas formas, até se tornar no protocolo consistente e

eficaz que hoje é. Como qualquer protocolo, a sua fase inicial diz respeito a todos os mecanismos básicos,

existindo nas fases posteriores um esforço para a sua estabilização e a adição de diversos melhoramentos.

Foram efectuadas diversas melhorias e desenvolvidas várias implementações para aumentar o seu

desempenho, particularmente no caso da rede estar congestionada. O TCP não é desenhado para

funcionar em qualquer tipo de velocidade particular, mas tem o objectivo de usar a banda que lhe

pertence da forma mais eficiente. Essa eficiência foi sempre um ponto crucial, desde a sua especificação

às suas variadas implementações e versões. A Figura 3.7 efectua uma comparação entre a escala temporal

e a largura de banda máxima disponibilizada, representando todos os grandes acontecimentos que

sucederam a este protocolo, com especial ênfase no controlo de congestão do mesmo.

19](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-41-320.jpg)

![3. Enquadramento ao Protocolo

O desenvolvimento foi dividido em três ciclos, bastante fáceis de distinguir devido à divergência de

objectivos.

1ºCiclo – A Especificação

O ciclo inicial que representa todo o nascimento deste protocolo. As primeiras necessidades para a

criação do protocolo, todas as noções teóricas iniciais, os mecanismos básicos para funcionamento

prático, a primeira implementação num sistema operativo, o primeiro algoritmo com o objectivo de

melhorar a eficiência; todos estes são acontecimentos da fase mais imatura deste protocolo.

2º Ciclo – A Congestão

O acontecimento que marca a passagem do 1º para o 2ºciclo é a observação dos colapsos existentes nas

redes de computadores, devido à existência um deficiente controlo de congestão. Foi o 1º grande desafio a

este protocolo. A partir do desenvolvimento do primeiro algoritmo de controlo de congestão, verificou-se

a importância extrema deste tipo de controlo, para toda a eficiência do protocolo. Foram ainda efectuados

ainda outros melhoramentos como o ECN [49] ou o Sack [43].

3ºCiclo – A Congestão em alto débito

Ao contrário do que se passou na passagem do 1º para o 2ºciclo, não existe um acontecimento marcante.

O 3ºciclo começa quando a largura de banda disponibilizada assume valores, aos quais os normais

algoritmos de controlo de congestão e outros mecanismos, não se conseguem adaptar devidamente.

Verifica-se novamente uma perda de eficiência e um novo desafio ao TCP, criando a comunidade de

investigação diversas modificações ao protocolo, com vista a melhorar o seu desempenho em redes de

alto débito.

3.2.1. Entidades e Pessoas

O TCP em todo o seu desenvolvimento esteve ligado a diversas entidades e diversas pessoas. Tal como

qualquer outro protocolo de redes, a entidade principal no que diz respeito à obtenção de standards é o

IETF. Por outro lado, existe um conjunto de entidades e pessoas que são responsáveis pela “alimentação”

de ideias ao IETF, sendo sempre esta a entidade que monitoriza a coerência e efectua a aprovação das

mesmas.

As versões e alguns mecanismos do TCP, ao contrário de muitas modificações em outros protocolos,

estão muito associadas às pessoas responsáveis pelo seu desenvolvimento. Esse facto acontece devido ao

21](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-43-320.jpg)

![TCP em Redes de Elevado Débito

grande esforço individual, desenvolvido pelas mesmas na sua modificação ao protocolo. Um bom

exemplo é o nome dos diversos algoritmos utilizados pelo TCP (ver Cap. 3.3.3).

O esforço dispendido divide-se principalmente em três componentes, que estão também bastante

relacionados com os ciclos de desenvolvimento (ver Cap. 3.2):

• Melhoramentos nos mecanismos genéricos;

• Melhoramentos no controlo de congestão;

• Melhoramentos no controlo de congestão para alto débito.

3.2.1.1. Mecanismos genéricos

Os mecanismos genéricos foram especificados principalmente dentro dos próprios grupo de trabalho da

IETF, sendo ainda hoje esta entidade, a principal responsável pelos melhoramentos e adições deste tipo de

mecanismos. Os dois grupos da IETF relacionados com o TCP actualmente são: TCP Maintenance and

Minor Extensions [68] e Transport Area Working Group [69]. Estes dois grupos são bastante recentes

(2004 e 2001), pelo que na fase inicial do TCP, o grupo responsável por este tipo de mecanismos foi o

Networking Workgroup. Este grupo que na altura incluía tudo o que dizia respeito a redes de

computadores.

O Grupo TCP Maintenance and Minor Extensions é, actualmente, o grupo responsável pelo tipo de

mecanismos genéricos do TCP. É um grupo específico ao protocolo TCP que diz respeito ao

desenvolvimento do que se tratam como pequenos melhoramentos ao protocolo. Para modificações de

maior nível ao protocolo, existe o Transport Area Working Group. Por vezes a dimensão do

melhoramento pode tornar-se complicada de analisar, por essa mesma razão os dois grupos cooperam

bastante entre si, de forma a controlarem os seus âmbitos e objectivos.

A adição ou melhoramento de algum mecanismo genérico, não transforma o TCP numa nova versão, i.e.,

considera-se uma nova versão quando se verifica a existência de melhoramentos ou adições na parte do

algoritmo de congestão AIMD, Slow Start, Fast Recovery, etc. (ver Cap. 3.5). Assim sendo, considera-se

então uma nova versão, quando existe uma modificação significativa na forma de funcionamento do

protocolo, logo os mecanismos/algoritmos de congestão, elaborados pelo IETF e propostos ao IETF,

fazem na sua grande maioria, parte do Transport Area Working Group.

O desenvolvimento de mecanismos genéricos funciona, ainda, em paralelo com todos os melhoramentos

que dizem respeito à congestão, apesar de se ter verificado mais activo no 1ºciclo (especificação do

protocolo) de desenvolvimento.

22](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-44-320.jpg)

![TCP em Redes de Elevado Débito

mais genérica de qualquer implementação TCP, i.e., quando se fala em TCP, normalmente refere-se ao

TCP na sua versão Reno. Para além de ser a versão mais conhecida do TCP, é também a que serve de

base à maioria de todas as outras, principalmente as versões de alto débito (Cap. 3.6).

Para além da extrema importância dos algoritmos desenvolvidos, Van Jacobson deu o primeiro passo para

um largo conjunto de versões e algoritmos específicos para os problemas de congestão de rede. As

comunidades de investigação repararam na extrema importância do problema congestão, e o que ela

implicava na estabilidade e eficiência da Internet. Essa estabilidade e eficiência, proporcionada pelos

diversos melhoramentos feitos vieram impulsionar imenso todo o estudo sobre o TCP.

Van Jacobson contribuiu ainda para diversos mecanismos genéricos do TCP e diversos analisadores de

rede. Na altura do desenvolvimento do TCP Tahoe e Reno, Jabobson investigava no Lawrence Berkeley

Laboratory [70] da Universidade da California, tendo sido contratado com o objectivo urgente de resolver

os colapsos da Internet devido a situações congestão.

Actualmente é investigador na PARC (Paco Alto Research Center) [71]. Recebeu diversos prémios

devido à importância de todo o seu desenvolvimento, entre eles, o ACM SIGCOMM Award 2001e o Koji

Kobayashi Computers and Communications Award por parte da IEEE.

Mais informação: ver http://en.wikipedia.org/wiki/Van_Jacobson

• Lawrence Brakmo

Após o impulso dado pelo TCP Reno ao controlo de congestão, Brakmo especificou e implementou um

algoritmo com o mesmo objectivo do Reno, mas com um funcionamento totalmente diferente. À versão

implementada foi dado o nome de TCP Vegas (ver Cap. 3.5.4), devido principalmente às divergências de

características com o Reno (Vegas é a concorrente do Reno, no que diz respeito à maior cidade de

entretenimento do estado do Nevada, EUA). As versões do TCP para alto débito são sempre baseadas ou

no Reno, ou no Vegas, pelo que a importância da versão de Brakmo passa principalmente pela adição de

uma alternativa aos algoritmos do Reno.

Brakmo investigava no Laboratory of Computer Science da Universidade do Arizona na altura do

desenvolvimento da sua versão.

Mais informação: ver http://www.brakmo.org/lawrence/

24](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-46-320.jpg)

![3. Enquadramento ao Protocolo

• Janey Hoe

Janey Hoe foi a responsável por um melhoramento do protocolo TCP na sua versão Reno. O

melhoramento foi de tal forma importante que modificou o nome da versão, sendo a versão com o

melhoramento efectuado chamada de newReno. A versão newReno encerrou um ciclo de melhoramentos

relacionados com o controlo de congestão, sendo que a sua versão (a mais comum, ver Cap. 3.7),

funciona, apesar das suas limitações, bastante bem na maioria dos meios.

Por vezes nas implementações, não existe distinção entre a versão Reno e newReno, sendo apenas

apresentada a versão Reno, que na realidade é newReno. Hoe investigava no Laboratory for Computer

Science do MIT (Massachutetts Institute of Technology), quando desenvolveu a versão newReno.

Depois do newReno, não é conhecido qualquer desenvolvimento no protocolo TCP por parte de Janey

Hoe. Terminou assim, tanto uma fase de desenvolvimento TCP na área da congestão, como o seu próprio

contributo ao protocolo.

Como já foi referido acima, as versões do protocolo ganham por vezes um carácter muito pessoal. De tal

forma acontece essa situação, que na fase inicial quando apenas a ideia estava especificada, se referia às

versões do TCP como a versão do Jacobson, a versão de Brakmo, ou a versão do Hoe. Apesar desta

situação, existia obviamente um grupo de trabalho mais vasto a trabalhar nas diversas versões. A

importância da própria universidade ao direccionar muita da sua investigação para à área de congestão do

TCP, também não deve ser desvalorizada.

Uma entidade também bastante importante, principalmente no que diz respeito a troca de ideias no meio

académico foi a ACM (Association for Computing Machinery).

ACM/SIGCOMM

Fundado em 1947, teve um papel preponderante na área das telecomunicações, funcionando variadas

vezes quase em regime competitivo com o IEEE (Institute of Electrical & Electronics Engineers) [72].

Apesar da competitividade, as direcções tomadas eram bastante diferentes. O IEEE baseava-se

principalmente na parte da elaboração de standards e hardware; abordando a ACM a parte mais teórica

25](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-47-320.jpg)

![TCP em Redes de Elevado Débito

das redes de telecomunicações, e as relações específicas entre utilizadores e rede. A ACM tinha também

melhor definido o seu principal objectivo: a inovação.

Analisado o âmbito da ACM, não é complicado adivinhar que os algoritmos de congestão do TCP seriam

abordados. Em 1969 foi criado o SIGCOMM dedicada exclusivamente às redes de comunicação. Os SIGs

(Special Interest Groups) [73] são grupos de estudo específico que incluem diversos grupos de

investigação académicos, e que têm associados a distribuição de jornais e conferências sobre a matéria em

questão. O jornal saiu pela primeira vez em 1970, tendo sido organizada a primeira conferência

SIGCOMM em 1986. A conferência anual da SIGCOMM atraiu os melhores artigos e debates sobre rede

de computadores, abordando tanto a parte teórica, como diversos testes práticos.

Alguns desses artigos e debates revelaram-se completamente revolucionários e marcantes. Sendo 1986 (o

mesmo ano da primeira SIGCOMM), o ano em que se começam a verificar os primeiros colapsos na rede

devido a congestão, o TCP teve nas diversas SIGCOMMs, artigos e debates de extrema importância. A

título de exemplo o TCP na sua versão Tahoe foi apresentado na SIGCOMM88, o Reno na

SIGCOMM99, o TCP Vegas na SIGCOMM94 e o TCP newReno na SIGCOMM96 [74]. A SIGCOMM

ainda existe actualmente, mas ao contrário do que aconteceu nas conferências passadas já não é

apresentada investigação absolutamente inovadora, tendo sido o seu prestígio afectado.

Mais informações: ver http://www.acm.org e http:// www.sigcomm.org

3.2.1.3. Melhoramentos controlo de congestão para alto débito

O 2ºCiclo no desenvolvimento do controlo de congestão é marcado pela série de versões do protocolo

TCP na tentativa de o adaptar a diversos meios específicos, principalmente os meios de alto débito. A

abordagem para aumentar a eficiência do TCP foi-se multiplicando pelas comunidades de investigação,

existindo agora métodos implícitos e explícitos (ver Cap. 2.1.5.2) para controlo de congestão que se

foram desenvolvendo após a fase Reno. Existe também um conhecimento bem mais vasto sobre o TCP e

o seu controlo de congestão, o que não se verificava na altura do Reno. Devido a esse conhecimento

formou-se um núcleo bem mais completo na investigação, implementação e documentação de tudo o que

é controlo de congestão. O desafio para o TCP usando banda larga nunca foi tão grande, mas a

comunidade de investigação também nunca esteve tão bem preparada, não existindo maior prova do que a

quantidade de versões existentes.

Novas comunidades deram origem a algumas novas instituições, com pessoas que se notabilizaram pela

eficiência das suas versões e seu empenho no desenvolvimento específico para alto débito.

26](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-48-320.jpg)

![3. Enquadramento ao Protocolo

• ICIR

Em 1999 foi formado o ICIR (Internet Center for Internet Research), pertencente ao ICSI (International

Computer Science Institute) [75]. O ICSI é afiliado com a Universidade da Califórnia, que como foi

referido (ver Cap. 3.2.1.2), tem grande história na investigação sobre controlo de congestão no TCP.

Além disso, surgiu exactamente na altura dessa investigação (1988, TCP Tahoe), muito devido às

limitações dos ambientes de investigação académicos proporcionados pelos laboratórios da universidade.

O ICSI continua a ser uma instituição sem fins lucrativos, mas é bastante mais ligado ao mundo

empresarial e a todo o resto do globo. O ICIR é um grupo de trabalho do ICSI completamente

direccionado para a estabilidade das redes e Internet. Existindo no controlo de congestão uma relação

directa com toda a estabilidade das redes, este grupo foca-se essencialmente neste tipo de controlo.

Mais informações: ver http://www.icir.org/

• Sally Floyd

Sally ingressou no ICIR aquando da criação da entidade. A quantidade de projectos em que se envolveu e

está envolvida é imensa, sendo a principal impulsionadora do desenvolvimento do controlo de congestão

para alto débito e elevadas latências. A sua versão HighSpeed TCP (ver Cap. 3.6.2) é a versão específica

para alto débito mais amadurecida, considerando implementação e testes práticos reais; sendo a versão

mais próxima de se tornar standard para alto débito. Apesar da importância da sua versão, é também a

responsável por mecanismos de congestão explícitos (ver Cap. 2.1.5.2), tais como o QuickStart [54] e o

ECN [49], ou ainda mecanismos de controlo de filas como o RED (Random Early Detection) [76].

A preocupação no desenvolvimento de aplicações simuladoras de variados ambientes de rede é também

uma constante, estando envolvida em diversos projectos do tipo com vista a facilitar cada vez mais

desenvolvimentos na área.

Elaborou diversas RFCs da IETF, mesmo antes de entrar no ICIR, uma delas foi toda a especificação [52]

do algoritmo de congestão de Janey Hoe. Sally continua a investigar no ICIR, sendo a sua página pessoal

um bom ponto de partida para qualquer investigação na área de congestão do TCP para alto débito.

Mais informações: http://www.icir.org/floyd

27](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-49-320.jpg)

![TCP em Redes de Elevado Débito

• PFLDnet

A importância que a PFLDnet (Protocols for fast long distance networks) tem em relação aos

melhoramentos no controlo de congestão para alto débito é muito similar à importância da SIGCOMM

para os normais algoritmos de congestão.

A PFLDnet nasce por diversos motivos: perda de prestígio por parte da SIGCOMM, necessidade de

conferências mais especializadas, a imensa investigação sobre redes de alto débito e seus protocolos.

Devido a todas essas razões, em 2003 surge a primeira conferência, dando origem a apresentações e

debates sobre a globalidade dos assuntos deste tipo de redes. Obviamente os protocolos de transporte

específicos para alto débito foram o assunto principal. Os pontos de destaque em relação ao controlo de

congestão, considerando todas as conferências até agora realizadas, foram:

PFLDnet2003 – HighSpeed TCP (ver Cap. 3.6.2); QuickStart; DCCP (Datagram Congestion Control

Protocol, ver RFC 4340); Scalable TCP (ver Cap. 3.6.3); testes de prova da falta de eficiência; buffers e

sistemas operativos. [77]

PFLDnet2004 – Ponto de situação após primeira PFLDnet; Normalização dos testes; LCA (Loss-Based

Congestion Avoidance) VS DCA (Delay-Based Congestion Avoidance) (ver Cap. 3.5.6); HighSpeed TCP

LP; XCP (eXplicit Control Protocol, ver); Hamilton TCP (ver Cap. 3.6.5); variados testes aos novos

protocolos. [78]

PFLDnet2005 – CUBIC (Versão melhorada do Binary Increase Congestion Control, ver); testes de

atribuição de recursos (fairness); Layering TCP (LTCP); TCP Africa. [79]

PFLDnet2006 – Debates sobre o estado dos variados protocolos; Compound TCP (ver Cap. 3.6.7);

continuação dos testes. [80]

Os assuntos dividem-se entre novos algoritmos de congestão (Highspeed TCP, Scalable TCP, CUBIC,

etc.), mecanismos de congestão explícitos (QuickStart, DCCP, XCP), testes e debates sobre os resultados.

O protocolo de transporte TCP não é o único abordado nestas conferências, existindo também outros

protocolos da mesma camada e investigações em outras camadas. Estar com atenção a tudo o que se passa

nestas conferências é um passo extremamente importante na actualização de todo o desenvolvimento em

28](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-50-320.jpg)

![TCP em Redes de Elevado Débito

3.3. TCP

O principal protocolo da camada de transporte é composto talvez pela maior quantidade de mecanismos

de todos os protocolos de redes. Esse facto acontece devido a interligação do protocolo com variados

meios e tecnologias, obrigando o TCP a estar constantemente a adaptar-se. Todos os mecanismos aqui

referenciados têm uma relação directa com a eficiência nas redes de computadores. Para além desses,

existem outros mecanismos que não serão abordados, por não terem qualquer relação com o âmbito deste

projecto.

Para além dos mecanismos, variados algoritmos foram também desenvolvidos, sendo que o cabeçalho

necessita igualmente apresentação devido à sua importância. A própria apresentação do cabeçalho origina

a posterior apresentação de alguns aspectos diferenciadores deste protocolo de transporte orientado à

ligação5

e Full-Duplex6

.

3.3.1. O cabeçalho

O cabeçalho TCP é o responsável por toda a comunicação entre emissor e receptor. Foi especificado

juntamente com a especificação do protocolo [38], tendo sido alvo, ao longo do tempo, de algumas

modificações, devido principalmente ao seu carácter adaptativo com as diversas tecnologias que vão

emergindo. As modificações passaram essencialmente pela adição de novos campos. O cabeçalho TCP,

sem opções, ocupa exactamente o mesmo tamanho do cabeçalho IPv4 (Internet Protocol Version 4), i.e.,

20 bytes.

Os campos apresentados na Figura 3.9 já incluem os campos adicionados recentemente, sendo que pode

ser encontrado em diversa documentação versões do cabeçalho mais antigas. A vermelho estão os campos

relacionados com o controlo de congestão, os dados estão representados a verde.

5

Existe sempre uma negociação emissor/receptor acerca do estabelecimento de uma sessão de dados.

6

Permite o envio e recepção de ambos os extremos no contexto de apenas existir uma sessão estabelecida.

30](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-52-320.jpg)

![TCP em Redes de Elevado Débito

• Flags

Existem duas flags directamente ligadas ao controlo de congestão explícito (ver Cap. 2.1.5.2) adicionadas

mais recentemente (ano de 2001) [81].

- A flag ECE tem o objectivo de negociar o mecanismo de ECN entre dispositivos;

- A flag CWR (Congestion Window Reduced) é activada depois da negociação, sendo um pedido explícito

para reduzir a taxa de transmissão do emissor;

Todas as outras flags não estão relacionadas com mecanismos de congestão, servindo como bits de

controlo de variadas situações.

- A flag URG activa o campo Urgent Pointer fazendo com que o pacote seja marcado como urgente. O

que fazer com pacotes deste tipo depende das aplicações;

- PHS é a abreviação para Push. Quando esta flag está activa, o receptor notifica o emissor para que que

envie todos os dados que tem, sem que seja considerado o campo Window. Esta flag não é praticamente

utilizada, pelo que as implementações não costumam fornecer, sequer, forma de a activar;

- As flags RST, SYN e FIN servem para controlo das sessões de dados. RST abrevia Reset, requisitando

uma paragem brusca na sessão de dados. A SYN notifica o estabelecimento de uma sessão TCP (SYN é a

abreviatura de Syncronization). FYN abrevia Finalize, terminando a sessão de dados normalmente.

• Window

O número de bytes que o receptor está preparado para receber.

• Checksum

Para detecção de erros do cabeçalho e dos dados.

• Urgent Pointer

Se a flag URG estiver activada, então este campo representa o endereço do último segmento TCP urgente.

• Options

O campo Options é responsável por toda a parte opcional do cabeçalho TCP, permitindo assim ao

cabeçalho uma maior capacidade de adaptação às diversas situações a que está sujeito. A única opção

definida na primeira especificação do cabeçalho foi a opção MSS (Maximum Segment Size). Actualmente

existem diversas opções [82] tendo sido os meios de alto débito, um dos principais responsáveis [RFC

1323] pelo aumento das mesmas. Devido à abundância desses meios, actualmente, essas opções

tornaram-se as mais utilizadas.

As opções mais importantes estão todas relacionadas com a requisição de eficiência por partes da rede,

algumas delas são: MSS, Timestamp, Window Scale, Sack Permitted e Sack.

32](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-54-320.jpg)

![3. Enquadramento ao Protocolo

- O MSS permite a um extremo da rede notificar o outro acerca do tamanho máximo do segmento TCP

que poderá enviar. Esta função, combinada com o facto de o próprio emissor poder também limitar os

segmentos que envia através do MTU (Maximum Trasmit Unit), evita que o segmento TCP seja

fragmentado em caminhos com MTU pequeno. A opção MSS armazena o valor máximo do segmento

TCP;

- A Timestamp Option foi das primeiras opções a ser criada devido ao aparecimento das redes de alto

débito. O seu objectivo principal é uma medição mais precisa do RTT (Round Trip Time, ver Cap.

3.3.2.3). Este mecanismo será explicado em maior detalhe no 3.3.4.1.

- A Window Scale Option foi também criada principalmente devido às redes de alto débito. O objectivo é

aumentar o número de bits que o normal campo Window permite, sendo este campo um valor escalar que

multiplica o valor existente pelo campo Window inicial. O mecanismo que utiliza esta opção será também

explicado em maior detalhe no Cap. 3.3.4.2.

- Sack Permitted e Sack são duas opções que pertencem ao mecanismo Sack (Selective Acknowledgment,

ver Subsecção). Uma delas é responsável pela negociação emissora/receptor sobre a utilização do Sack

durante a ligação. Se o Sack for activado na ligação, a opção Sack será a responsável pelos blocos de

segmentos já recebidos pelo receptor.

Todas estas opções são negociadas durante o estabelecimento da sessão dados, i.e., em pacotes com a flag

SYN activa. É pois necessário que emissor e receptor permitam o uso da respectiva opção.

As seguintes figuras são parte de uma normal conexão em HTTP (hypertext transfer protocol) à Internet.

Foram capturadas pelo analisador de tráfego Ethereal [83]. Nas duas figuras são visíveis os estados de

todos os campos do cabeçalho perante diferentes situações.

A Figura 3.10 é o primeiro segmento TCP, sendo responsável pelo estabelecimento da sessão. O número

de sequência é mostrado como “relative sequence numbers”, sendo representado por “0”. Esta situação

acontece na maioria dos analisadores de tráfego, com o intuito de facilitar resoluções de problemas no

estabelecimento da ligação. O número de sequência real, neste caso, será um número completamente

aleatório, sendo os segmentos TCP seguintes até ao estabelecimento da ligação esse número mais um,

consecutivamente (no analisador as sequências são representadas por 1, 2, 3, 4, etc.).

Nas flags verifica-se que o SYN está activo, sinal que está a ser estabelecida uma ligação. Os próximos

pacotes até ao final do estabelecimento também terão a flag SYN activada.

O tamanho da Window que é notificado é o tamanho máximo do campo Window (o campo window tem

16 bits, 65535). Para mais do que 65535 bytes é necessário usar a Window Scale Option (ver ).=16

2

33](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-55-320.jpg)

![3. Enquadramento ao Protocolo

segmento volta a ser retransmitido. Para este procedimento o emissor guarda uma cópia do

segmento transmitido, pronta a ser retransmitida;

• Quando o TCP recebe os segmentos de dados do receptor ele envia uma notificação ao emissor,

essa notificação é chamada de acknowledgement, ou abreviando, ack;

• TCP mantém um checksum no seu cabeçalho. O checksum é extremo-a-estremo, com o objectivo

de detectar qualquer modificação dos dados na rede. Se um segmento chegar ao receptor com o

checksum inválido o TCP automaticamente o descarta, não transmitindo qualquer ack de

recepção.

• Os segmentos TCP são transmitidos em pacotes IP, podendo chegar fora de ordem ao receptor

por diversas razões, algumas delas de encaminhamento. Devido a essa razão, o receptor TCP

consegue voltar a sequenciar os dados se necessário, passando os dados de forma correcta para a

aplicação;

• Os dados podem também chegar em duplicado, nesse caso o receptor TCP descarta os pacotes

redundantes;

• Cada extremo de uma conexão TCP tem um tamanho de buffer finito. O receptor TCP só permite

ao outro extremo lhe enviar dados para os quais o seu buffer está preparado. [1]

Todos estes funcionamentos são conseguidos através de mecanismos interligados, sendo a base de todo o

protocolo. Para qualquer posterior desenvolvimento a nível de congestão no TCP é necessária a

aprendizagem de alguns deles, principalmente aqueles directamente ligados à eficiência.

3.3.2.1. Acks e Piggybacking

Os acks são uma presença constante em todos os protocolos orientados à ligação, esta situação não foge a

regra no protocolo TCP. Numa sessão de dados os acks servem, essencialmente, para existir notificação

de recebimento por parte de determinada entidade receptora, a partir daí a entidade emissora descarta toda

a responsabilidade no envio do segmento TCP a que foi notificada a recepção. A entidade receptora será

agora a responsável por todo o posterior tratamento ao segmento, sendo o seu normal destino os buffers

do processo aplicacional. Outro procedimento que irá acontecer no receptor é o descarte da cópia

guardada do segmento a que foi notificada a recepção, o que irá disponibilizar mais espaço no buffer

emissor.

Cada ack preenche o campo number acknowledgement com o próximo número de sequência que pretenda

receber. Se entretanto o segmento TCP que se pretenda não chegue ao receptor, o ack enviado para cada

segmento TCP recebido (que não seja o pretendido), é o ack com o pacote pretendido.

35](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-57-320.jpg)

![TCP em Redes de Elevado Débito

• A janela abre quando o limite direito avança para a direita, permitindo a mais dados serem

enviados. Esta situação acontece quando o processo aplicacional receptor liberta dados no buffer,

sendo posteriormente aumentado o valor da janela oferecida;

• A janela encolhe quando o limite direito se movimenta para o lado esquerdo. Esta situação

acontece quando o valor da janela oferecida é diminuído. Esta situação não é aconselhada

[RFC1222].

Estes três movimentos estão representados sucintamente na Figura 3.17.

Figura 3.17 – Movimentos do Sliding Window.

Com Sliding Window, para cada segmento recebido não é necessário uma notificação imediata do ack,

sendo o ack enviado posteriormente, utilizando a propriedade cumulativa. Além disso, devido ao facto do

Sliding Window manter a rede completamente saturada com segmentos, consegue um melhor throughput

do que um protocolo apenas com o simples mecanismo de acks [2].

O Tamanho da janela (buffer)

O processo aplicacional a usufruir largura de banda de rede é, geralmente, o principal responsável pelas

respectivas mudanças no tamanho da janela disponível. A Figura 3.18 exemplifica todo o funcionamento

de libertação do buffer, e posterior aviso da janela. O pacote IP é entregue pela camada de rede e é

processado pelo TCP até entrar para o processo aplicacional; quanto mais rápido for o processo a tratar os

dados, mais vazio ficará o buffer, sendo posteriormente maior o valor da janela oferecida.

Figura 3.18 – Relação Window/Buffer.

40](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-62-320.jpg)

![3. Enquadramento ao Protocolo

O tamanho da janela8

é um aspecto que afecta directamente a perfomance do TCP. O tamanho da janela

deve ser adaptado à disponibilidade da largura de banda e ao atraso da ligação em questão. Maiores

larguras de banda e maiores atrasos implicam sempre maiores janelas.

Alguns sistemas operativos limitam também a perfomance TCP por não terem o tamanho de janela

adequada às ligações de que usufruem, um desses casos é o Windows XP. O sistema operativo mais

usado nos dias de hoje utiliza para ethernet uma janela de 17520KBytes, i.e., utiliza aproximadamente

metade do valor máximo da janela, podendo piorar se o outro extremo utilizar Options como Sack ou

Timestamp. Em ligações ethernet que suportem 1Gbit/s, a largura de banda nunca consegue ser

correctamente aproveitada com uma janela deste tamanho [84], mesmo com atrasos na ordem dos 0.1ms.

A janela pode ser aumentada no sistema operativo [85] melhorando a perfomance, mas o aproveitamento

total da largura de banda nunca é conseguido. É de referir que a versão de TCP (TCP Reno) utilizada no

Windows também prejudica a perfomance, considerando ligações de alto débito (ver Cap. 3.6.1).

No Linux o tamanho da janela vem por omissão o máximo (64K), sendo a perfomance a mesma que nos

sistemas Windows, se for considerada a mesma versão de protocolo e o mesmo atraso.

O tamanho da janela TCP de forma a utilizar a largura de banda de forma eficiente pode ser calculado

utilizando a seguinte fórmula:

(sec)*sec)/(arg)( RTTbitsbandadeuraLBDPCapacidade =

Esta fórmula permite-nos obter a capacidade da rede, também chamado de BDP (Bandwidth Delay

Product). Este valor pode variar, tal como foi dito anteriormente, conforme os valores de largura de banda

e RTT. O valor da janela para aproveitar a largura de banda de forma eficiente é igual ao valor do BDP. O

valor recomendado é duas vezes o BDP.

Existem também algumas recomendações acerca do valor inicial da janela por parte da IETF [50].

A Relação com o RTT

Podemos comparar o RTT com o comprimento de um canal de dados. Se o comprimento do canal de

dados é maior, então existirá consequentemente uma maior capacidade da rede (BDP) no transporte dos

dados. Existindo mais capacidade, significa automaticamente, mais segmentos TCP a circular na rede. A

Figura 3.19 exemplifica a relação entre segmentos e RTT; o dobro do RTT, o dobro dos segmentos.

8

Janela neste caso é o equivalente a dizer “buffer”. Existe também a definição de “window” como buffer disponível, como é o

caso da Figura 3.17. A razão é esse ser o nome do campo do cabeçalho TCP.

41](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-63-320.jpg)

![TCP em Redes de Elevado Débito

janelas nos próprios sistemas operativos, ou utilizando a Window Scale Option (ver Cap. 3.3.4.2). Novos

problemas a que estão inerentes as ligações de alto débito irão sendo explicados.

Silly Window Syndrome

A condição Silly Window Syndrome10

pode acontecer em qualquer implementação que possua

mecanismos de janela. Foi verificada pela primeira vez formalmente em 1982 [39]. O que se verifica,

quando esta situação ocorre, são pequenas trocas de segmentos TCP em vez dos segmentos completos.

A causa é muitos simples, o receptor está constantemente a oferecer pequenas janelas, em vez de esperar

por maiores janelas. Do outro lado, o emissor está constantemente a enviar pequenos segmentos de dados

em vez de esperar por dados adicionais. A Figura 3.23 representa todo o processo de ocorrência do Silly

Window Syndrome. A janela (buffer) do receptor está cheia sendo que a aplicação lê apenas um byte da

janela, libertando 1 byte na respectiva janela; o byte livre é então notificado ao emissor; o emissor

transmitirá então um segmento com 1 byte, enchendo de novo a janela.

Figura 3.23 – Reprentação do Silly Window Syndrome (Fonte: [3]).

As soluções passam por modificações por parte de emissor e receptor. Em relação ao receptor a solução é

clara: o emissor não deve oferecer pequenas janelas. A janela só deve então aumentar perante duas

situações:

• A janela pode ser aumentada até ao valor de um segmento TCP (utilizando o valor MSS

negociado);

• A janela pode ser aumentada, apenas, até ao valor da sua metade.

10

Por vezes também referenciado como SWS. Devido ao facto de não ser um protocolo ou mecanismo optou-se pela definição

extensa.

44](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-66-320.jpg)

![3. Enquadramento ao Protocolo

No extremo responsável pela emissão as seguintes opções devem ser tomadas, bastando uma ser

verdadeira para se poder executar o envio:

• Enviar apenas quando um segmento TCP tem o seu valor máximo (utilizando o valor MSS

negociado);

• Enviar apenas quando o segmento é, pelo menos, metade da maior janela alguma vez oferecida

pelo receptor;

• Enviar todos os dados em buffer caso existam dados por confirmar (à espera de ack) não estando

o algorirmo de Nagle (ver Cap. 3.3.3.1) activo.

A situação de Silly Window Syndrome está directamente relacionada com o persist timer (ver Cap.

3.3.2.4) e com o algoritmo de Nagle. As ligações mais sujeitas a esta situação são claramente ligações

com emissores rápidos e receptores lentos.

3.3.2.3. Estimação do RTT

“Um bom estimador de RTT, o núcleo do temporizador de retransmissão, é a mais importante

característica para a implementação de um protocolo que pretende suportar grandes cargas”. [13]

A medição do RTT tem sido alvo de preocupação desde a inicial especificação do TCP [38], tendo

sofrido duas importantes modificações. O RTT reflecte o estado da rede, sendo, tal como o desempenho

das ligações, bastante variável ao longo do tempo da sessão de dados. A estimação correcta de toda essa

variância é o objectivo de toda a estimação do RTT.

A primeira medida que o TCP efectua é o cálculo em relação a um segmento TCP e respectivo ack,

garantindo a receptividade desse segmento. É de realçar de novo a propriedade cumulativa, que neste caso

é o principal problema de medição RTT, na medida em que não existe uma relação de um para um entre

segmento TCP e respectivo ack.

A especificação inicial calculava o RTT através de uma relação ponderada entre o RTT medido11

e o

antigo RTT. A relação é dada pela seguinte fórmula:

MRR )1( αα −+←

RTTEstimadorR =

11

Sempre que se falar de RTT medido, está-se a referir à medição entre segmento TCP e qualquer ack que notifique a sua

receptividade.

45](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-67-320.jpg)

![TCP em Redes de Elevado Débito

medidoValorM =

9.0== entoarredondamdefactorα

Sendo o factor de arredondamento aconselhado igual a 0.9, 90% do valor calculado (R) irá ter como base

o antigo valor, e 10% do valor calculado irá ter como base o novo valor medido. A passagem de RTT

para o temporizador, também conhecido como RTO (Retransmission Timeout Value) é feita com recurso

a outra fórmula:

βRRTO =

2== atrasodoriaçãovadefactorβ

O factor de variação do atraso é recomendado na especificação ser igual a 2. Este factor de variação pode

ser optimizado à ligação conforme os seus atrasos inerentes.

Van Jacobson (ver Cap. 3.2.1.2) detalhou os problemas desta fórmula [13] na estimação dos RTT,

nomeadamente o facto da variação do atraso ser um parâmetro difícil e pouco coerente de escolher,

obrigando muitas vezes a retransmissões desnecessárias. Foram então definidas novas fórmulas que

estimam o RTT com base na média e variância:

AMErr −=

médiaA =

medidoValorM =

Esta primeira fórmula é também responsável pelo cálculo da média de todos os RTT calculados. Err é a

diferença entre o valor RTT medido é a média. A média e o desvio são calculados da seguinte forma:

)|(| DErrhDD −+←

gErrAA +←

DesvioD =

4

1

== desviodoganhoh

8

1

== médiadaganhog

A média tem um valor ponderado g que é recomendado de valor 0.125. De igual forma existe um ganho h

para o desvio com recomendação de 0.25. Ao ser aumentado o ganho do desvio, significa que o RTO terá

um aumento mais acentuado. O RTO é dado por:

46](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-68-320.jpg)

![3. Enquadramento ao Protocolo

DARTO 4+=

Existem porém uma modificação para a situação inicial na troca de dados:

DARTO 2+=

Esta última fórmula faz com que o RTO não seja tão elevado na sua fase inicial. A Figura 3.24 representa

uma comparação do valor estimado com o valor real fornecido por um analisador de tráfego; o eixo dos

xx é o valor RTT/RTO, o eixo dos yy o tempo em segundos; no início o valor calculado (calculated RTO)

começa por ser alto, tornando-se a estimação ao longo do tempo de transmissão bem mais perfeita.

Figura 3.24 – Cálculo do RTT medido por analisador de tráfego, comparado com o calculado TCP (Fonte: [1]).

A segunda modificação, a adição de um campo timestamp option já teve a sua introdução anteriormente

(ver Cap. 3.3.1) e vai ser explicada em maior detalhe na (ver Cap. 3.3.4.1).

A implementação das formas de estimar o RTT varia imenso. Existem pequenas modificações nas

fórmulas, medições feitas apenas por janela, etc. Essencialmente é o tipo de ligações que define as

implementações; por exemplo, no caso de existir apenas uma medição do RTT por janela, essa situação

funciona bastante bem para baixas larguras de banda, mas levanta diversos problemas para alto débito,

onde uma estimação detalhada do RTT se revela crucial.

A estimação do RTT está directamente associada a um temporizador de retransmissão, porém esta

associação verifica-se apenas para a primeira retransmissão. Existem também algumas situações onde o

RTT não deve ser medido (ver Cap. 3.3.3.2). O funcionamento dos temporizadores após a primeira

retransmissão vai ser explicada seguidamente.

47](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-69-320.jpg)

![TCP em Redes de Elevado Débito

3.3.2.4. Os Temporizadores

“Um elemento crítico de qualquer implementação é a estratégia timeout/retransmissão”. [1]

Os temporizadores são essenciais a toda a eficiência da rede, na medida em que mal configurados podem

significar desnecessárias transmissões/retransmissões. As retransmissões são iniciadas por dois tipos de

eventos: timeouts e acks duplicados; as retransmissões devido a acks duplicados são explicadas no Cap.

3.5.1.1.

Retransmit timer

A implementação/configuração do retrasmit timer12

pode por vezes se tornar complicada. Algumas

complicações surgem perante as seguintes situações:

• Timeout um pouco maior que o RTT;

Esta situação é a mais comum. Se tudo estivesse em equilíbrio então a situação ideal seria o temporizador

igual ao RTT, porém os atrasos vão variando ao longo de toda a ligação e têm que ser definidas margens

de aceitação para certos atrasos. A solução neste caso prende-se essencialmente com uma correcta

estimação do RTT, e um bom conhecimento da rede em questão, principalmente os atrasos a que pode

estar inerente.

• Timeout demasiado pequeno;

Esta situação pode ocorrer, geralmente, quando a rede está sujeita a muitas perdas e tem poucos atrasos,

nesse caso são usados temporizadores pequenos pois o grau de desconfiança na rede é elevado.

Temporizadores pequenos em redes com algum atraso e perdas pouco relevantes significam, geralmente,

retransmissões desnecessárias.

• Timeout demasiado longo;

Situação ocorrente quando existe um grau de confiança elevado na rede (em relação às perdas), ou o

atraso da rede é elevada. Numa rede que não reúna essas características irá ser verificado uma reacção

bastante lenta aquando da perca de um qualquer segmento TCP.

Quando ocorre um timeout são executadas duas operações: retransmissão do segmento TCP que causou o

timeout e o reiniciar do temporizador. O temporizador altera também o seu tempo conforme o número de

12

Termo mais usado, que corresponde a temporizador de retransmissão.

48](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-70-320.jpg)

![3. Enquadramento ao Protocolo

Delayed Ack Timer

Na parte do receptor existe o delayed ack timer. Este temporizador define o tempo que o receptor deve

esperar, entre o correcto receber do segmento e o envio do respectivo ack. A espera é útil para

optimização da largura de banda, notificando vários segmentos num só ack (propriedade cumulativa),

sendo também útil para o mecanismo de piggybacking (ver Cap. 3.3.2.1). Os valores de timeout deste

temporizador variam bastante de implementação para implementação, sendo o valor mais usado 200ms.

3.3.2.5. Sack

O Sack é um protocolo especificado formalmente em 1996 [43] com o objectivo de melhorar todo o

mecanismo de acknowledgment. Os mecanismos de acknowledgment (ver Cap 3.3.2.1) devido à

propriedade cumulativa têm algumas vantagens e desvantagens, o Sack fixou-se em todas a desvantagens

desta propriedade. As desvantagens são:

• A recepção de segmentos fora de sequência nunca tem associado um ack;

• O receptor manda acks duplicados;

• O emissor apenas pode receber uma notificação de segmento recebido (ack) por RTT.

Este protocolo usa as opções do TCP Sack Permitted e Sack (ver Cap. 3.3.2.5). A opção Sack armazena os

blocos de dados que já foram recebidos, permitindo ao protocolo TCP, além da notificação do normal

ack, a notificação de diversos blocos de dados já recebidos. A Figura 3.27 exemplifica o funcionamento

do Sack; São enviados 5 blocos de dados (100, 200, 300, 400 e 500), 2 deles (200 e 400) são perdidos;

após o esgotar do delay ack timer é enviado o normal ack 200, mas com a notificação de que os blocos

500-600 e 300-400 já foram recebidos, ajudando assim o emissor a melhor decidir o que transmitir.

Figura 3.27 – Exemplo de funcionamento do protocolo Sack.

51](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-73-320.jpg)

![TCP em Redes de Elevado Débito

A Sack Option é de comprimento variável, com limite para quatro blocos, sendo composta da forma

representado na Figura 3.28. O limite direito representa o primeiro número de sequência desse bloco, o

limite esquerdo é o número a seguir ao último número de sequência do bloco.

Figura 3.28 – Representação dos blocos da Sack Option.

Existe uma extensão feita a este protocolo a que foi dado o nome de D-Sack [47] . Esta opção pretende

utilizar o primeiro bloco Sack para notificação de segmentos duplicados. O objectivo principal é notificar

ao emissor que foram efectuadas retransmissões desnecessárias. Desta forma, o emissor poderá reagir,

anulando por exemplo os algoritmos de controlo de congestão. Esta extensão ainda possui poucas

implementações e quando existe implementação não se verifica por omissão.

3.3.3. Os algoritmos

Existem vários tipos de algoritmos no TCP. Um algoritmo no TCP caracteriza-se por poucas linhas de

código, aquando das implementações. Geralmente alteram também de forma muito significativa o

desempenho da rede. Os algoritmos surgem, também geralmente, associados ao seu criador dividindo-se

em três tipos:

• Algoritmos de controlo de congestão;

Algoritmos que previnem o emissor de não congestionar toda a rede.

• Algoritmos de controlo de erros;

Algoritmos de recuperação para situações de perdas de segmentos.

• Algoritmos de controlo de fluxo.

Algoritmos que previnem o emissor de não sobrecarregar o receptor com informação, tentando que o

mesmo envie os dados de forma adequada à largura de banda.

O objectivo de cada tipo de algoritmo é diferente, mas toda a implementação é feita de forma combinada,

fazendo com que uma correcta separação entre eles não se verifique simples de efectuar.

52](https://image.slidesharecdn.com/project-190623000053/85/New-TCP-version-for-large-bandwidth-networks-74-320.jpg)

![3. Enquadramento ao Protocolo

Os algoritmos de congestão e de controlo de erros vão ser analisados mais à frente (ver Cap. 3.6), sendo

agora analisados dois algoritmos, correspondentes ao controlo de fluxo.

3.3.3.1. Algoritmo de Nagle

O primeiro algoritmo, definido para optimizar a ocupação da rede por parte do TCP, foi especificado em

1984 [40]. O nome atribuído foi o nome do seu criador (John Nagle), tendo sido um algoritmo criado na

fase inicial dos colapsos da Internet (ver Cap. 3.2) e por isso considerado, por vezes, o primeiro algoritmo

de congestão. Porém, geralmente são referidos como algoritmos congestão outro tipo de algoritmos,

criados um pouco mais tarde (ver Cap. 3.6).

O algoritmo especifica que quando uma ligação TCP tem segmentos que ainda não foram confirmados da

recepção, pequenos segmentos não podem ser enviados, até que os acks sejam recebidos. Em vez dessa

situação, pequenas quantidades de dados da aplicação vão sendo somadas, sendo posteriormente enviadas

apenas num segmento TCP quando todos os ack chegarem. O algoritmo é extremamente simples e de

uma tremenda utilidade, pois em situações de congestão, se existirem aplicações interactivas16

na rede o

desempenho da rede aumenta exponencialmente. Além disso, não precisa de qualquer tipo de

sincronização adicional, pois à medida que a rede vai ficando descongestionada (acks a chegar) mais

rápida será a transmissão dos dados.

3.3.3.2. Algoritmo de Karn

Especificado em 1987 [10], este algoritmo está directamente ligado à estimação de RTT (ver Cap.

3.3.2.3). Phil Karn reparou num problema de ambiguidade durante as retransmissões a que foi dado o

nome de retransmission ambiguity problem.

Um segmento é transmitido e para esse segmento o retransmission timer esgota, enviando um novo

segmento; de seguida é recebido um ack do segmento retransmitido. A pergunta que agora se faz é se este

ack é do segmento transmitido atrasado ou do segmento restransmitido? A resposta seria fácil se existisse

forma de saber que o primeiro segmento tinha sido perdido, porém não existe nenhum mecanismo que

permita essa verificação. De qualquer forma, se ele for correctamente recebido não há forma alguma de