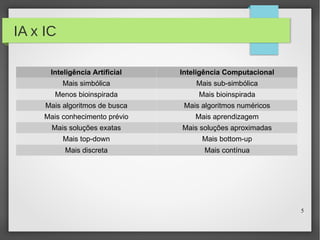

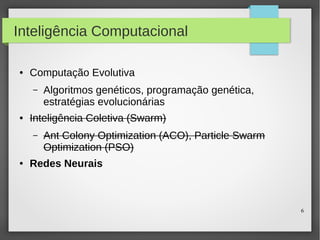

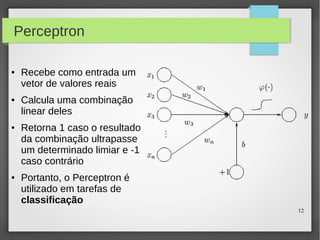

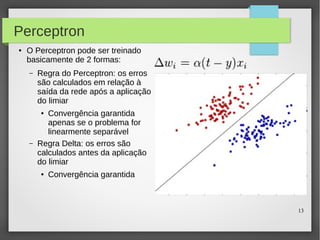

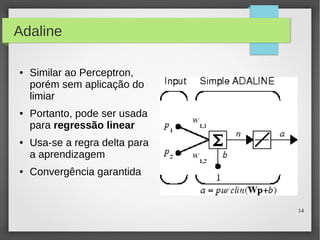

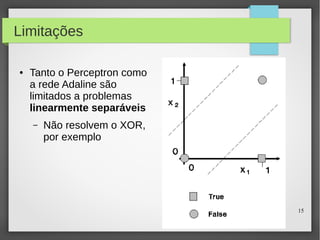

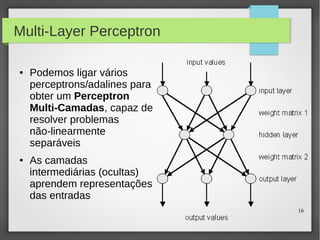

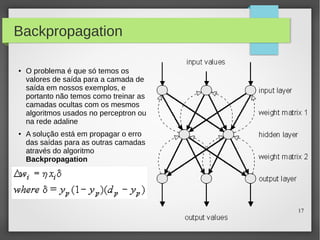

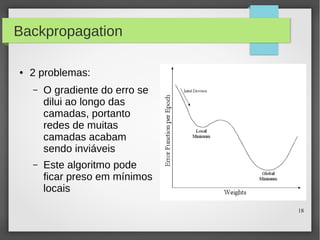

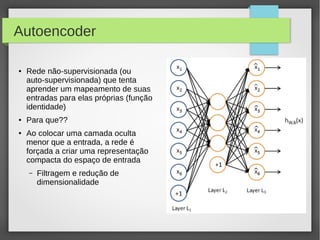

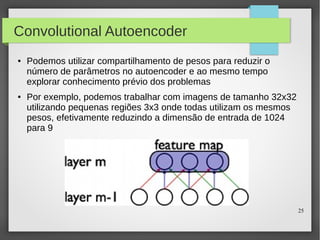

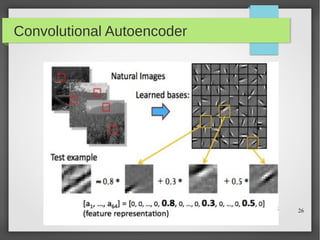

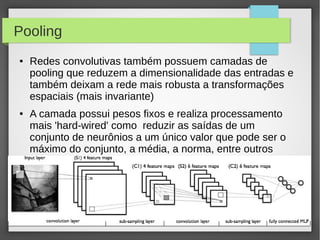

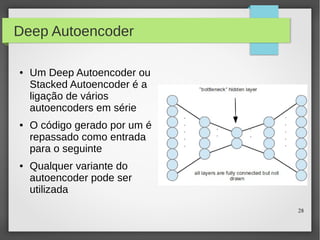

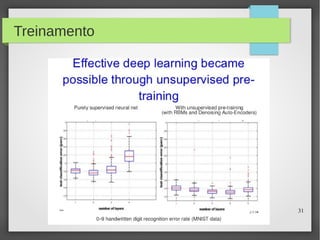

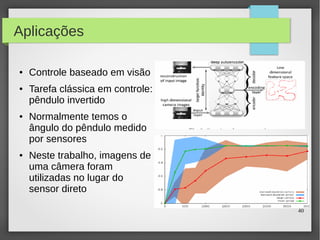

Este documento apresenta o roteiro para o exame de qualificação de doutorado de Rafael Coimbra Pinto sobre redes neurais. O documento discute a diferença entre inteligência artificial e inteligência computacional, apresenta vários tipos de redes neurais como perceptrons, autoencoders profundos e convolucionais, e discute aplicações como reconhecimento de imagens, fala e gestos.