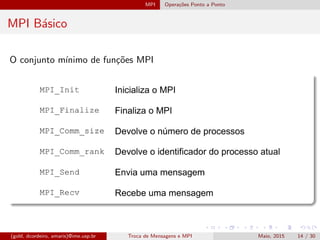

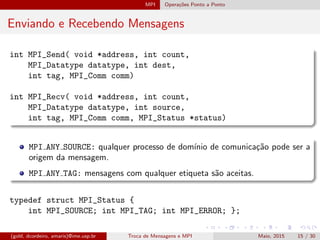

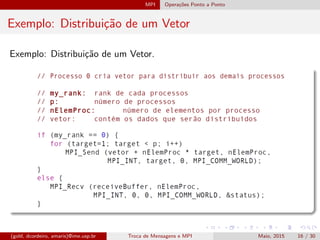

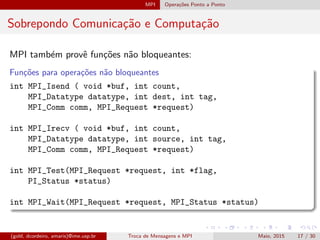

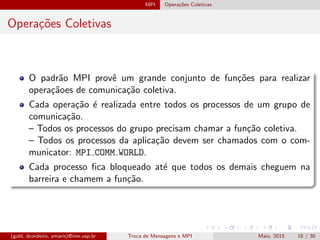

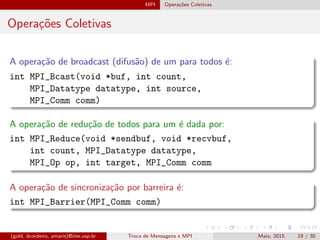

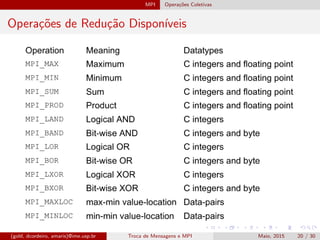

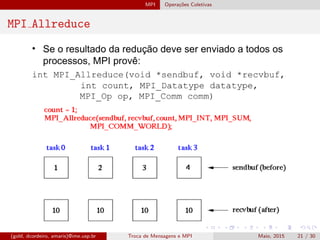

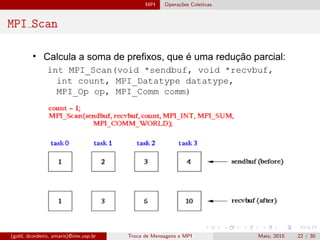

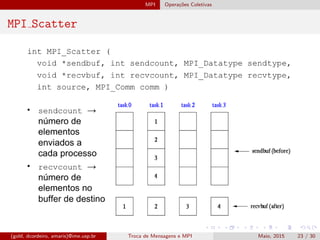

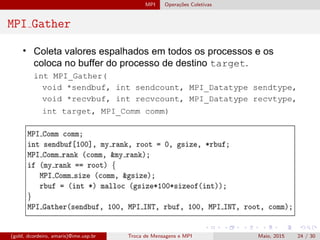

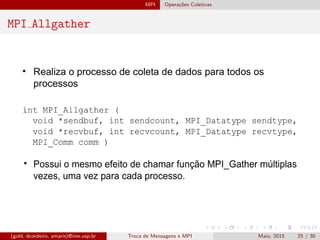

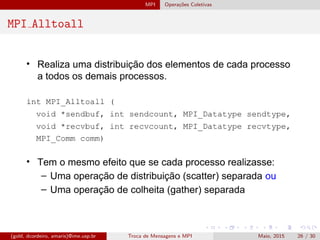

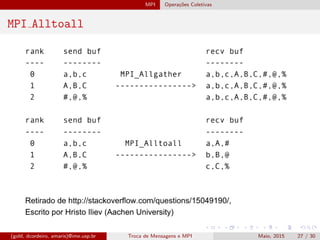

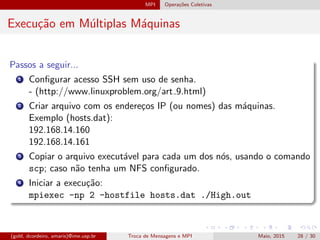

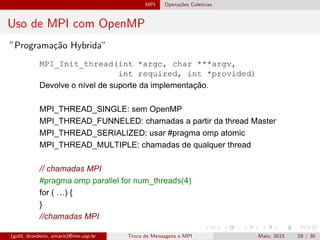

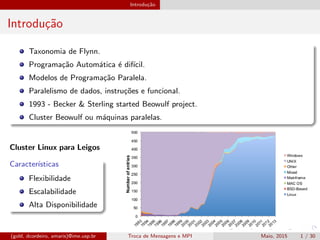

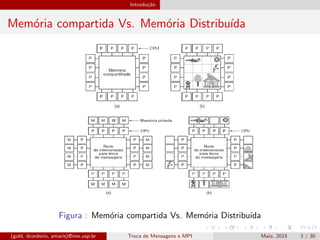

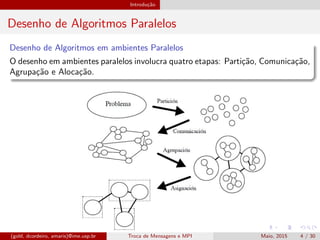

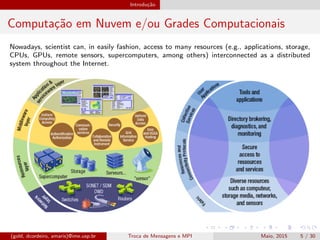

O documento discute o paradigma de troca de mensagens e a biblioteca MPI. Aborda conceitos como memória compartilhada vs distribuída, modelos de programação paralela, e bibliotecas para troca de mensagens como MPI e PVM. Detalha operações ponto a ponto e coletivas em MPI, incluindo broadcast, reduce, scatter e gather.

![MPI Introdu¸c˜ao `a MPI

Hello World

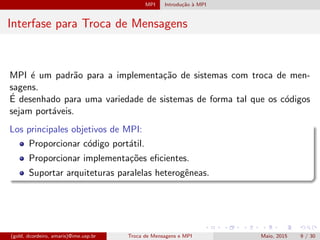

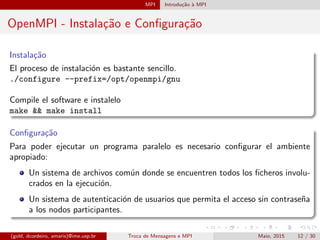

Para compilar: mpicc -o <execut´avel> <fonte>

Para executar: mpiexec -n <nproc> <execut´avel>

Exemplo de Compila¸c˜ao e Execu¸c˜ao

mpicc -o hello hello.c

mpiexec -n 4 hello

#include <mpi.h>

main(int argc , char *argv [])

{

int npes , myrank;

MPI_Init (&argc , &argv );

MPI_Comm_size (MPI_COMM_WORLD , &npes );

MPI_Comm_rank (MPI_COMM_WORLD , &myrank );

printf("Hello World (%d of %d)!n", myrank , npes );

MPI_Finalize ();

}

(gold, dcordeiro, amaris)@ime.usp.br Troca de Mensagens e MPI Maio, 2015 13 / 30](https://image.slidesharecdn.com/slides-170216234339/85/MPI-and-Distributed-Applications-18-320.jpg)