Skip Connection まとめ(Neural Network)

•

7 gostaram•17,113 visualizações

ResNetに代表されるSkip Connectionについて理論と有効性をまとめました。

Denunciar

Compartilhar

Denunciar

Compartilhar

Baixar para ler offline

Recomendados

Recomendados

Mais conteúdo relacionado

Mais procurados

Mais procurados (20)

【DL輪読会】Perceiver io a general architecture for structured inputs & outputs

【DL輪読会】Perceiver io a general architecture for structured inputs & outputs

【DL輪読会】言語以外でのTransformerのまとめ (ViT, Perceiver, Frozen Pretrained Transformer etc)

【DL輪読会】言語以外でのTransformerのまとめ (ViT, Perceiver, Frozen Pretrained Transformer etc)

【DL輪読会】Efficiently Modeling Long Sequences with Structured State Spaces

【DL輪読会】Efficiently Modeling Long Sequences with Structured State Spaces

[DL輪読会]AutoAugment: LearningAugmentation Strategies from Data & Learning Data...![[DL輪読会]AutoAugment: LearningAugmentation Strategies from Data & Learning Data...](data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7)

![[DL輪読会]AutoAugment: LearningAugmentation Strategies from Data & Learning Data...](data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7)

[DL輪読会]AutoAugment: LearningAugmentation Strategies from Data & Learning Data...

【DL輪読会】StyleCLIP: Text-Driven Manipulation of StyleGAN Imagery

【DL輪読会】StyleCLIP: Text-Driven Manipulation of StyleGAN Imagery

【DL輪読会】Data-Efficient Reinforcement Learning with Self-Predictive Representat...

【DL輪読会】Data-Efficient Reinforcement Learning with Self-Predictive Representat...

SSII2021 [OS2-01] 転移学習の基礎:異なるタスクの知識を利用するための機械学習の方法![SSII2021 [OS2-01] 転移学習の基礎:異なるタスクの知識を利用するための機械学習の方法](data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7)

![SSII2021 [OS2-01] 転移学習の基礎:異なるタスクの知識を利用するための機械学習の方法](data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7)

SSII2021 [OS2-01] 転移学習の基礎:異なるタスクの知識を利用するための機械学習の方法

[DL輪読会]GLIDE: Guided Language to Image Diffusion for Generation and Editing![[DL輪読会]GLIDE: Guided Language to Image Diffusion for Generation and Editing](data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7)

![[DL輪読会]GLIDE: Guided Language to Image Diffusion for Generation and Editing](data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7)

[DL輪読会]GLIDE: Guided Language to Image Diffusion for Generation and Editing

【DL輪読会】An Image is Worth One Word: Personalizing Text-to-Image Generation usi...

【DL輪読会】An Image is Worth One Word: Personalizing Text-to-Image Generation usi...

SSII2022 [TS1] Transformerの最前線〜 畳込みニューラルネットワークの先へ 〜![SSII2022 [TS1] Transformerの最前線〜 畳込みニューラルネットワークの先へ 〜](data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7)

![SSII2022 [TS1] Transformerの最前線〜 畳込みニューラルネットワークの先へ 〜](data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7)

SSII2022 [TS1] Transformerの最前線〜 畳込みニューラルネットワークの先へ 〜

Semelhante a Skip Connection まとめ(Neural Network)

Semelhante a Skip Connection まとめ(Neural Network) (9)

Convolutional Neural Networks のトレンド @WBAFLカジュアルトーク#2

Convolutional Neural Networks のトレンド @WBAFLカジュアルトーク#2

[cvpaper.challenge] 超解像メタサーベイ #meta-study-group勉強会![[cvpaper.challenge] 超解像メタサーベイ #meta-study-group勉強会](data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7)

![[cvpaper.challenge] 超解像メタサーベイ #meta-study-group勉強会](data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7)

[cvpaper.challenge] 超解像メタサーベイ #meta-study-group勉強会

【CVPR 2019】Do Better ImageNet Models Transfer Better?

【CVPR 2019】Do Better ImageNet Models Transfer Better?

Mais de Yamato OKAMOTO

Mais de Yamato OKAMOTO (20)

第七回全日本コンピュータビジョン勉強会 A Multiplexed Network for End-to-End, Multilingual OCR

第七回全日本コンピュータビジョン勉強会 A Multiplexed Network for End-to-End, Multilingual OCR

ICLR2020 オンライン読み会 Deep Semi-Supervised Anomaly Detection

ICLR2020 オンライン読み会 Deep Semi-Supervised Anomaly Detection

Domain Generalization via Model-Agnostic Learning of Semantic Features

Domain Generalization via Model-Agnostic Learning of Semantic Features

[ICML2019読み会in京都] (LT)Bayesian Nonparametric Federated Learning of Neural Net...![[ICML2019読み会in京都] (LT)Bayesian Nonparametric Federated Learning of Neural Net...](data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7)

![[ICML2019読み会in京都] (LT)Bayesian Nonparametric Federated Learning of Neural Net...](data:image/gif;base64,R0lGODlhAQABAIAAAAAAAP///yH5BAEAAAAALAAAAAABAAEAAAIBRAA7)

[ICML2019読み会in京都] (LT)Bayesian Nonparametric Federated Learning of Neural Net...

ICLR2019 読み会in京都 ICLRから読み取るFeature Disentangleの研究動向

ICLR2019 読み会in京都 ICLRから読み取るFeature Disentangleの研究動向

CVPR2019 survey Domain Adaptation on Semantic Segmentation

CVPR2019 survey Domain Adaptation on Semantic Segmentation

Skip Connection まとめ(Neural Network)

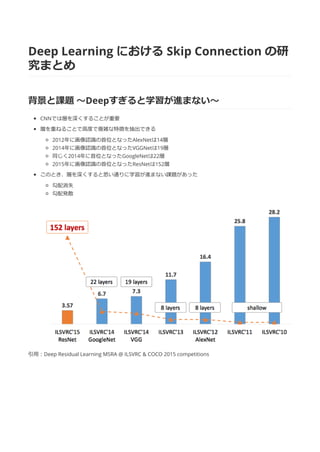

- 1. Deep Learning における Skip Connection の研 究まとめ 背景と課題 〜Deepすぎると学習が進まない〜 CNNでは層を深くすることが重要 層を重ねることで⾼度で複雑な特徴を抽出できる 2012年に画像認識の⾸位となったAlexNetは14層 2014年に画像認識の⾸位となったVGGNetは19層 同じく2014年に⾸位となったGoogleNetは22層 2015年に画像認識の⾸位となったResNetは152層 このとき、層を深くすると思い通りに学習が進まない課題があった 勾配消失 勾配発散 引⽤:Deep Residual Learning MSRA @ ILSVRC & COCO 2015 competitions

- 2. ResNetのアイデア 元論⽂: [1512.03385] Deep Residual Learning for Image Recognition ⼊⼒値と出⼒値の差分(残差)を学習する Deepになると⼊⼒xと出⼒x*Wは極めて近い値 ならばxをそのまま残して差分を計算した⽅が効率的 残差ブロックの提案 畳み込み層+Skip Connection(恒等写像)を組み合わせた Skip Connectionによって誤差逆伝搬をしやすい 変換不要ならば畳み込み層のWeightを0にすればよい 既にいい感じになっているxに余計なことをしなくてすむ Skip Connectionが無い場合、⾮線形写像なのでxが理想値から遠ざかることがある 残差ブロックのアーキテクチャ Plainアーキテクチャ 3x3のconv層が2つ Bottleneckアーキテクチャ 1x1のconv層でdimを⼩さくして、、、 3x3のconv層にかけて、、、 1x1のconv層で元々のdimに戻す

- 3. 『DenseNet』CVPR2017 BEST PAPER 元論⽂: [1608.06993] Densely Connected Convolutional Networks アイデア:層の間で情報伝達を最⼤化する 上の図は1つのDenseBlockを表す ℓ番⽬の層への⼊⼒は、0〜ℓ-1番⽬の層の全出⼒となる

- 5. Skip Connectionとよく似たContracting Path構造(U-Net) [q505.04597] U-Net: Convolutional Networks for Biomedical Image Segmentation Image-ClassificationではなくImage-Segmentationのタスクで⽣まれた⼿法 Semantic Segmentationにおいて位置は保存したい重要情報 CNNではPoolingや畳み込みをするほど位置情報が曖昧になることが課題 局所的特徴と全体的位置情報の両⽅を把握したい 形がU字なのでU-Net 左側がEncoder 右側がDecoder Up-Sampling後にEncoder部の同次元数の特徴を連結する あまり畳み込みされていないEncoder部では位置情報が保たれているという仮定 concatenation with the correspondingly cropped feature map 従来どおり特徴を抽出しつつ、位置情報を保存する

- 6. Skip Connectionの有効性を解明 [1712.09913] Visualizing the Loss Landscape of Neural Nets LOSS関数を可視化することで近年のNeural Networkのアーキテクチャの有効性を検証した論⽂ Skip Connectionを利⽤した場合(右図)は、non-convexからconvexに近づいているように⾒える Skip Connectionを含む新しいネットワーク構造 〜Deep Layer Aggregation (CVPR2018)〜 [1707.06484] Deep Layer Aggregation 疲れたのでまた今度・・・ 資料作成:ロードローラー ブログ: r2d.info、 Twitter: RoadRoller_DESU