1) A programação concorrente é necessária para utilizar o processador completamente e modelar o paralelismo do mundo real.

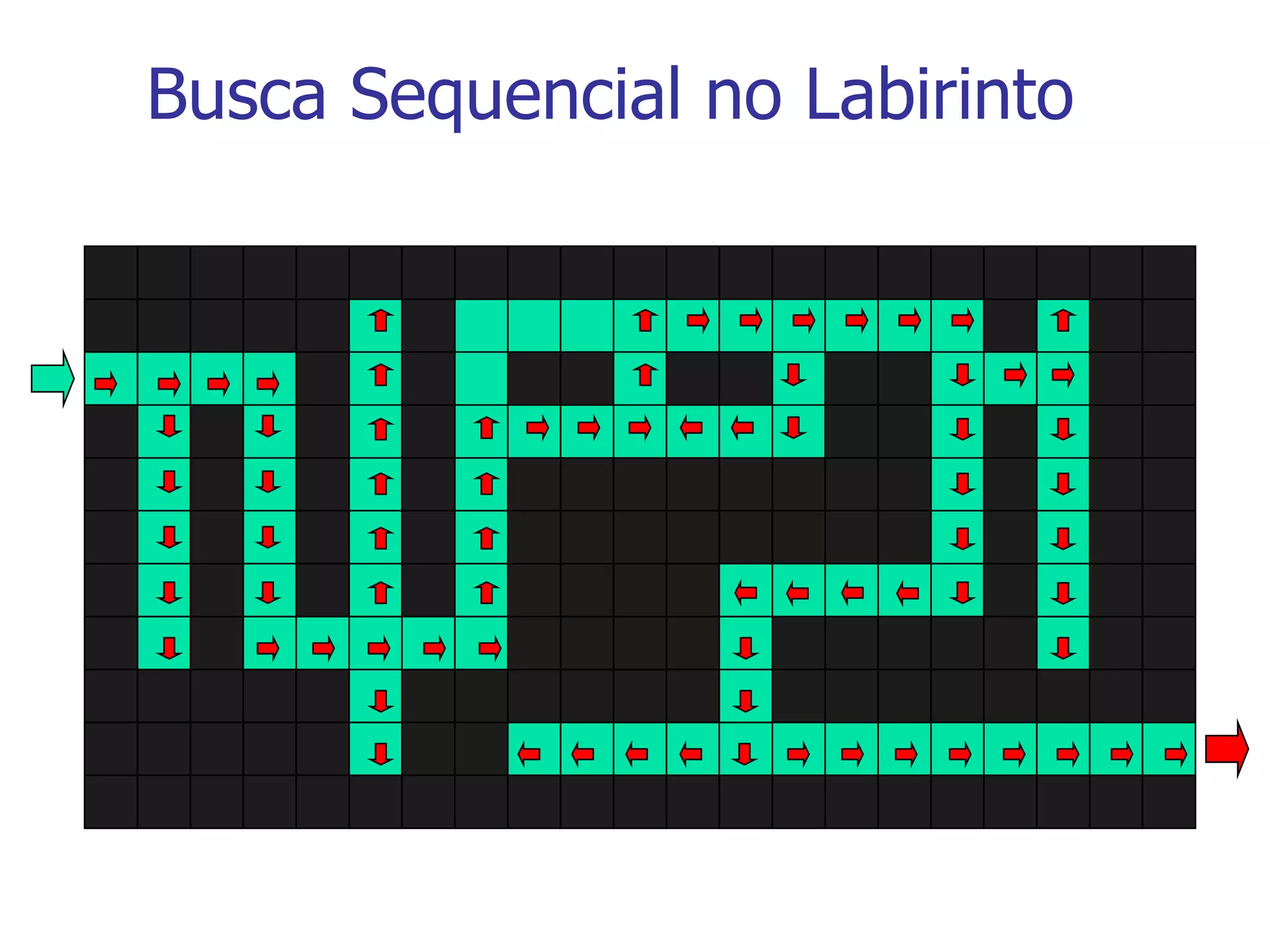

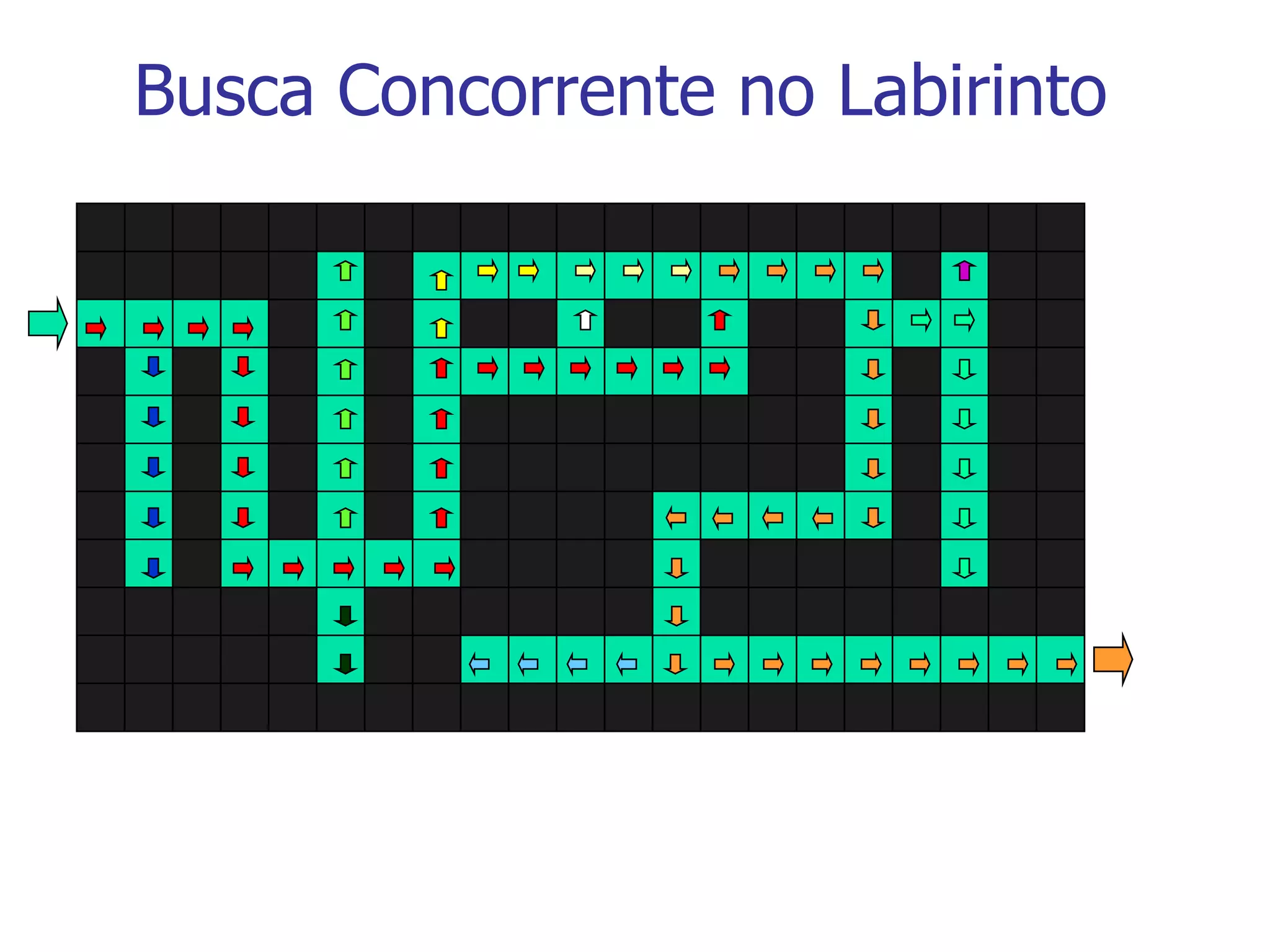

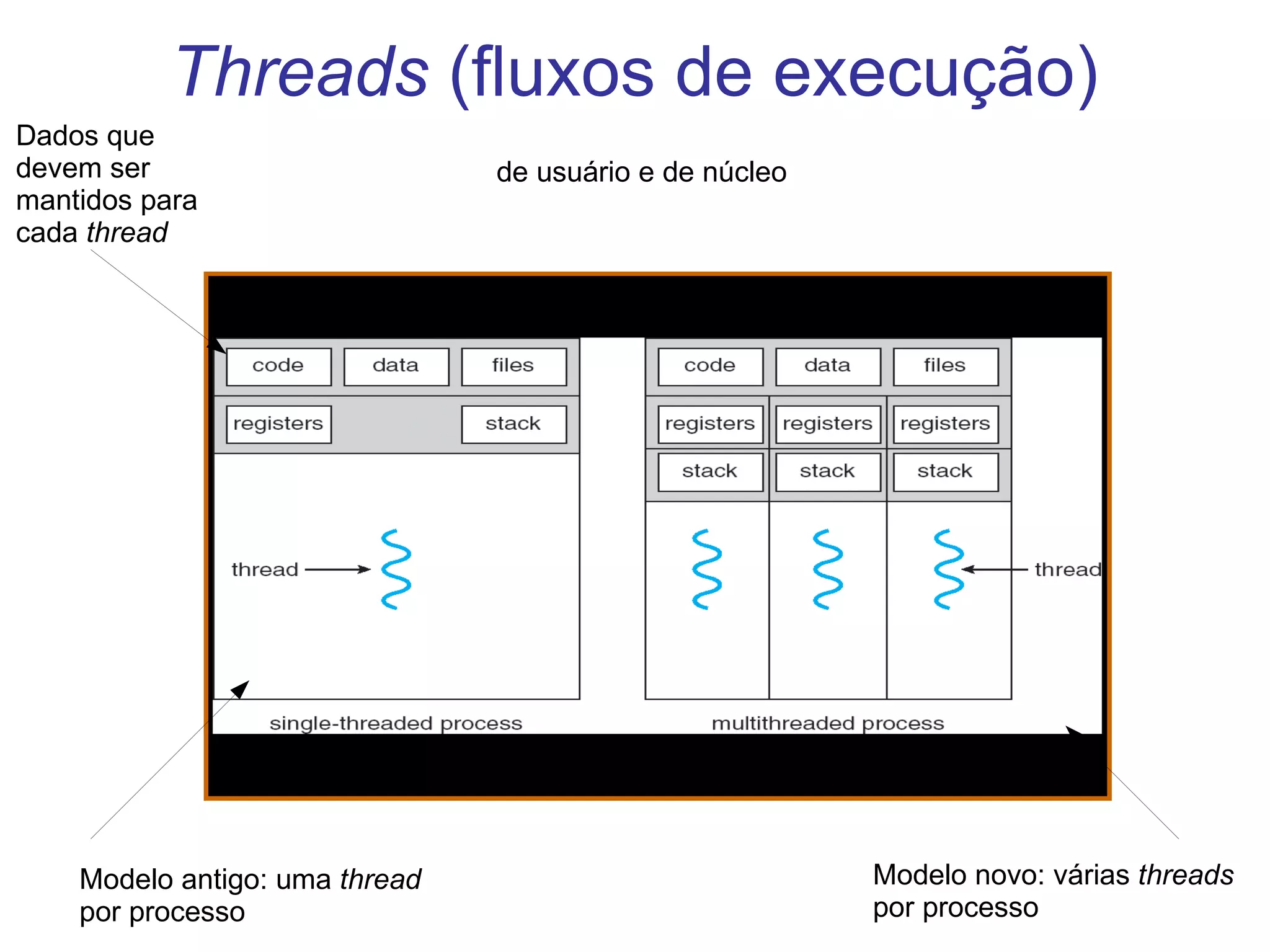

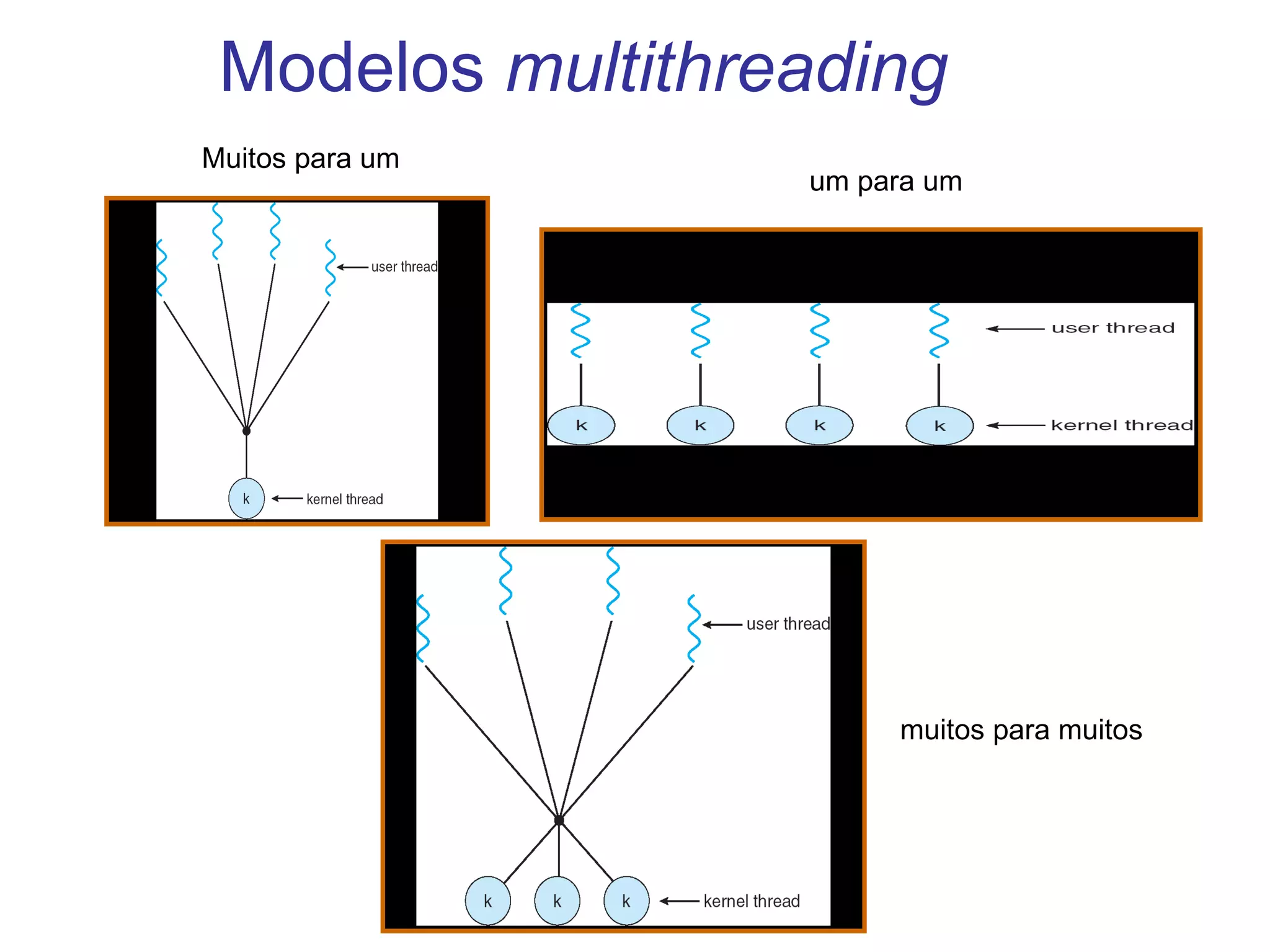

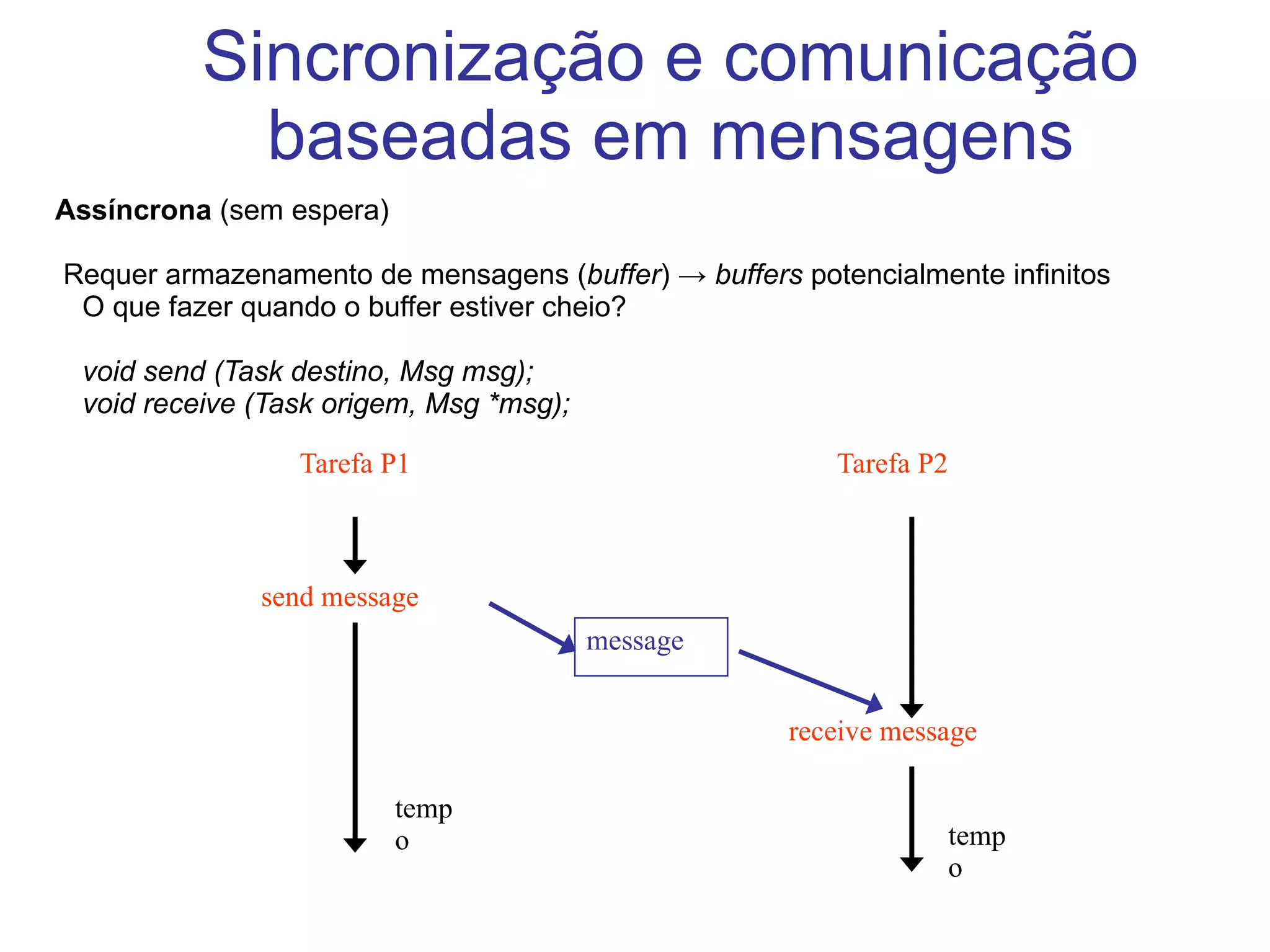

2) Existem diferentes formas de implementar tarefas concorrentes, como multiprogramação, multiprocessamento e processamento distribuído.

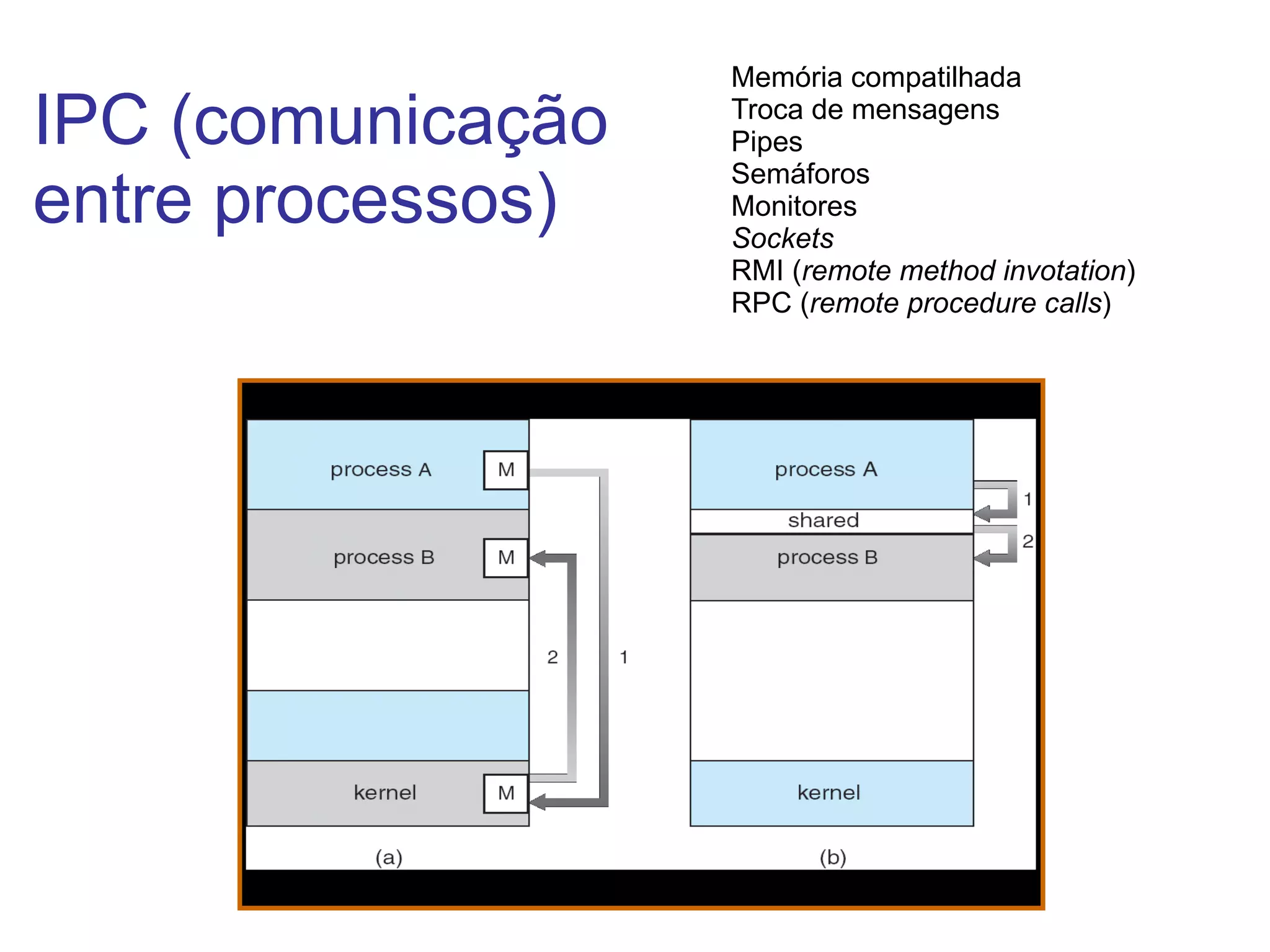

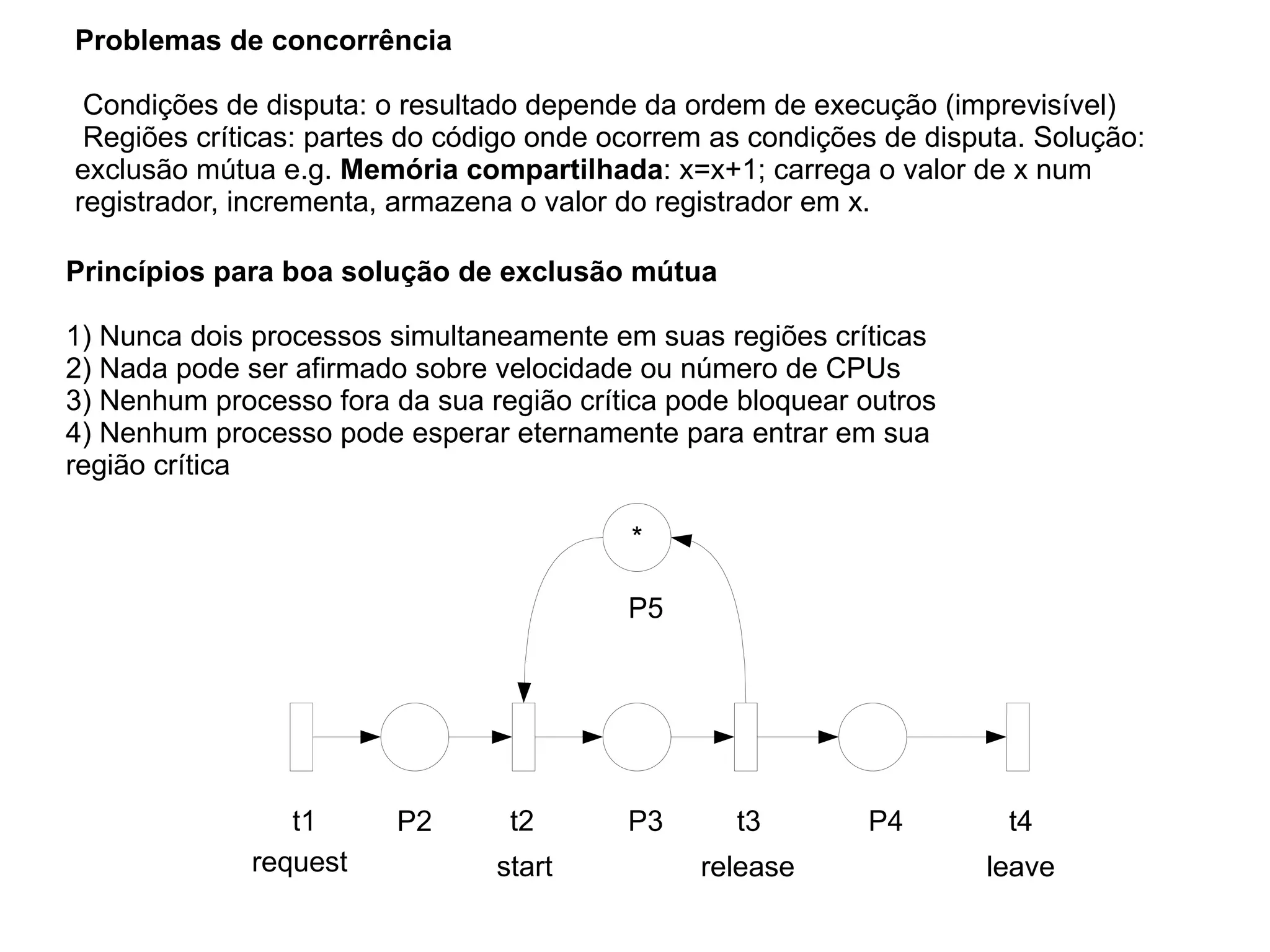

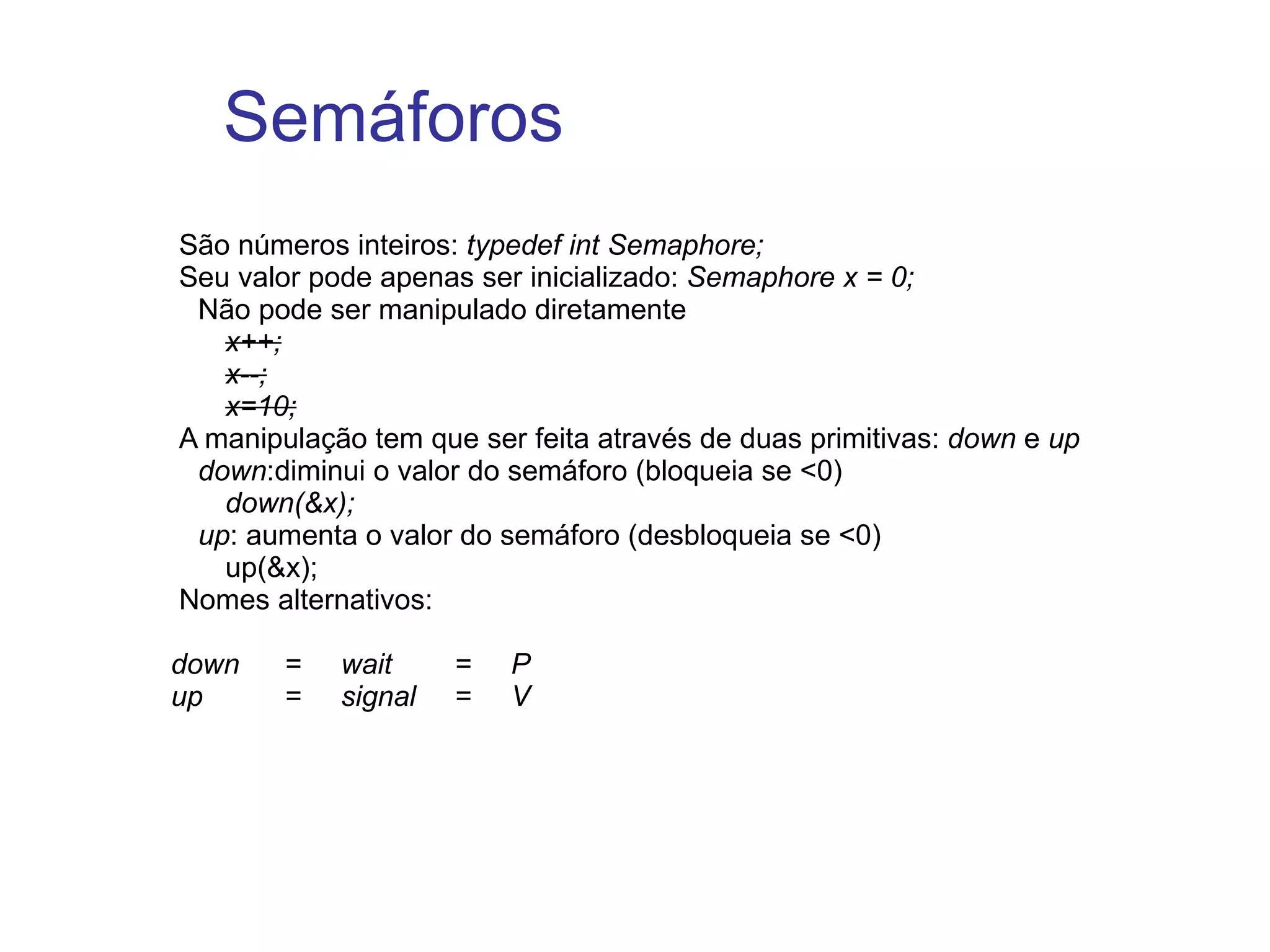

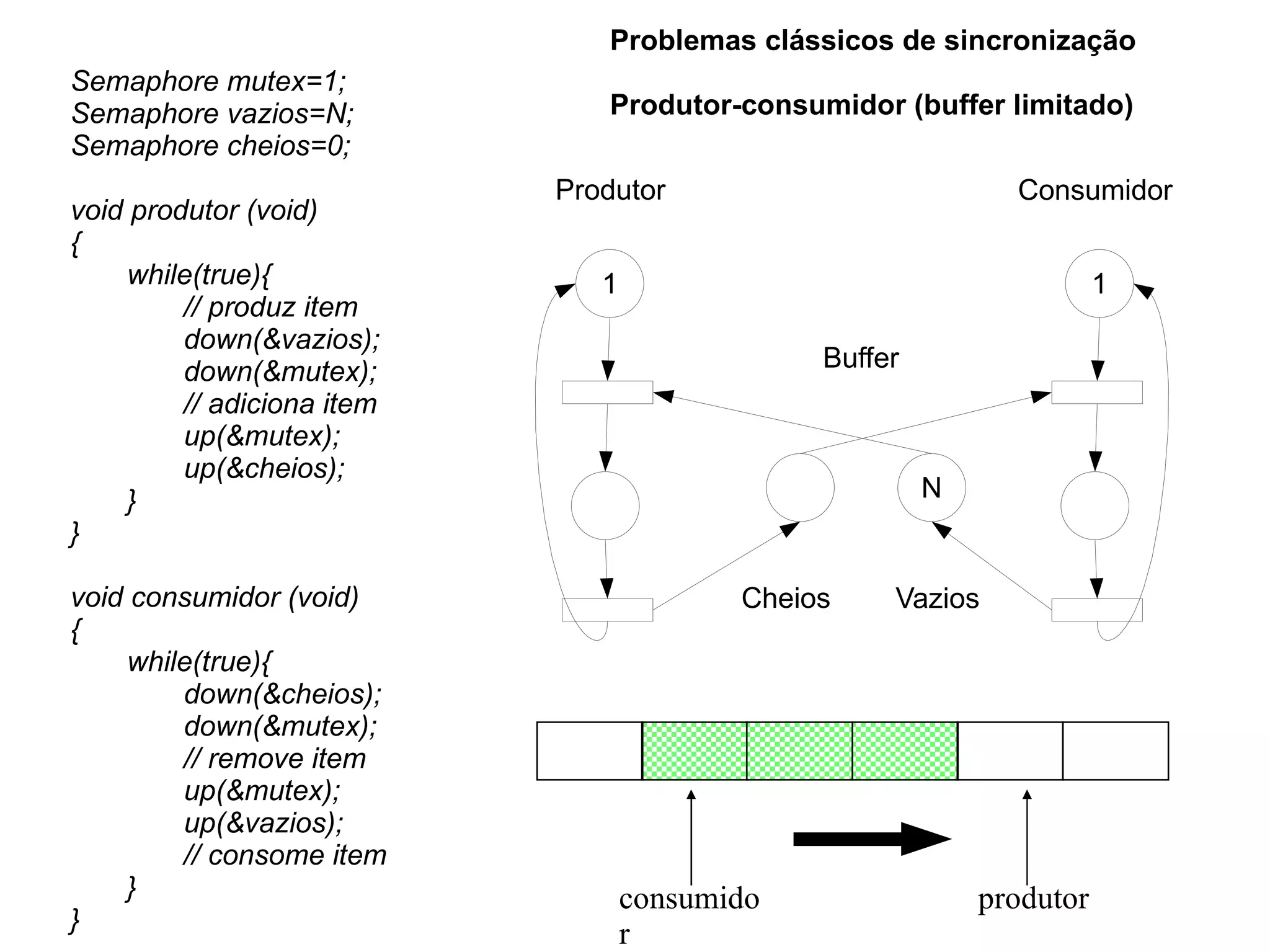

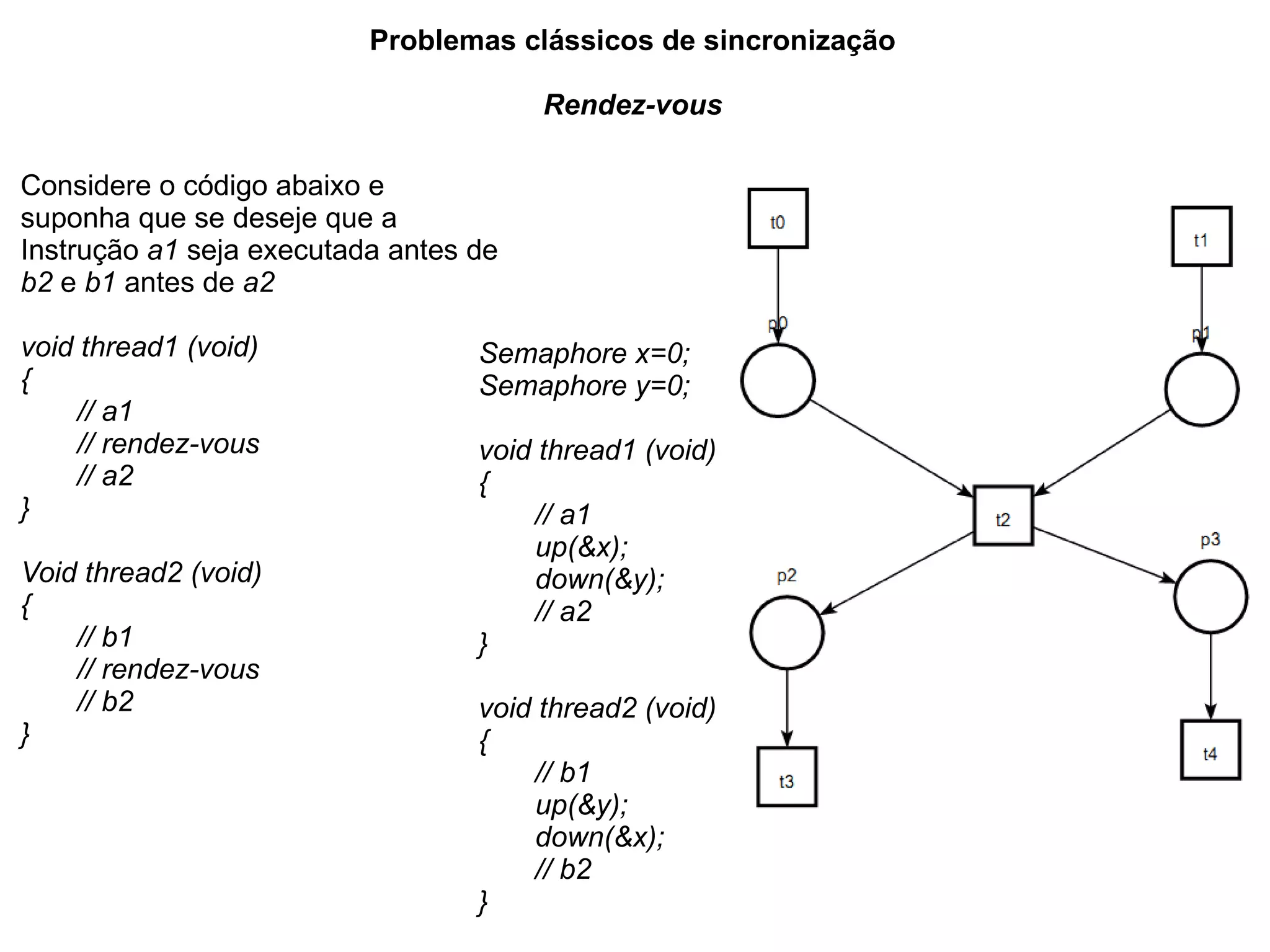

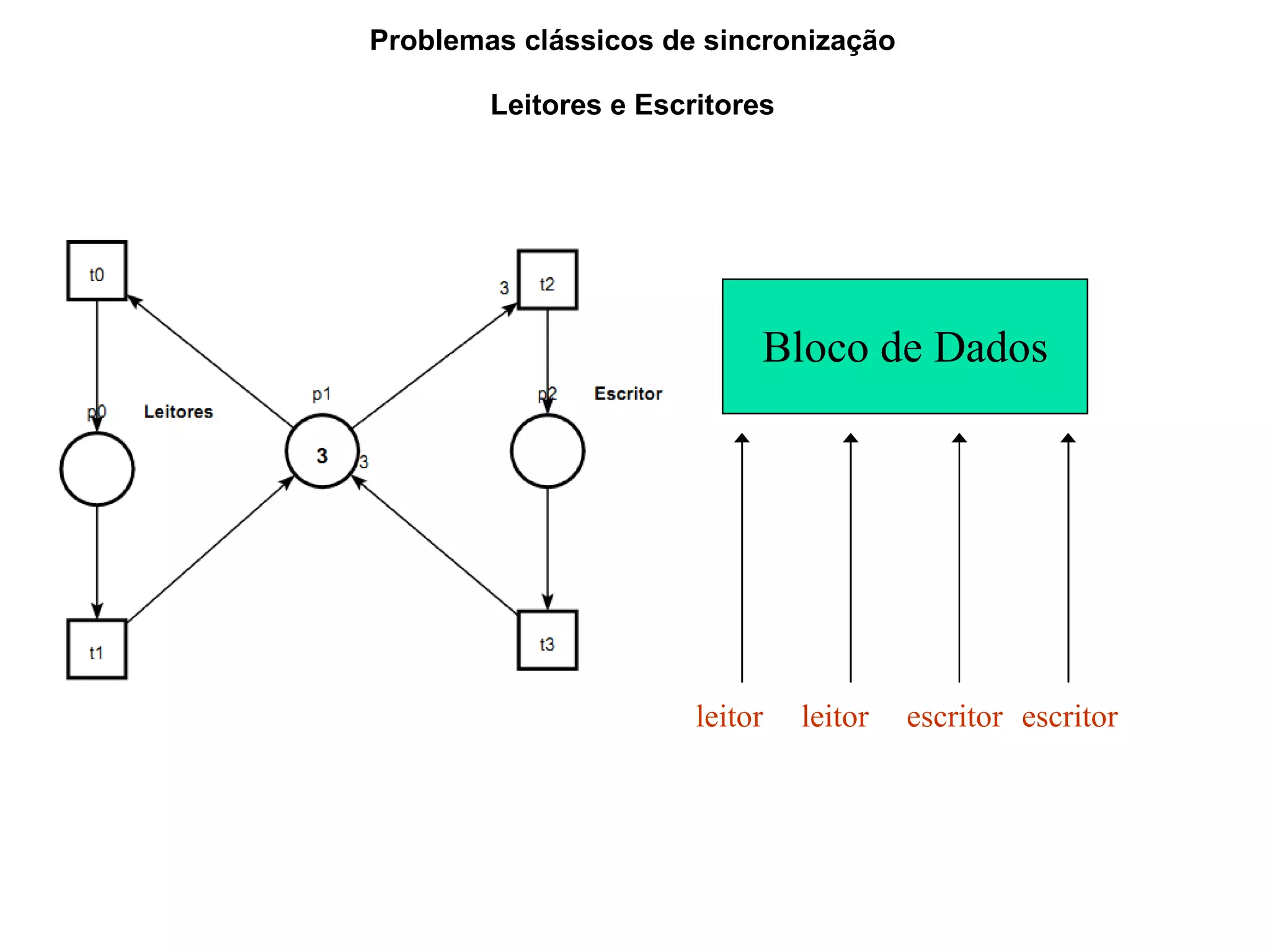

3) Problemas de concorrência como condições de disputa e regiões críticas devem ser resolvidos com técnicas como exclusão mútua e semáforos.