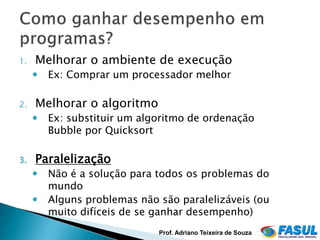

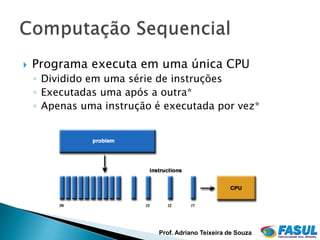

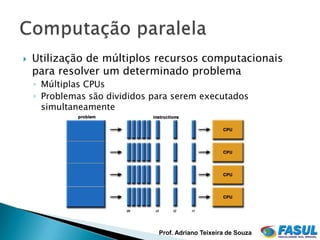

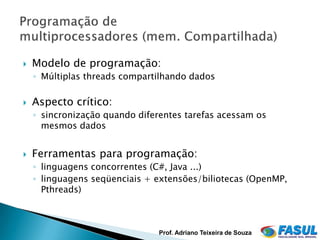

O documento discute computação paralela e como ganhar desempenho em programas. Explora três opções: melhorar o ambiente de execução, melhorar o algoritmo, ou paralelizar o programa. A paralelização envolve dividir um problema em partes que podem ser resolvidas simultaneamente usando múltiplos processadores ou núcleos.

![#include <omp.h>

#include <stdio.h> Exemplo OpenMP

#include <stdlib.h>

int main (int argc, char *argv[])

{

int nthreads, tid;

#pragma omp parallel private(nthreads, tid)

{

/* Obtain thread number */

tid = omp_get_thread_num();

printf("Hello World from thread = %dn", tid);

/* Only master thread does this */

if (tid == 0)

{

nthreads = omp_get_num_threads();

printf("Number of threads = %dn", nthreads);

}

} /* All threads join master thread and disband */

Prof. Adriano Teixeira de Souza](https://image.slidesharecdn.com/13-sd-computacaoparalela-intro-110709150051-phpapp01/85/Sistemas-Distribuidos-Computacao-Paralela-18-320.jpg)