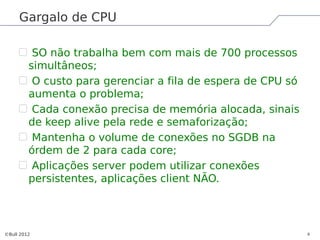

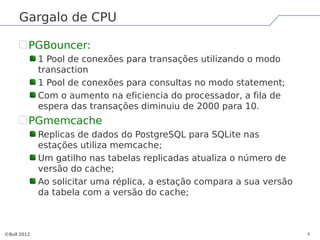

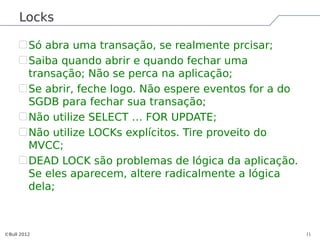

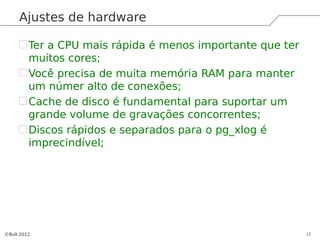

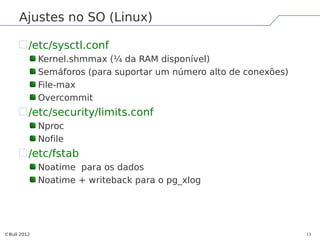

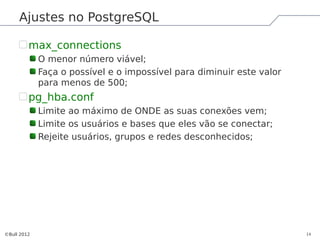

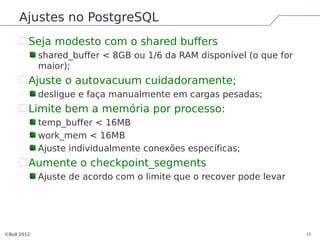

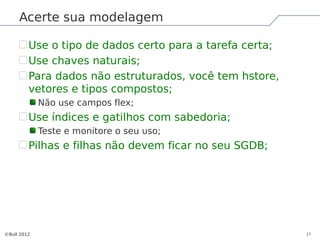

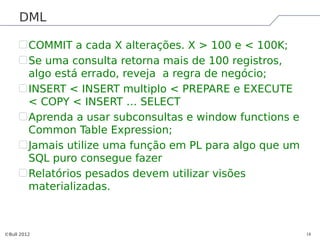

O documento discute estratégias para alta concorrência no PostgreSQL, incluindo ajustes de hardware, sistema operacional e configuração do banco de dados para suportar milhares de conexões simultâneas e crescimento de dados de vários GB por dia. Ele também fornece dicas sobre modelagem de dados, tratamento de transações e consultas para melhor desempenho.