Dslt祭り2夜

- 4. 誰 Twi,er ID: @siero5335 仕事: 化学物質曝露影響の解析 化学分析法の開発 専⾨: 環境化学、分析化学 興味: ⽣理活性物質の⼀⻫分析 関連分野へのデータ解析応⽤ hoxo-m末席 これまで触ってたデータはサンプルサイズn = 100前後 変数のほうが数が多いことが多い 今後n=1000-10000くらいのデータも扱うかも?

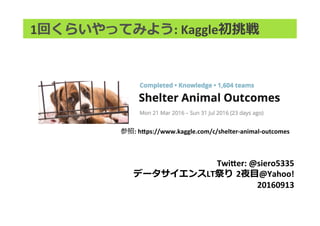

- 5. 背景: データセット 保健所に預けられたイヌ・ネコが どうなったか、どうなるかを予測 特徴量: 種、⾊、名前の有無、性別、年齢等 アウトカム: 他所への輸送、引取、死亡、安楽死、 飼い主への返却の5種 参照: h,ps://www.kaggle.com/c/shelter-animal-outcomes

- 6. 背景: なぜこのコンペ? 1: データが⼤きすぎない (解凍して3MB弱) サンプルサイズ数万オーダー 2: ちょうど本業のデカ⽬のデータセットと似た⼤きさ 3: 特徴量も本業と似てる → 何か得るものがあるだろうということで参加 参照: h,ps://www.kaggle.com/c/shelter-animal-outcomes

- 12. マエショリ

- 13. 前処理: やってみたこと これまで演者がやってきた解析は⼤抵 Excelでどうとでもなるデータがほとんど dplyrなどの使⽤経験も浅い → Kernelを写経・データの変化確認を繰り返して慣れる 参照: h,ps://www.kaggle.com/mrisdal/shelter-animal-outcomes/quick-dirty-randomforest

- 14. 前処理: やってみたこと これまで演者がやってきた解析は⼤抵 Excelでどうとでもなるデータがほとんど dplyrなどの使⽤経験も浅い → Kernelを写経・データの変化確認を繰り返して慣れる 慣れてきたら? ちょっと⼯夫してみる ex. LOFで検出された外れ値外す、 SMOTEでoutcomeの例数を揃える 参考図書 参照: h,ps://www.kaggle.com/mrisdal/shelter-animal-outcomes/quick-dirty-randomforest

- 15. 前処理: やってみたこと これまで演者がやってきた解析は⼤抵 Excelでどうとでもなるデータがほとんど dplyrなどの使⽤経験も浅い → Kernelを写経・データの変化確認を繰り返して慣れる 慣れてきたら? ちょっと⼯夫してみる ex. LOFで検出された外れ値外す、 SMOTEでoutcomeの例数を揃える 悲しいかな結果としてはどれも精度向上には寄与せず… 参考図書 参照: h,ps://www.kaggle.com/mrisdal/shelter-animal-outcomes/quick-dirty-randomforest

- 16. モデル

- 22. Enjoy!