Especialista em TI com vasta experiência em governança, programação, arquitetura, segurança e gerência de projetos

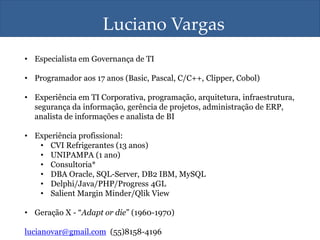

- 1. Luciano Vargas • Especialista em Governança de TI • Programador aos 17 anos (Basic, Pascal, C/C++, Clipper, Cobol) • Experiência em TI Corporativa, programação, arquitetura, infraestrutura, segurança da informação, gerência de projetos, administração de ERP, analista de informações e analista de BI • Experiência profissional: • CVI Refrigerantes (13 anos) • UNIPAMPA (1 ano) • Consultoria* • DBA Oracle, SQL-Server, DB2 IBM, MySQL • Delphi/Java/PHP/Progress 4GL • Salient Margin Minder/Qlik View • Geração X - “Adapt or die” (1960-1970) lucianovar@gmail.com (55)8158-4196

- 5. http://www.ibmbigdatahub.com/tag/587 velocidade, volume, variedade, veracidade (*valor)

- 6. Uma investigação, feita pela Universidade de Cambridge, que, após analisar as páginas do Facebook de 58 mil pessoas, descobriu que pessoas com alto Quociente de Inteligência apre- ciam a voz do actor Morgan Freeman. Ninguém sabe por quê. A análise do Big Data pode estabelecer uma correlação, mas não é capaz de apontar uma causa.

- 7. Moneyball, 2011. O filme é baseado no livro Moneyball: The Art of Winning an Unfair Game de Michael Lewis, que por sua vez é baseado na história verdadeira de Billy Beane, gerente geral do time de basebol do Oakland Athletics. Moneyball se foca nas tentativas de Beane de criar um time competitivo para a temporada de 2002 de Oakland, apesar da situação financeira desfavorável da equipe, usando uma sofisticada análise estatística dos jogadores. http://pt.wikipedia.org/wiki/Moneyball

- 9. http://www.baguete.com.br/noticias/29/10/2014/twitter-abre-dados-para-ibm “Segundo dados divulgados pela rede social esta semana, o Twitter conta com cerca de 284 milhões de usuários ativos.” “Em caso que vocês se estejam se perguntando porque diabos uma fabricante de fritadoras quer saber do Twitter, a resposta é que a companhia busca queixas sobre batata frita mal feita para poder despachar técnicos para o local.” “As empresas quiseram ter acesso ao que o consumidor está pensando desde sempre. Com esse acordo, já não será necessário inferir isso.”

- 10. Database X Escalabilidade (petabytes de dados, milhares de servidores) Flexibilidade para aceitar todos os formatos de dados (schema) Eficiência e tolerância a falhas transparente Hardware/software como commodity (inexpressivo) Performance (milhares de índices, tuning, dicionário, storage...) Regras ACID (Atomicidade, Consistência, Isolamento e Durabilidade) Tolerância a falhas não é transparente (não-simples) H/W extremamente significativo!

- 11. • Hadoop é um framework de software para processamento distribuído, paralelo e em grade - de dados gigantes em clusters de computadores • Qual o tamanho? • Datasets gigantes: Terabytes ou petabytes de dados • Clusters gigantes: centenas ou milhares de máquinas! • Implementação open-source do Google MapReduce • Utiliza um modelo de programação extremamente simples conhecido como “MapReduce” • É baseado em um modelo “único” de dados, capaz de armazenar qualquer tipo de informação • Alto nível de abstração tecnológica (ex: driver/S.O/protocolo, etc)

- 12. O framework Hadoop framework contém apenas duas camadas: • Distributed file system (HDFS) • Execution engine (MapReduce)

- 13. HDSF = Hadoop Distributed File System. Sistema de arquivos distribuído nativo, embutido na solução. Armazena e sincroniza grandes volumes de dados em hardware barato. Gigante: cada instância de um nó HDFS pode conter centenas ou milhares de máquinas, cada uma armazenando uma parte dos dados Replicação: os dados são replicados várias vezes (default é 3) Falhas: uma falha é um evento normal, não uma exceção Tolerância a falha: o processo de detecção de falhas é extremamente rápido, e promove recuperação automática (transparente). Essa característica é a mais importante da arquitetura HDFS Nós: cada nó é constantemente monitorado para detectar falhas

- 14. • Arquitetura de software introduzida pelo Google • É a combinação de dois processos chamados Map e Reduce • Implementa programação paralela e distribuída de forma transparente • No processo Map, o nó mestre recebe a informação, divide-a em subtarefas menores e distribui essas tarefas para nós funcionais. O nó funcional processa essa tarefa menor e devolve a resposta ao nó mestre. • No processo Reduce, o nó mestre recebe as respostas de todas as subtarefas e as combina de modo a obterem a saída, que é o resultado da tarefa original. • Vantagem: distribuição do processamento e tolerância a falhas • É altamente dependente do nó “mestre”, eficiente apenas para volumes de dados muito grandes

- 15. SGBD Distribuído Hadoop Modelo computacional - Controle de transações - Transação é a unidade de trabalho - Controle de tarefas - Tarefa é a unidade de trabalho Modelo de dados - Dados estruturados com esquema esquema conhecido - Operações Read/Write - Dados estruturados - Dados se encaixam em esquema “livre” - Operação ReadOnly - Dados estruturados ou não Custo - Servidores caros - Servidores baratos Tolerância a falhas - Falhas são raras - Mecanismos de recuperação - Falhas são comuns em milhares de máquinas - Tolerância a falhas simples, mas eficiente Características- chave - Eficiência, otimização, ajuste fino (tunning) - Escalabilidade, flexibilidade, tolerância a falhas Apache Hadoop Foundation - http://hadoop.apache.org/

- 16. • BigData favoreceu o cloud computing • Permite administrar o ambiente sem interrupções • Busca e mineração de muita informação em pouco tempo • Simplificou operações (tolerância a falhas/programação paralela) • Respostas para a coisa “internet” • Ferramenta sempre disponível • Oferece informações relevantes em tempo real • Mais informação, “menos” tecnologia Conclusão

- 17. Artigo: http://www.ibm.com/developerworks/br/linux/library/au- cloud_apache/ Yi Ming Huang, Software Engineer, IBM Zhao Hui Nie, Software Engineer, IBM Hitachi Data Systems, 2012 Hitachi Data Systems Hadoop Solution http://www.hds.com/solutions/big-data/ Apache Hadoop: conceitos teóricos e práticos, evolução e novas possibilidades Alfredo Goldman, Fabio Kon, Francisco Pereira Junior, Ivanilton Polato e Rosangela de Fátima Pereira Biblioteca Digital Brasileira de Computação: http://www.lbd.dcc.ufmg.br/bdbcomp/servlet/Trabalho?id=12577 Apache Hadoop Foundation http://hadoop.apache.org/ Big Data - Como Extrair Volume, Variedade, Velocidade e Valor da Avalanche de Informação Cotidiana. Autores: Cukier, KennethMayer-schönberger, Viktor Edt. CAMPUS, 2013